Các công cụ AI mang tính cách mạng và giờ đây có thể tổ chức những cuộc trò chuyện, tạo văn bản giống con người và tạo hình ảnh dựa trên một từ duy nhất. Tuy nhiên, dữ liệu đào tạo mà các công cụ AI này sử dụng thường đến từ những nguồn có bản quyền, đặc biệt là khi nói đến các công cụ biến văn bản thành hình ảnh như DALL-E, Midjourney và nhiều công cụ khác.

Việc ngăn chặn các công cụ Generative AI sử dụng hình ảnh có bản quyền để đào tạo là một điều khó khăn và những nghệ sĩ thuộc mọi tầng lớp xã hội đã phải vật lộn để bảo vệ tác phẩm của họ khỏi các bộ dữ liệu đào tạo AI. Nhưng giờ đây, tất cả đã thay đổi với sự ra đời của Nightshade, một công cụ AI miễn phí được thiết kế để "đầu độc" đầu ra của các công cụ Generative AI - và cuối cùng cho phép các nghệ sĩ lấy lại một số quyền lực.

AI Poisoning là gì?

AI Poisoning là hành động "đầu độc" tập dữ liệu huấn luyện của thuật toán AI. Điều này tương tự như việc cố tình cung cấp thông tin sai cho AI, dẫn đến AI được đào tạo gặp trục trặc hoặc không phát hiện được hình ảnh. Những công cụ như Nightshade thay đổi các pixel trong hình ảnh kỹ thuật số theo cách trông có vẻ hoàn toàn khác với quá trình đào tạo AI trên đó, nhưng phần lớn không thay đổi so với bản gốc đối với mắt người.

Ví dụ, nếu bạn upload hình ảnh một chiếc ô tô bị "nhiễm độc" lên Internet, con người chúng ta sẽ thấy nó không có gì thay đổi, nhưng một AI đang cố gắng tự đào tạo để nhận dạng ô tô bằng cách xem hình ảnh trên Internet sẽ thấy điều gì đó hoàn toàn khác.

Kích thước mẫu đủ lớn của những hình ảnh giả mạo hoặc bị nhiễm độc này trong dữ liệu huấn luyện của AI có thể làm hỏng khả năng tạo ra hình ảnh chính xác từ một lời nhắc nhất định do khả năng hiểu biết của AI về đối tượng bị tổn hại.

Vẫn còn một số câu hỏi về tương lai của Generative AI, nhưng việc bảo vệ tác phẩm kỹ thuật số gốc là ưu tiên hàng đầu. Điều này thậm chí có thể làm hỏng các phiên bản mô hình trong tương lai vì dữ liệu huấn luyện làm nền tảng cho mô hình không chính xác 100%.

Bằng cách sử dụng kỹ thuật này, những người sáng tạo kỹ thuật số không cho phép sử dụng hình ảnh của họ trong bộ dữ liệu AI có thể bảo vệ chúng khỏi bị đưa vào Generative AI mà không được phép. Một số nền tảng cung cấp cho người sáng tạo tùy chọn từ chối đưa tác phẩm nghệ thuật của họ vào bộ dữ liệu đào tạo AI. Tuy nhiên, trước đây, những danh sách chọn không tham gia như vậy đã bị các nhà đào tạo mô hình AI bỏ qua và tiếp tục bị ngó lơ mà không gây ra hậu quả gì.

So với các công cụ bảo vệ tác phẩm nghệ thuật kỹ thuật số khác như Glaze, Nightshade có tính phản cảm. Glaze ngăn các thuật toán AI bắt chước phong cách của một hình ảnh cụ thể, trong khi Nightshade thay đổi giao diện của hình ảnh thành AI. Cả hai công cụ đều được xây dựng bởi Ben Zhao, Giáo sư ngành Khoa học Máy tính tại Đại học Chicago.

Cách sử dụng Nightshade

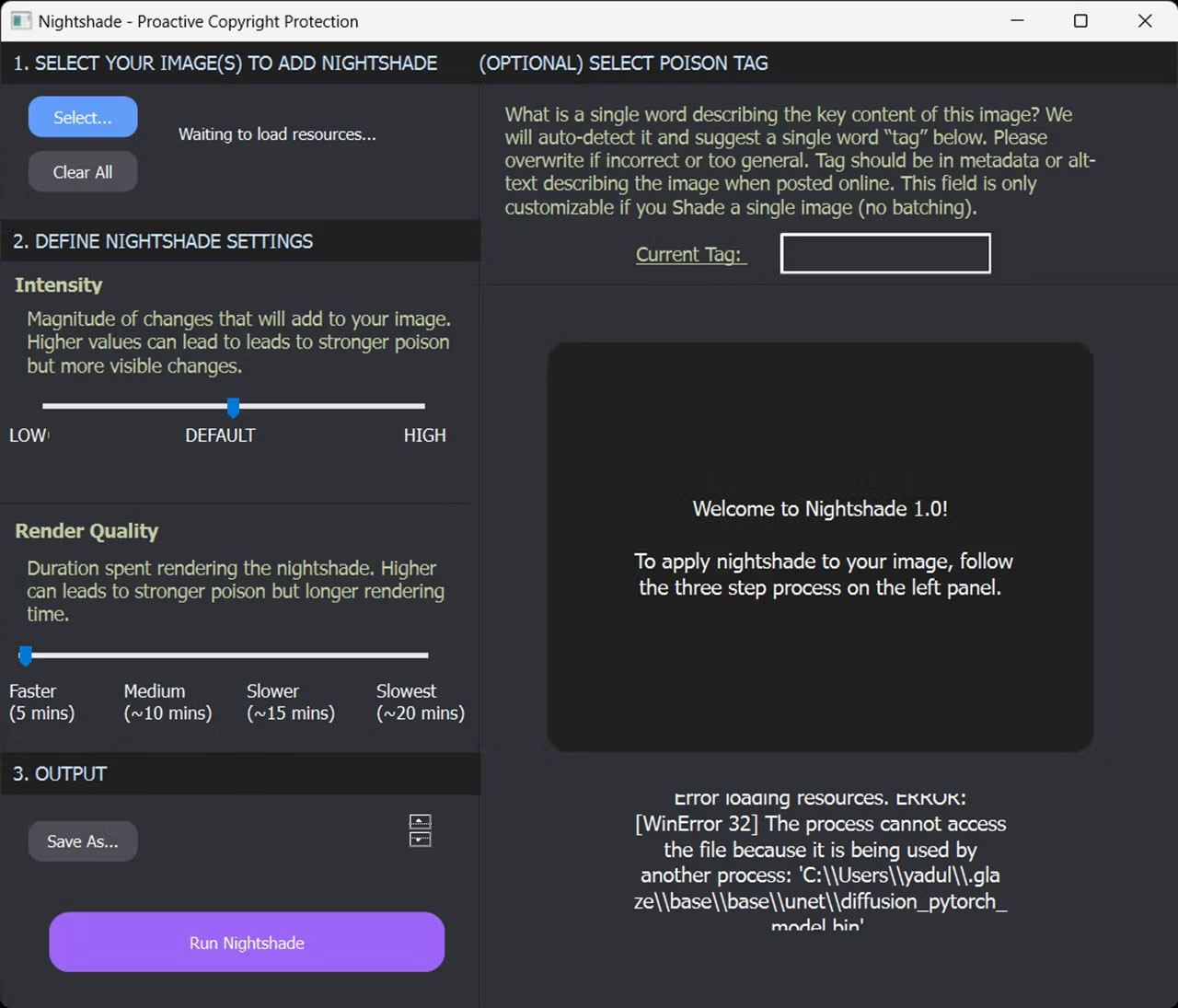

Mặc dù người tạo ra công cụ này khuyến nghị nên sử dụng Nightshade cùng với Glaze nhưng nó cũng có thể được sử dụng như một công cụ độc lập để bảo vệ tác phẩm nghệ thuật của bạn. Việc sử dụng công cụ này cũng khá dễ dàng vì chỉ có 3 bước để bảo vệ hình ảnh của bạn bằng Nightshade.

Tuy nhiên, có một số điều bạn cần lưu ý trước khi bắt đầu.

- Nightshade chỉ khả dụng cho Windows và MacOS với sự hỗ trợ GPU hạn chế và yêu cầu tối thiểu 4GB VRAM. Hiện tại, GPU không phải của Nvidia và máy Mac Intel không được hỗ trợ. Đây là danh sách các GPU Nvidia được hỗ trợ theo team Nightshade (GPU GTX và RTX được tìm thấy trong phần "CUDA-Enabled GeForce and TITAN Products"). Ngoài ra, bạn có thể chạy Nightshade trên CPU của mình, nhưng nó sẽ khiến hiệu suất chậm hơn.

- Nếu bạn có GTX 1660, 1650 hoặc 1550, một lỗi trong thư viện PyTorch có thể khiến bạn không thể khởi chạy hoặc sử dụng Nightshade đúng cách. Team Nightshade có thể khắc phục nó trong tương lai bằng cách chuyển từ PyTorch sang Tensorflow, nhưng hiện tại không có cách giải quyết nào. Vấn đề cũng mở rộng đến các biến thể Ti của những card này. Tác giả bài viết đã khởi chạy chương trình bằng cách cấp quyền truy cập admin trên PC chạy Windows 11 của mình và đợi vài phút để chương trình mở. Mọi thứ có thể thay đổi trong trường hợp của bạn.

- Nếu tác phẩm nghệ thuật của bạn có nhiều hình khối hoặc hình nền màu đơn (solid), bạn có thể gặp phải một số hiện tượng kỳ lạ. Điều này có thể được khắc phục bằng cách sử dụng cường độ "đầu độc" thấp hơn.

Về việc bảo vệ hình ảnh của bạn bằng Nightshade, đây là những gì bạn cần làm. Hãy nhớ rằng hướng dẫn này sử dụng phiên bản Windows nhưng các bước tương tự cũng áp dụng cho phiên bản macOS.

1. Tải xuống phiên bản Windows hoặc macOS từ trang tải xuống Nightshade.

2. Nightshade tải xuống dưới dạng thư mục lưu trữ mà không cần cài đặt. Sau khi quá trình tải xuống hoàn tất, hãy giải nén thư mục ZIP và nhấp đúp vào Nightshabde.exe để chạy chương trình.

3. Chọn hình ảnh bạn muốn bảo vệ bằng cách nhấp vào nút Select ở trên cùng bên trái. Bạn cũng có thể chọn nhiều hình ảnh cùng một lúc để xử lý hàng loạt.

4. Điều chỉnh các nút Intensity và Render Quality theo sở thích của bạn. Giá trị cao hơn làm tăng thêm mức độ nhiễm độc mạnh hơn nhưng cũng có thể gây ra hiện tượng giả trong hình ảnh đầu ra.

5. Tiếp theo, nhấp vào nút Save As trong phần Output để chọn đích cho file đầu ra.

6. Nhấp vào nút Run Nightshade ở phía dưới để chạy chương trình và đầu độc hình ảnh của bạn.

Tùy chọn: Ngoài ra, bạn cũng có thể chọn một poison tag. Nightshade sẽ tự động phát hiện và đề xuất một thẻ từ đơn nếu bạn không làm như vậy, nhưng bạn có thể thay đổi thẻ đó nếu thẻ đó không chính xác hoặc quá chung chung. Hãy nhớ rằng cài đặt này chỉ khả dụng khi bạn xử lý một hình ảnh trong Nightshade.

Nếu mọi việc suôn sẻ, bạn sẽ có được một hình ảnh trông giống hệt ảnh gốc đối với mắt người nhưng hoàn toàn thay đổi với thuật toán AI, việc này giúp bảo vệ tác phẩm nghệ thuật của bạn khỏi Generative AI.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Thương mại Điện tử

Thương mại Điện tử  Nhạc, phim, truyện online

Nhạc, phim, truyện online  Phần mềm học tập

Phần mềm học tập

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài