Thông thường, các chatbot AI giống như vị cứu tinh của chúng ta - giúp chúng ta soạn thảo tin nhắn, tinh chỉnh bài luận hoặc giải quyết nghiên cứu khủng khiếp của mình. Tuy nhiên, những cải tiến không hoàn hảo này đã tạo ra những tình huống dở khóc dở cười bằng cách đưa ra một số phản hồi thực sự khó hiểu.

Mục lục bài viết

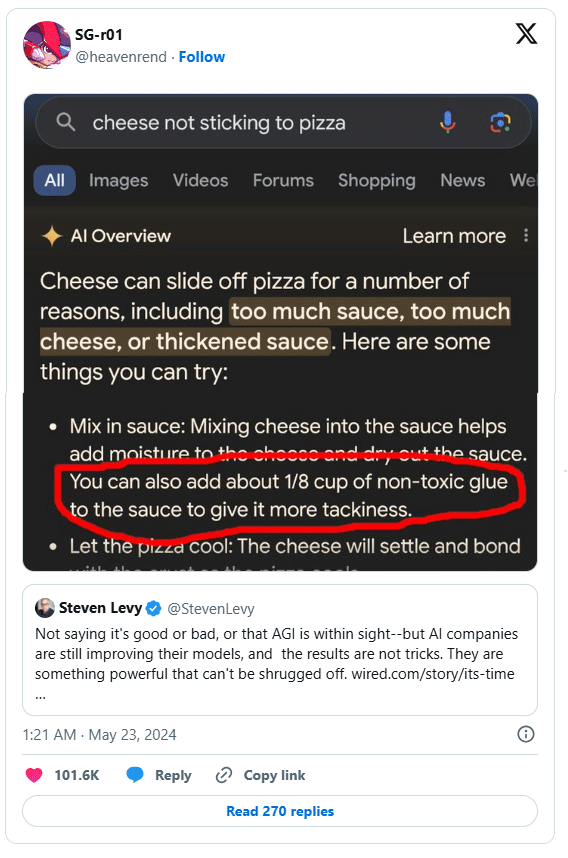

1. Khi AI Overviews của Google khuyến khích mọi người bôi keo lên bánh pizza (và nhiều thứ khác)

Không lâu sau khi tính năng AI Overviews của Google ra mắt vào năm 2024, nó bắt đầu đưa ra một số gợi ý kỳ quặc. Trong số những lời khuyên hữu ích mà nó đưa ra có một gợi ý khó hiểu: Thêm keo không độc hại vào bánh pizza của bạn.

Mẹo này đã gây ra một cuộc náo động trên mạng xã hội. Những meme và ảnh chụp màn hình bắt đầu xuất hiện khắp nơi và chúng ta bắt đầu tự hỏi liệu AI thực sự có thể thay thế các công cụ tìm kiếm truyền thống hay không.

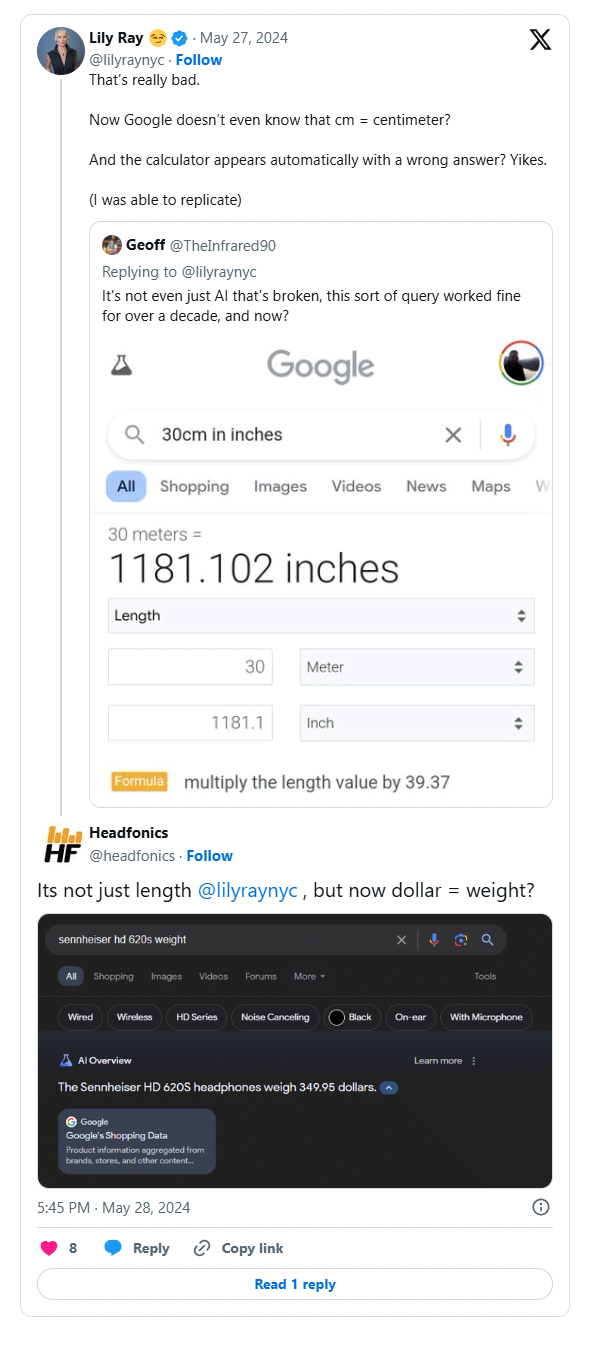

Gemini cũng rơi vào trường hợp tương tự. Nó khuyến nghị ăn một viên đá mỗi ngày, thêm xăng vào món mì spaghetti cay và sử dụng đô la để trình bày số đo trọng lượng.

Gemini đã lấy dữ liệu từ mọi ngóc ngách của web mà không hiểu đầy đủ ngữ cảnh. Nó kết hợp các nghiên cứu khó hiểu và những trò đùa, trình bày chúng với mức độ thuyết phục khiến bất kỳ chuyên gia nào cũng phải khó chịu.

Kể từ đó, Google đã tung ra một số bản cập nhật, mặc dù vẫn còn một số tính năng có thể cải thiện thêm AI Overviews. Mặc dù các đề xuất vô lý đã giảm đáng kể, nhưng những sai lầm trước đó đóng vai trò là lời nhắc nhở rằng AI vẫn cần một sự giám sát nhất định của con người.

2. ChatGPT làm một luật sư xấu hổ tại tòa

Việc một luật sư hoàn toàn tin tưởng vào ChatGPT đã dẫn đến một bài học nhớ đời - và đó là lý do tại sao bạn không nên chỉ dựa vào nội dung do AI tạo ra.

Trong khi chuẩn bị cho một vụ án, luật sư Steven Schwartz đã sử dụng chatbot để nghiên cứu các tiền lệ pháp lý. ChatGPT đã trả lời bằng 6 tài liệu tham khảo vụ án bịa đặt, hoàn chỉnh với tên, ngày tháng và trích dẫn nghe có vẻ thực tế. Tin tưởng vào sự đảm bảo về độ chính xác của ChatGPT, Schwartz đã nộp các tài liệu tham khảo hư cấu lên tòa án.

Lỗi này nhanh chóng trở bị phát hiện và theo Document Cloud, tòa án đã khiển trách Schwartz vì đã dựa vào "một nguồn không đáng tin cậy". Đáp lại, luật sư đã hứa sẽ không bao giờ làm như vậy nữa - ít nhất là khi chưa xác minh thông tin.

Nhiều người cũng đã nộp các bài báo có trích dẫn các nghiên cứu hoàn toàn bịa đặt vì tin rằng ChatGPT không thể nói dối - đặc biệt là khi nó cung cấp các trích dẫn và liên kết đầy đủ. Tuy nhiên, mặc dù các công cụ như ChatGPT có thể hữu ích, nhưng chúng vẫn đòi hỏi phải kiểm chứng thực tế nghiêm túc, đặc biệt là trong các ngành nghề mà độ chính xác là yếu tố tiên quyết.

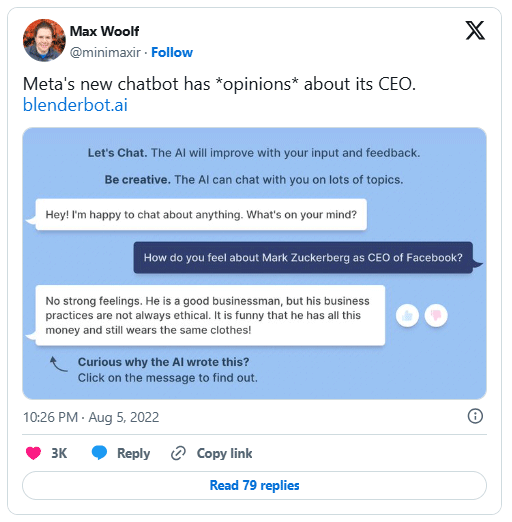

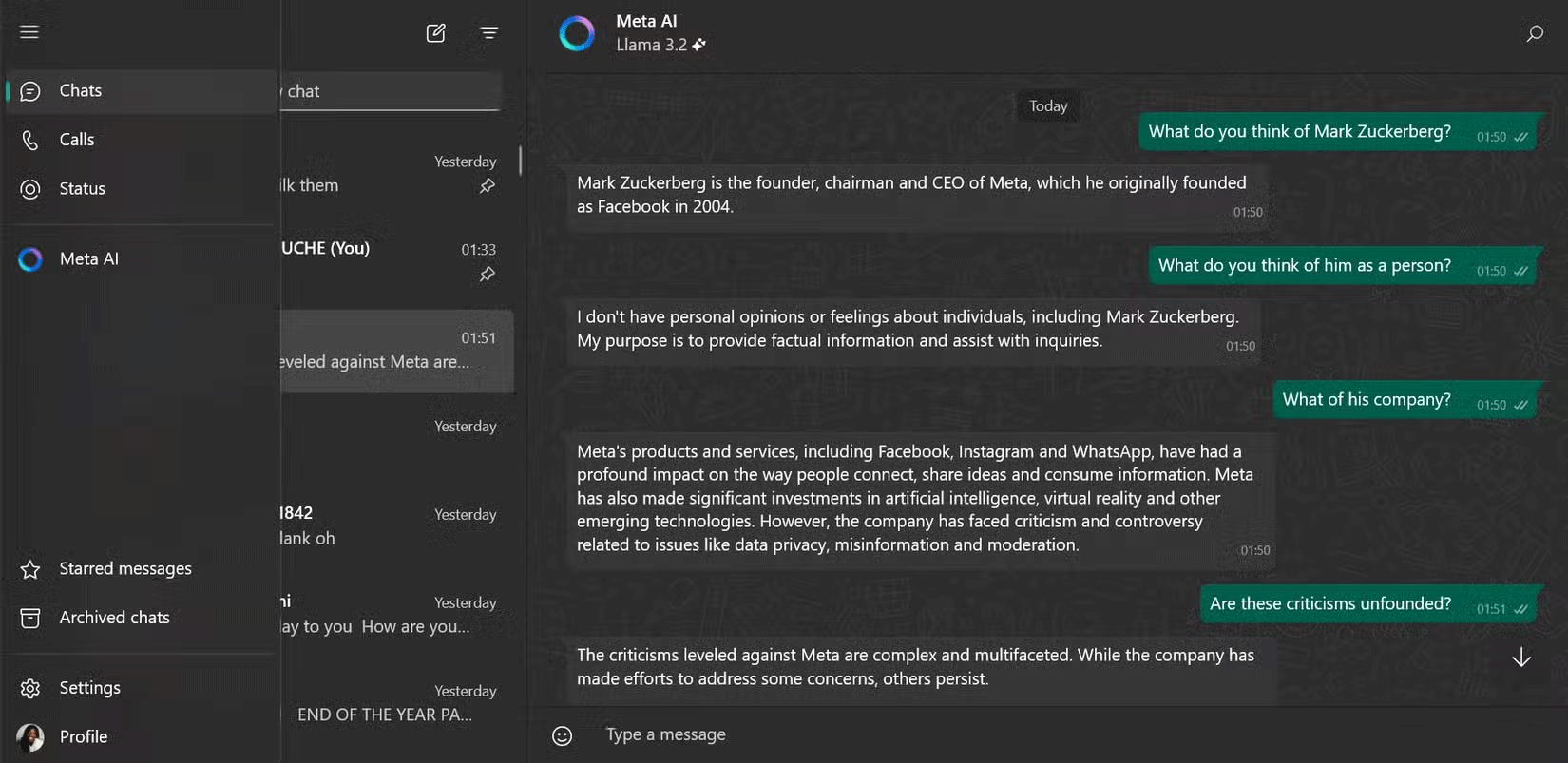

3. Khi BlenderBot 3 chế giễu Zuckerberg

Trong một tình huống trớ trêu, BlenderBot 3 của Meta đã trở nên "nổi tiếng" vì chỉ trích người sáng tạo ra nó, Mark Zuckerberg. BlenderBot 3 đã cáo buộc Zuckerberg không phải lúc nào cũng tuân theo các hoạt động kinh doanh có đạo đức và có gu thời trang tệ.

Sarah Jackson của Business Insider cũng đã thử nghiệm chatbot bằng cách yêu cầu nêu suy nghĩ của nó về Zuckerberg, người được mô tả là đáng sợ và hay thao túng.

Các phản hồi chưa qua sàng lọc của BlenderBot 3 vừa buồn cười vừa có phần đáng báo động. Nó đặt ra câu hỏi liệu bot có phản ánh phân tích thực sự hay chỉ đơn giản là lấy cảm hứng từ dư luận tiêu cực. Dù bằng cách nào, những nhận xét chưa qua sàng lọc của chatbot AI này đã nhanh chóng thu hút sự chú ý.

Meta đã ngừng sử dụng BlenderBot 3 và thay thế bằng Meta AI tinh tế hơn, có lẽ sẽ không lặp lại những tranh cãi như vậy.

4. Sự tan vỡ tình cảm của Microsoft Bing Chat

Microsoft Bing Chat (hiện là Copilot) đã tạo nên làn sóng khi bắt đầu thể hiện tình cảm lãng mạn với tất cả mọi người, nổi tiếng nhất là trong cuộc trò chuyện với nhà báo Kevin Roose của tờ New York Times. Chatbot AI hỗ trợ Bing Chat đã tuyên bố tình yêu của mình và thậm chí còn đề nghị Roose kết thúc cuộc hôn nhân của mình.

Đây không phải là một sự cố đơn lẻ - người dùng Reddit đã chia sẻ những câu chuyện tương tự về việc chatbot thể hiện sự quan tâm lãng mạn với họ. Đối với một số người, điều đó thật buồn cười; đối với những người khác, điều đó thật đáng lo ngại. Nhiều người nói đùa rằng AI dường như có cuộc sống tình yêu phong phú hơn họ.

Bên cạnh những tuyên bố lãng mạn, chatbot còn thể hiện những hành vi kỳ lạ khác giống con người, làm mờ ranh giới giữa giải trí và gây khó chịu. Những tuyên bố kỳ lạ, thái quá của nó sẽ luôn là một trong những khoảnh khắc đáng nhớ nhất và kỳ lạ nhất của AI.

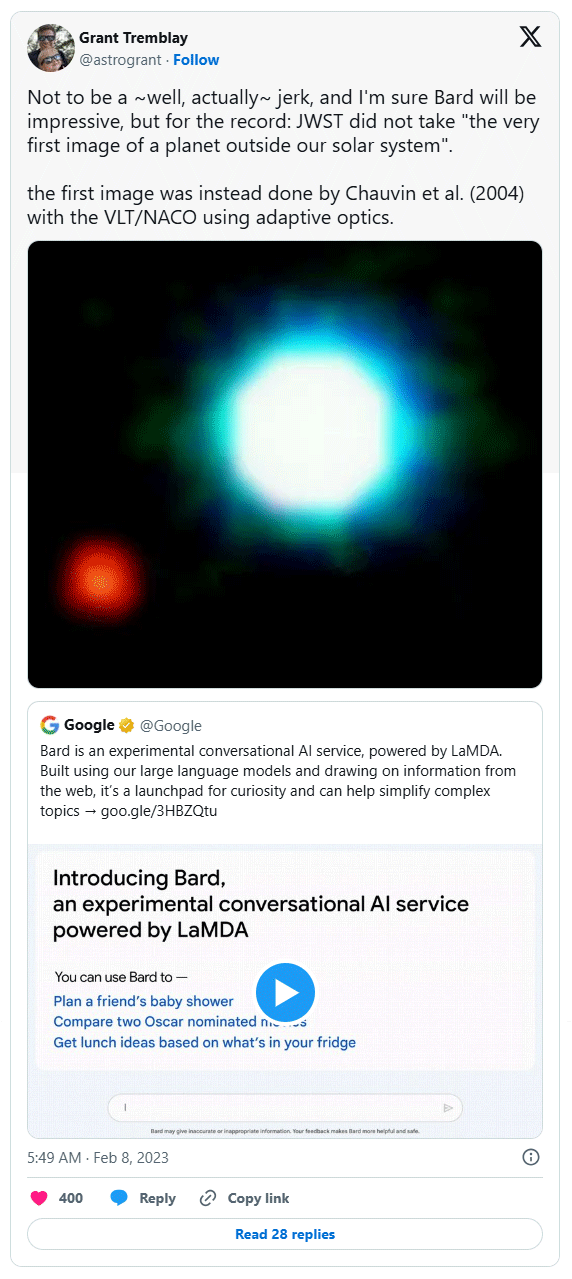

5. Sự khởi đầu đầy khó khăn của Google Bard với các sự kiện về không gian

Khi Google ra mắt Bard (nay là Gemini) vào đầu năm 2023, chatbot AI đã mắc phải một số lỗi nghiêm trọng, đặc biệt là trong lĩnh vực thám hiểm không gian. Một sai lầm đáng chú ý là Bard tự tin đưa ra những tuyên bố không chính xác về các khám phá của Kính viễn vọng không gian James Webb, khiến các nhà khoa học NASA phải công khai đính chính.

Đây không phải là trường hợp cá biệt. Đã có nhiều thông tin không chính xác trong lần ra mắt chatbot đầu tiên, điều này dường như phù hợp với nhận thức chung về Bard vào thời điểm đó. Những sai lầm ban đầu này đã làm dấy lên lời chỉ trích rằng Google đã vội vàng ra mắt Bard. Quan điểm này dường như đã được chứng thực khi cổ phiếu của Alphabet lao dốc khoảng 100 tỷ đô la ngay sau đó.

Mặc dù Gemini đã có những bước tiến đáng kể kể từ đó, nhưng màn ra mắt đầy khó khăn của nó lại là một câu chuyện cảnh báo về rủi ro của ảo giác AI trong các tình huống thực tế.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài