Nhiều người đã trả 20 USD/tháng cho Perplexity AI Pro trong gần một năm nay. Họ thấy mức giá đó hợp lý vì họ nhận được khả năng tìm kiếm web theo thời gian thực, nguồn trích dẫn và giao diện web được trau chuốt, giúp việc nghiên cứu trở nên dễ dàng hơn. Nhưng xét đến việc có những ứng dụng cho phép bất kỳ ai cũng có thể tận hưởng lợi ích của một LLM cục bộ, nhiều người nhận thấy mình có thể thay thế Perplexity bằng một hệ thống LLM cục bộ cho phần lớn các tác vụ của mình.

Đây không phải là sự bác bỏ hoàn toàn các dịch vụ đám mây. Perplexity vẫn vượt trội trong việc tìm kiếm web theo thời gian thực và tổng hợp nhiều nguồn ngay lập tức. Nhưng khi xét đến các tác vụ hàng ngày - xem xét code, viết tài liệu, phân tích dữ liệu, khắc phục sự cố kỹ thuật - thiết lập cục bộ mang lại kết quả nhanh chóng, riêng tư và ngày càng hiệu quả hơn mà không tốn một xu nào.

Lý do xây dựng thiết lập LLM cục bộ

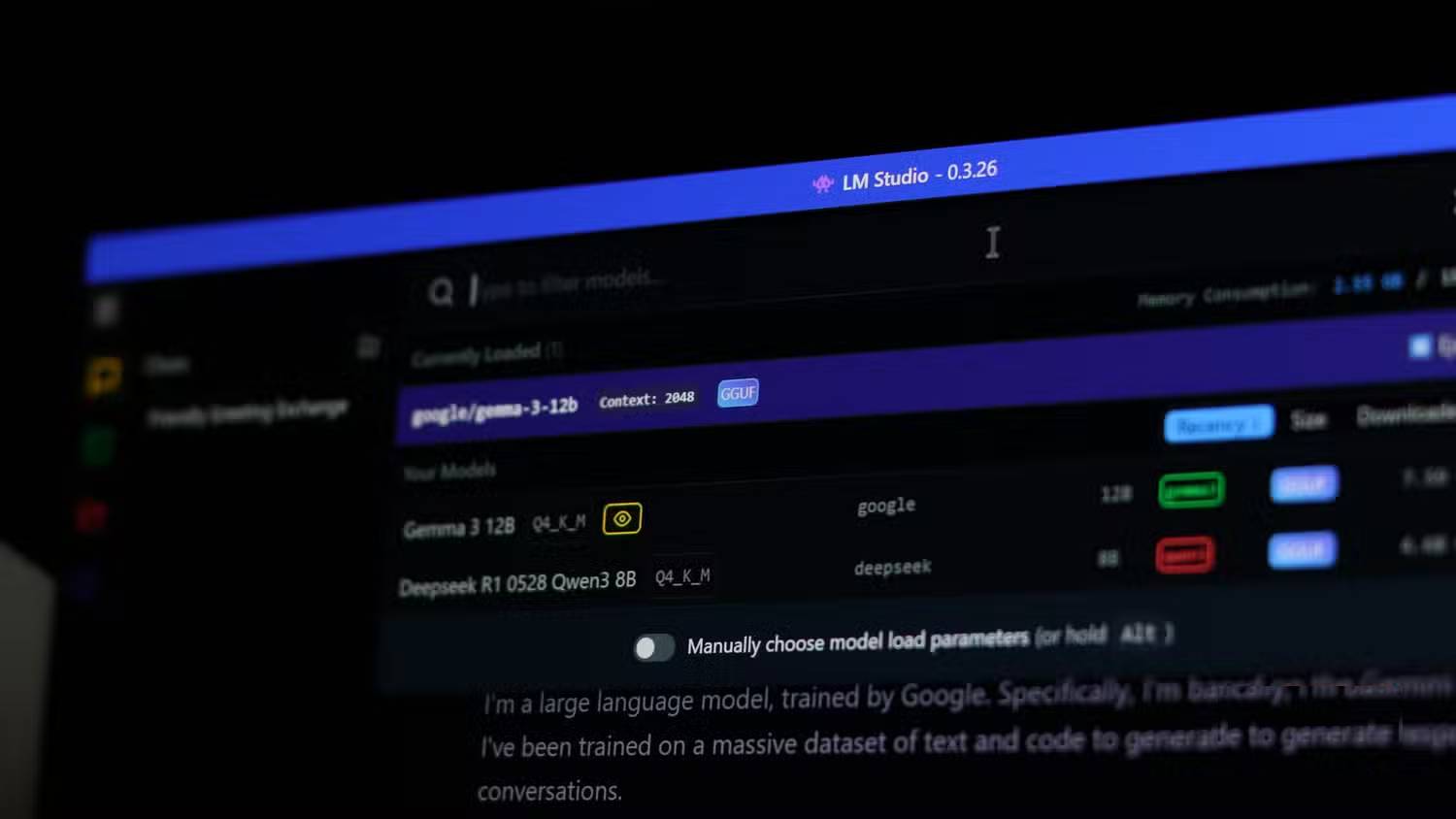

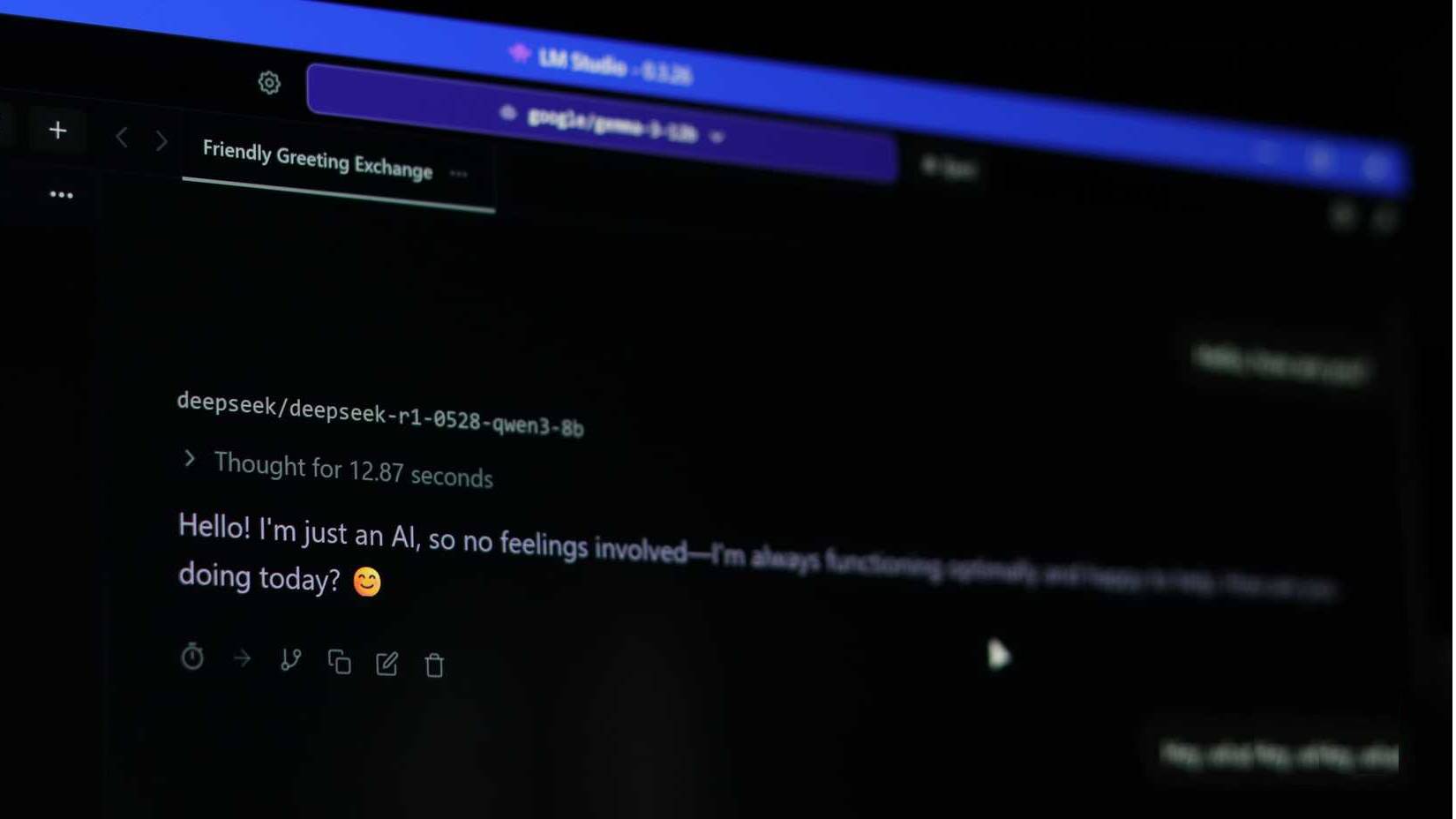

Hành trình khám phá hệ thống LLM cục bộ bắt đầu với Ollama. Đây là một công cụ mã nguồn mở đã trở thành tiêu chuẩn để chạy các hệ thống LLM cục bộ. Việc cài đặt trên Windows cũng chỉ mất vài phút. Sau đó, kết hợp nó với LM Studio làm giao diện người dùng đồ họa (GUI), mặc dù bạn cũng có thể sử dụng nó như một ứng dụng AI độc lập. Có rất nhiều ứng dụng khác mà bạn có thể sử dụng để tận hưởng lợi ích của AI cục bộ, vì vậy hãy chọn ứng dụng bạn thích.

Phần cứng cũng không phải là hàng đầu. Một số người đang sử dụng laptop với card đồ họa RTX 4060 8GB, bộ nhớ LPDDR5X 16GB và bộ xử lý Intel Core Ultra 7. Phần cứng này sẽ không cho bạn kết quả tức thì hoặc cho phép bạn chạy các mô hình cao cấp, nhưng nó đủ để chạy những mô hình như Qwen 2.5 Coder 32B khá tốt.

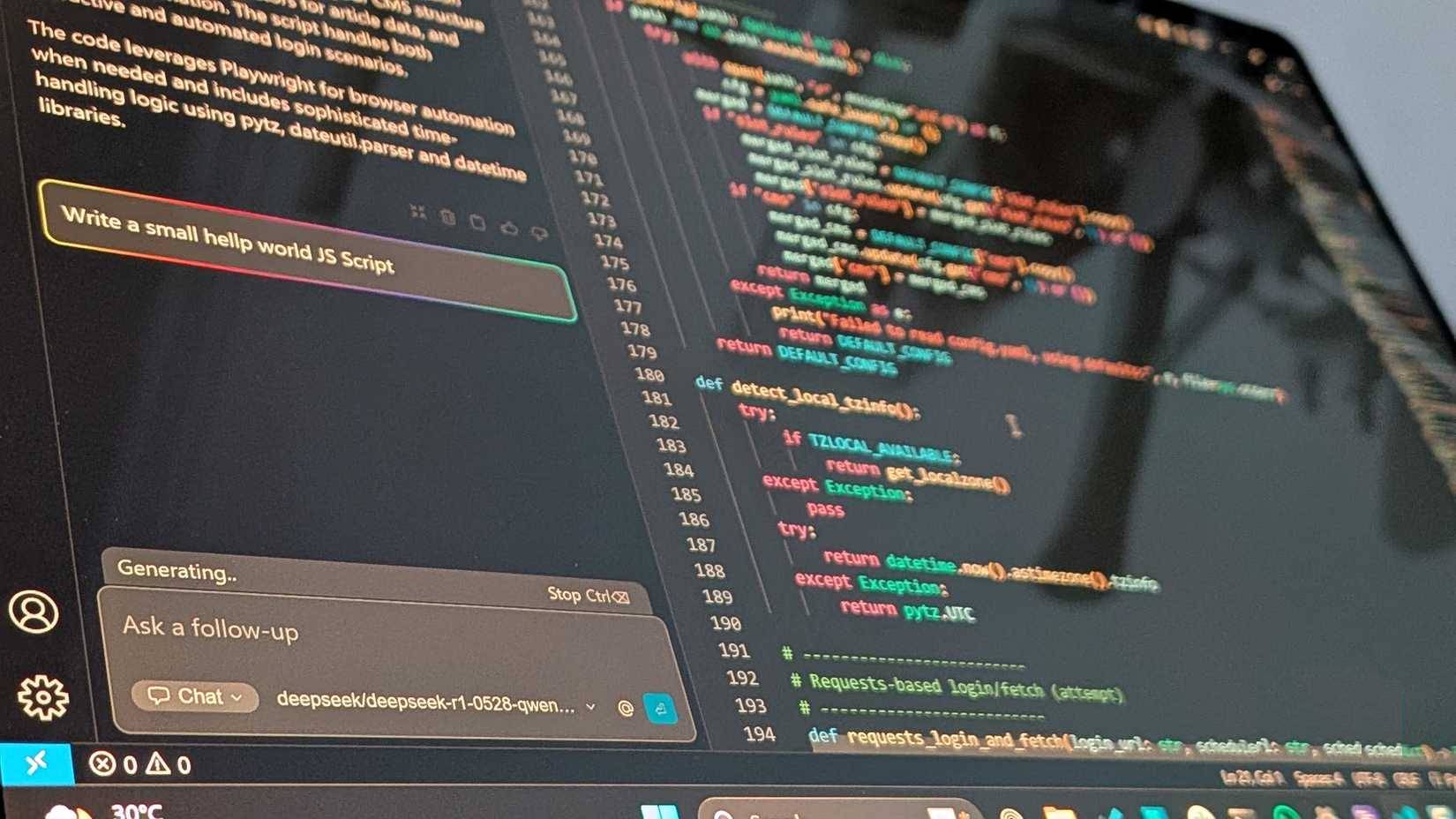

Nhân tiện, nhiều người đang sử dụng mô hình nói trên được lượng tử hóa đến độ chính xác 4 bit. Nó chạy mượt mà trên 8 GB VRAM và tạo ra code với tốc độ 25 đến 30 token mỗi giây. Nó hỗ trợ Python, VBA, PowerShell và hầu hết mọi ngôn ngữ lập trình khác mà bạn cần. Mô hình cũng có thể giải thích code cũ với cửa sổ ngữ cảnh 128k token.

Đối với các tác vụ thông thường, hãy luân phiên sử dụng mô hình Llama 3.1 70B và DeepSeek R1 đã được tinh chỉnh. Khoảng cách về chất lượng cũng đã giảm đáng kể. Điều này có nghĩa là bạn có thể đạt được hiệu suất GPT-4 trên phần cứng tiêu dùng với chi phí thấp hơn nhiều so với điện toán đám mây khi tự host.

Nơi các mô hình LLM cục bộ hoàn toàn vượt trội so với Perplexity

Quyền riêng tư, quyền kiểm soát và không giới hạn tốc độ

Quyền riêng tư là lợi ích tức thời. Mọi dòng code độc quyền đều nằm trên máy của bạn. Không có nhật ký dịch vụ của bên thứ ba cho các truy vấn. Đối với các ngành có yêu cầu về nơi lưu trữ dữ liệu như chăm sóc sức khỏe, pháp luật và tài chính, điều này loại bỏ những rắc rối về tuân thủ HIPAA hoặc GDPR.

Chi phí cũng đóng một vai trò lớn. Ví dụ, laptop của một người có giá khoảng 1.600 USD khi mua mới. Đó là 80 tháng sử dụng Perplexity Pro, và cho phép làm hầu hết mọi thứ khác với cùng mức giá đó. Bạn cũng có thể chạy các truy vấn mà nếu sử dụng API đám mây sẽ tốn hàng trăm đô la mỗi tháng.

Khả năng hoạt động ngoại tuyến nghe có vẻ tầm thường cho đến khi cần thiết. Bạn có thể truy cập AI của mình mọi lúc, mọi nơi mà không cần kết nối Internet ổn định. Bạn sẽ không gặp rắc rối về kết nối, không bị giới hạn tốc độ Wi-Fi, không bị giới hạn dung lượng sử dụng.

Hiệu suất không phải là điều kỳ diệu

Những điểm tốt, điểm xấu và vấn đề ngốn GPU

Các LLM cục bộ chậm hơn về mặt tuyệt đối. Phiên bản Qwen 2.5 tạo ra từ 25 đến 30 token mỗi giây, gần bằng một nửa so với GPT-4 dựa trên đám mây.

Nhưng đối với quy trình làm việc cụ thể, điều này hiếm khi quan trọng. Khi xem xét code hoặc soạn thảo tài liệu, đừng chờ đợi mô hình. Nút thắt cổ chai ở đây là khả năng hiểu của bạn, chứ không phải là việc tạo token. Một phản hồi 25 token mỗi giây cho một lời giải thích 500 token sẽ khiến các LLM cục bộ mất thêm vài phút so với bình thường.

Độ trễ cũng cho thấy một câu chuyện khác. Các dịch vụ đám mây có thể gây ra sự chậm trễ về mặt chi phí mạng. Mặt khác, AI cục bộ hoàn thành công việc ngay lập tức. Đối với hỗ trợ lập trình tương tác với khả năng lặp lại nhanh chóng, khả năng phản hồi đó rất tuyệt vời. Đây cũng là những lợi ích mà bạn nhận được khi tạo ra một AI lập trình cục bộ cho VS Code.

Những điểm mà Perplexity có ưu thế rõ rệt

Tìm kiếm web trực tiếp là điều bạn sẽ thiếu nhất

Tìm kiếm web thời gian thực vẫn là tính năng tốt nhất của Perplexity. Khi cần các yêu cầu quy định hiện hành, tài liệu API gần đây hoặc tổng hợp với những trích dẫn trong vài giây. Bạn có thể sử dụng nhiều chatbot miễn phí để không phải trả tiền cho AI, nhưng Perplexity rất khó thay thế.

Các hệ thống LLM cục bộ có thể thực hiện tìm kiếm web với tích hợp WebUI mở, nhưng độ phức tạp thiết lập tăng lên đáng kể. Perplexity cũng xử lý các tác vụ đa phương thức tốt hơn, hỗ trợ phân tích hình ảnh và xử lý tài liệu thông qua GPT-4 Vision và Claude 3. Thiết lập cục bộ hoạt động tốt với văn bản nhưng yêu cầu các công cụ riêng biệt cho hình ảnh, tùy thuộc vào phương tiện của bạn.

Vấn đề ảo giác cần được đề cập. Perplexity có thể đưa ra thông tin không chính xác mặc dù có trích dẫn. Các hệ thống LLM cục bộ cũng gặp phải tình trạng ảo giác, nhưng nếu không có kiểm tra thực tế theo thời gian thực, việc phát hiện lỗi đòi hỏi sự cảnh giác cao hơn.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài