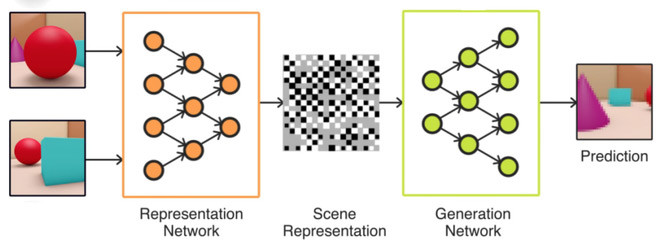

DeepMind, một công ty của Google có trụ sở tại Anh mới đây đã phát triển ra Generative Query Network (GQN) - một mạng neural network được thiết kế để dạy trí tuệ nhân tạo (AI) cách tưởng tượng ra đồ vật sẽ trông như thế nào từ một phía khác.

Cụ thể, AI sẽ phân tích hình ảnh 2D rồi có thể kết xuất được toàn cảnh 3D. Điều đáng nói là trí thông minh nhân tạo của DeepMind chỉ xem qua ít nhất 3 tấm hình chứ không hề sử dụng các dữ liệu nhập hay kho kiến thức nào cả, rồi có thể ngay lập tức dự đoán phiên bản 3D của hình ảnh đó sẽ ra sao.

Các nhà nghiên cứu AI đang nỗ lực để dạy cho máy móc cách nhận thức được như con người, đưa ra các giả định sau khi quan sát môi trường xung quanh mà cụ thể là đoán hình dáng của đồ đạc, cảnh vật ở khía cạnh mà nó chưa được "chiêm ngưỡng".

Ví dụ, bạn chụp bức ảnh một khối rubic và yêu cầu Ai tái tạo lại tấm hình từ một góc độ khác. Trí tuệ nhân tạo – nhờ sử dụng GQN, phải tự hình dung ra khối rubic (ánh sáng, đổ bóng, các đường thẳng của khối) sẽ như thế nào ở các mặt còn lại để có thể kết xuất ra hình ảnh mà ta cần.

Hiện tại, hệ thống trí tuệ nhân tạo của DeepMind vẫn chưa được luyện tập với hình ảnh của thế giới thật. Tiếp theo các nhà nghiên cứu sẽ cho nó render lại danh lam thắng cảnh đời thật từ ảnh.

Hệ thống sử dụng GQN của Deepmind được kỳ vọng có thể chỉ sử dụng ảnh 2D có thể tạo ra cảnh 3D cực chuẩn xác trong tương lai.

Xem thêm:

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài