Chạy các mô hình ngôn ngữ lớn (LLM) cục bộ trên điện thoại Android có nghĩa là bạn có thể truy cập những mô hình AI mà không cần dựa vào máy chủ đám mây hoặc kết nối Internet. Thiết lập cục bộ này đảm bảo quyền riêng tư bằng cách giữ dữ liệu của bạn an toàn và trên thiết bị. Với những tiến bộ trong phần cứng di động, việc chạy các mô hình AI cục bộ đã trở thành hiện thực. Ứng dụng MLC Chat giúp bạn dễ dàng trải nghiệm công nghệ mạnh mẽ này ngay trên điện thoại của mình.

Bài viết này sẽ giải thích tầm quan trọng của việc chạy LLM cục bộ trên điện thoại Android và cung cấp hướng dẫn từng bước để cài đặt và chạy chúng bằng ứng dụng MLC Chat.

Tại sao nên chạy LLM trên điện thoại Android?

LLM thường được chạy trên máy chủ đám mây do chúng yêu cầu sức mạnh tính toán đáng kể. Mặc dù điện thoại Android có một số hạn chế nhất định khi chạy LLM, nhưng chúng cũng mở ra những khả năng thú vị.

- Quyền riêng tư được cải thiện: Vì toàn bộ quá trình tính toán diễn ra trên điện thoại nên dữ liệu của bạn vẫn ở trạng thái cục bộ, điều này rất quan trọng đối với mọi thông tin nhạy cảm mà bạn chia sẻ.

- Truy cập ngoại tuyến: Không cần kết nối Internet liên tục để truy cập hoặc tương tác với các mô hình này. Điều này đặc biệt hữu ích cho người dùng ở vùng sâu vùng xa hoặc những người có kết nối Internet hạn chế.

- Hiệu quả về chi phí: Chạy LLM trên máy chủ đám mây liên quan đến chi phí vận hành như năng lực xử lý và lưu trữ đám mây. Phương pháp này cung cấp giải pháp tiết kiệm cho người dùng.

Hướng dẫn từng bước để cài đặt và chạy MLC Chat trên Android

Ứng dụng MLC Chat là ứng dụng được thiết kế để cho phép người dùng chạy và tương tác với các mô hình ngôn ngữ lớn (LLM) cục bộ trên nhiều thiết bị khác nhau, bao gồm cả điện thoại di động, mà không cần dựa vào những dịch vụ dựa trên đám mây. Thực hiện theo các bước dưới đây để chạy LLM cục bộ trên thiết bị Android.

Bước 1: Cài đặt ứng dụng MLC Chat

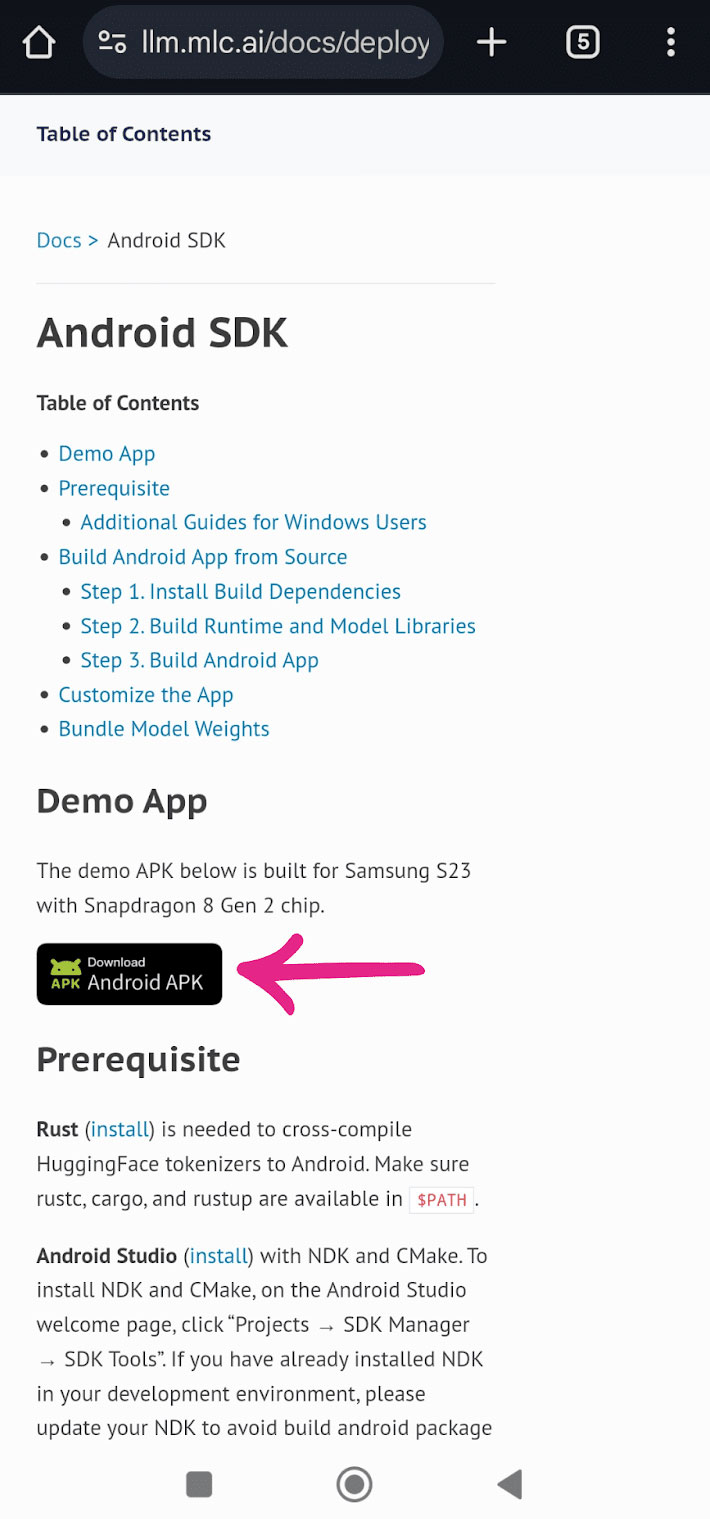

Trước tiên, bạn cần tải xuống APK cho ứng dụng MLC Chat (112MB) từ liên kết bên dưới.

Sau khi tải xuống APK, hãy nhấn vào file để bắt đầu cài đặt.

Bước 2: Tải xuống LLM

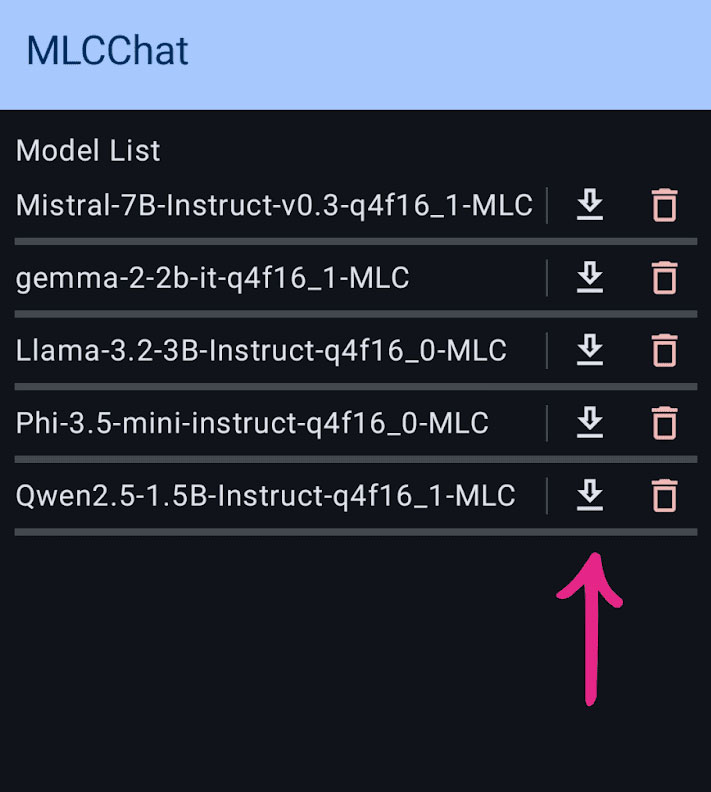

Sau khi cài đặt thành công ứng dụng, hãy mở ứng dụng và bạn sẽ thấy danh sách các LLM có sẵn để tải xuống. Các mô hình có kích thước và khả năng khác nhau, chẳng hạn như LLama-3.2, Phi-3.5 và Mistral, đều khả dụng. Chọn mô hình theo nhu cầu của bạn và nhấn vào biểu tượng tải xuống bên cạnh để bắt đầu tải xuống. Ví dụ, nếu đang sử dụng điện thoại tầm trung như Redmi Note 10, hãy chọn mô hình nhẹ như Qwen-2.5 để có hiệu suất mượt mà hơn.

Bước 3: Chạy LLM đã cài đặt

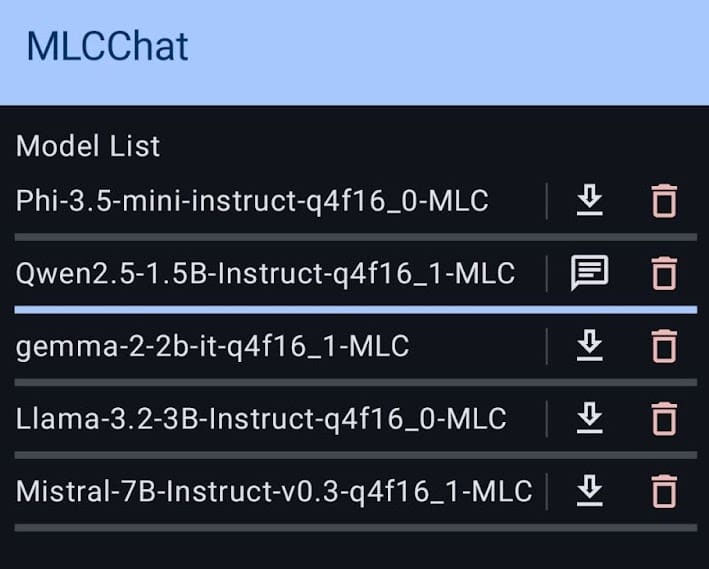

Sau khi mô hình được tải xuống, một biểu tượng trò chuyện sẽ xuất hiện bên cạnh mô hình đó. Nhấn vào biểu tượng để bắt đầu mô hình.

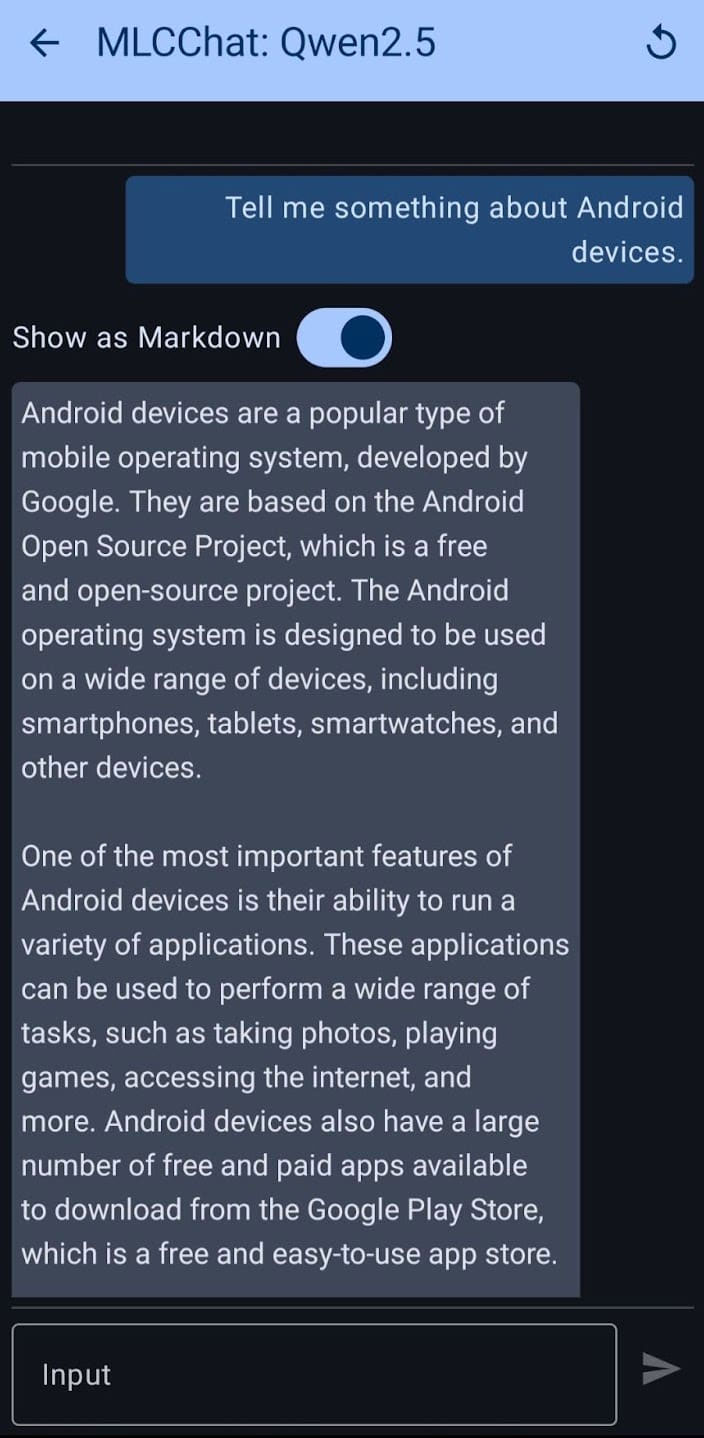

Khi mô hình đã sẵn sàng, bạn có thể bắt đầu nhập prompt và tương tác với LLM cục bộ.

Ví dụ, trên một thiết bị như Redmi Note 10, chạy một mô hình nhỏ hơn như Qwen2.5 mang lại trải nghiệm khá mượt mà, tạo ra khoảng 1,4 token mỗi giây. Mặc dù hiệu suất này chậm hơn so với các thiết bị cao cấp như Galaxy S23 Ultra, nhưng nó vẫn hoạt động tốt đối với các tác vụ cơ bản như trò chuyện ngắn và tạo nội dung đơn giản.

Chạy LLM cục bộ trên các thiết bị Android thông qua ứng dụng MLC Chat cung cấp một cách dễ tiếp cận và bảo vệ quyền riêng tư để tương tác với những mô hình AI. Hiệu suất phụ thuộc rất nhiều vào phần cứng điện thoại. Giải pháp này lý tưởng cho những người dùng cần truy cập ngoại tuyến vào các mô hình AI, thử nghiệm LLM theo thời gian thực hoặc lo ngại về quyền riêng tư. Khi phần cứng di động tiếp tục được cải thiện, khả năng của LLM cục bộ sẽ chỉ mở rộng, biến đây thành một ranh giới thú vị cho công nghệ AI.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài