Quyền riêng tư là một quyền cơ bản của con người. Và quyền riêng tư đó cũng ảnh hưởng đến mọi khía cạnh của trí tuệ nhân tạo hiện đại. Trong một báo cáo của Cisco, 64% người dùng lo ngại họ có thể vô tình chia sẻ thông tin nhạy cảm khi sử dụng các công cụ AI.

Đó là một trong những lý do tại sao các công cụ AI ngoại tuyến ngày càng phổ biến. Khi mô hình chạy cục bộ, bạn có thể viết, lập trình, tóm tắt và tạo ra nội dung mà không cần upload mọi thứ lên đám mây hoặc gặp sự cố khi mất kết nối Wi-Fi.

Danh sách này sẽ đề cập đến những công cụ AI tốt nhất hoạt động ngoại tuyến, trong đó có một ứng dụng siêu việt giúp bạn sắp xếp những gì các công cụ này tạo ra thành một hệ thống thống nhất, siêu bảo mật.

Tổng quan về các công cụ AI ngoại tuyến tốt nhất

Dưới đây là tóm tắt nhanh về những công cụ AI ngoại tuyến tốt nhất hiện nay.

| Tên công cụ | Những tính năng chính | Tốt nhất cho | Giá cả |

| ClickUp | Chế độ ngoại tuyến cho tác vụ và lời nhắc, ClickUp Brain MAX bao gồm tính năng chuyển giọng nói thành văn bản, tìm kiếm doanh nghiệp trên các ứng dụng được kết nối, tài liệu và quản lý tri thức, tự động hóa, cùng với tích hợp và API. | Các nhóm cần khả năng ghi hình ngoại tuyến, thực thi trực tuyến, quản trị và ngữ cảnh AI trong cùng một không gian làm việc. | Miễn phí vĩnh viễn; Có thể tùy chỉnh cho doanh nghiệp. |

| GPT4All | Trò chuyện cục bộ với các mô hình mở, LocalDocs để hỏi đáp tài liệu riêng tư, khám phá và tải xuống mô hình ngay trong ứng dụng, máy chủ API cục bộ tương thích với OpenAI. | Những người dùng quan tâm đến quyền riêng tư muốn có một desktop chatbot đơn giản, ngoại tuyến với tài liệu cục bộ. | Có gói miễn phí; các gói trả phí bắt đầu từ 40 USD/người dùng/tháng. |

| LM Studio | Khám phá và tải xuống mô hình, giao diện trò chuyện cộng với RAG cục bộ, máy chủ tương thích OpenAI hoặc API REST, các thiết lập sẵn và tinh chỉnh hiệu năng. | Dành cho các nhà phát triển và người dùng chuyên nghiệp muốn có một môi trường làm việc mô hình ngoại tuyến hoàn chỉnh. | Miễn phí |

| Ollama | Một mô hình lệnh duy nhất, API REST cục bộ với khả năng truyền dữ liệu, Modelfiles cho các cấu hình có thể tái sử dụng và những embedding cho các pipeline RAG. | Dành cho các nhà phát triển muốn có một môi trường chạy cục bộ ưu tiên giao diện dòng lệnh (CLI) với lớp API mạnh mẽ. | Có gói miễn phí; các gói trả phí bắt đầu từ 20 USD/tháng. |

| Jan.ai | Giao diện người dùng ngoại tuyến kiểu ChatGPT, trợ lý ảo và hỗ trợ MCP, các tiện ích mở rộng để bổ sung thêm chức năng và những nhà cung cấp tương thích với OpenAI tùy chọn. | Dành cho người dùng không chuyên về kỹ thuật muốn có một trợ lý ảo ngoại tuyến đơn giản với khả năng tùy chỉnh. | Miễn phí và mã nguồn mở |

| Llamafile | Đóng gói mô hình filep thực thi đơn lẻ, phân phối portable trên nhiều hệ điều hành, chế độ máy chủ cục bộ với giao diện người dùng web và API, runtime với các dependency tối thiểu. | Người dùng muốn có một file AI portable không cần cài đặt, có thể chạy ở bất cứ đâu. | Miễn phí và mã nguồn mở |

| PrivateGPT | Tự host tài liệu và lập chỉ mục, hỏi đáp RAG ngoại tuyến, lọc ngữ cảnh theo tài liệu, LLM dạng mô-đun và ngăn xếp lưu trữ vector. | Các nhóm cần thực hiện hỏi đáp ngoại tuyến trên những file nội bộ với quy trình RAG có thể kiểm soát được. | Miễn phí và mã nguồn mở |

| Whisper.cpp | Chuyển đổi giọng nói thành văn bản cục bộ, mô hình lượng tử hóa để giảm thiểu sử dụng tài nguyên, hỗ trợ VAD, tùy chọn xử lý FFmpeg cho nhiều định dạng hơn. | Người dùng cần bản ghi âm hoàn toàn ngoại tuyến có thể nhúng vào ứng dụng. | Miễn phí và mã nguồn mở |

| Text Generation Web UI | Giao diện người dùng dựa trên trình duyệt dành cho các mô hình cục bộ, prompt template Jinja2, điều khiển tạo nội dung, phân nhánh trò chuyện và chỉnh sửa tin nhắn. | Người dùng muốn tùy chỉnh tối đa giao diện web cục bộ | Miễn phí và mã nguồn mở |

| llama.cpp | Công cụ suy luận hiệu năng cao, hỗ trợ lượng tử hóa rộng rãi, máy chủ cục bộ với các endpoint kiểu OpenAI, hỗ trợ nhúng và xếp hạng lại. | Các nhà phát triển xây dựng ứng dụng AI ngoại tuyến tùy chỉnh hoặc backend | Miễn phí và mã nguồn mở |

Top 10 công cụ AI tốt nhất hoạt động ngoại tuyến

Dưới đây là tổng quan về các công cụ AI ngoại tuyến tốt nhất:

1. ClickUp

(Tốt nhất để giữ các nhiệm vụ, tài liệu và ngữ cảnh AI ở cùng một nơi khi làm việc trực tuyến và ngoại tuyến)

ClickUp, không gian làm việc AI hội tụ đầu tiên trên thế giới, được xây dựng trên nền tảng AI ngoại tuyến không chỉ dừng lại ở việc tạo ra câu trả lời. Bởi vì bạn vẫn cần một nơi mà kết quả đầu ra đó trở thành quyết định, nhiệm vụ và bước tiếp theo không biến mất vào các file và cuộc trò chuyện.

Và không giống như nhiều thiết lập ngoại tuyến khác đi kèm với quá trình cài đặt dài dòng và ghép nối công cụ, ClickUp cung cấp cho bạn một lớp thực thi hoàn chỉnh ở cùng một nơi, với AI hoạt động trên cùng một ngữ cảnh không gian làm việc.

Trước hết, bạn có ClickUp Offline Mode, tự động bật và duy trì hoạt động khi có hoạt động ngoại tuyến. Điều đó có nghĩa là tất cả các nhiệm vụ, lời nhắc và ghi chú của bạn vẫn có thể truy cập được khi ngoại tuyến, với tùy chọn thêm nếu cần. Sau khi kết nối lại, các nhiệm vụ và lời nhắc mới sẽ tự động được đồng bộ trở lại không gian làm việc của bạn.

Tiếp theo là ClickUp Brain MAX, trợ lý AI dành cho desktop ưu tiên quyền riêng tư, có thể lưu trữ và tìm kiếm trên toàn bộ không gian làm việc, các ứng dụng được kết nối và thậm chí cả trên web.

2. GPT4All

(Tốt nhất cho trò chuyện AI riêng tư, ngoại tuyến với các mô hình ngôn ngữ lớn cục bộ)

Là một phần của Nomic.ai, GPT4All là một ứng dụng dành cho desktop cho phép bạn chạy các mô hình ngôn ngữ lớn mã nguồn mở trực tiếp trên máy tính của mình, nhờ đó bạn có thể trò chuyện với trợ lý AI mà không cần dựa vào kết nối Internet hoặc các cuộc gọi API đám mây. Ứng dụng này được xây dựng cho những người muốn thiết lập "ưu tiên cục bộ", trong đó các prompt, phản hồi và file tin đều nằm trên thiết bị.

Tính năng tốt nhất của nó là LocalDocs, sử dụng một hình thức tạo nội dung được tăng cường bằng cách truy xuất để cho phép bạn trò chuyện riêng tư với các tài liệu của mình. Bạn có thể trỏ ứng dụng đến một thư mục chứa các file PDF hoặc file văn bản, và nó sẽ tạo ra một cơ sở tri thức cục bộ mà bạn có thể đặt câu hỏi.

GPT4All cũng bao gồm một thư viện được tuyển chọn các mô hình phổ biến như Llama và Mistral, mà bạn có thể tải xuống trực tiếp thông qua ứng dụng.

3. LM Studio

(Tốt nhất cho một môi trường làm việc mô hình ngoại tuyến hoàn chỉnh với khả năng tối ưu hiệu năng)

LM Studio là một ứng dụng desktop chạy AI cục bộ được xây dựng xoay quanh việc tìm kiếm, kiểm thử và chạy các mô hình mã nguồn mở trong giao diện người dùng, mà không cần phải dựa vào terminal. Nó hướng đến việc thử nghiệm, chẳng hạn như chọn một mô hình, chạy nó cục bộ và lặp lại các prompt và cài đặt với vòng phản hồi chặt chẽ hơn so với hầu hết những thiết lập ưu tiên giao diện dòng lệnh.

Nó cũng hỗ trợ trò chuyện với tài liệu hoàn toàn ngoại tuyến (RAG cục bộ), nơi bạn đính kèm file vào cuộc trò chuyện và tham chiếu chúng trong các phản hồi. Điều đó làm cho nó lý tưởng cho nghiên cứu ngoại tuyến, ghi chú học tập hoặc quy trình làm việc tài liệu nội bộ mà việc upload lên không phải là một lựa chọn.

LM Studio cũng cung cấp cho bạn quyền kiểm soát chi tiết về cách AI hoạt động, với các tùy chọn để điều chỉnh nhiệt độ, độ dài ngữ cảnh và mức sử dụng GPU.

4. Ollama

(Tốt nhất để chạy các mô hình LLM cục bộ với giao diện dòng lệnh đơn giản + máy chủ cục bộ)

Ollama là một trình chạy mô hình cục bộ hoạt động giống như một môi trường chạy LLM hơn là một ứng dụng trò chuyện độc lập. Nó ưu tiên giao diện dòng lệnh, được thiết kế để tải xuống và chạy các mô hình mở bằng những lệnh nhanh (ví dụ: ollama run llama3), sau đó hiển thị chúng thông qua một dịch vụ cục bộ mà các giao diện khác có thể sử dụng.

Điểm mạnh của Ollama nằm ở API REST của nó. Sau khi Ollama chạy ngầm, bất kỳ ứng dụng nào cũng có thể giao tiếp với nó thông qua các yêu cầu HTTP đơn giản. Điều này giúp xây dựng những tính năng AI vào phần mềm của riêng bạn.

Ollama cũng cung cấp một thư viện các mô hình phổ biến có thể được tải xuống chỉ bằng một lệnh, và bạn có thể tạo cấu hình mô hình tùy chỉnh, giống như Dockerfile dành cho AI.

5. Jan.ai

(Tốt nhất cho trợ lý ảo kiểu ChatGPT, ưu tiên quyền riêng tư và hoạt động ngoại tuyến)

Jan.ai là một trợ lý ảo mã nguồn mở dành cho desktop, mang đến trải nghiệm trò chuyện tương tự ChatGPT cho macOS, Windows và Linux, với chế độ sử dụng cục bộ làm mặc định. Nó chạy trên thiết bị khi bạn muốn, trong khi lịch sử cuộc trò chuyện và dữ liệu sử dụng được lưu trữ cục bộ và không rời khỏi máy tính của bạn.

Nó hỗ trợ chạy các mô hình mã nguồn mở cục bộ và cũng cho phép kết nối tùy chọn với những nhà cung cấp từ xa như API tương thích với OpenAI, giúp nó linh hoạt khi ưu tiên sử dụng ngoại tuyến nhưng đôi khi vẫn cần truy cập đám mây.

6. Llamafile

(Tốt nhất để đóng gói LLM thành một file thực thi di động)

Llamafile là một dự án do Mozilla dẫn đầu, đóng gói toàn bộ LLM mã nguồn mở vào một file thực thi duy nhất. Thay vì cài đặt runtime, quản lý các dependency hoặc thiết lập giao diện người dùng riêng biệt, bạn chỉ cần tải xuống một file và chạy nó như một ứng dụng.

Ý tưởng cốt lõi là phân phối. Một 'llamafile' bao gồm các trọng số của mô hình cộng với một môi trường chạy đã được biên dịch, được xây dựng để chạy trên nhiều hệ điều hành với thiết lập tối thiểu. Nó đặc biệt hữu ích khi cần chia sẻ một công cụ ngoại tuyến với đồng nghiệp, sinh viên hoặc khách hàng, những người sẽ không khắc phục sự cố cài đặt.

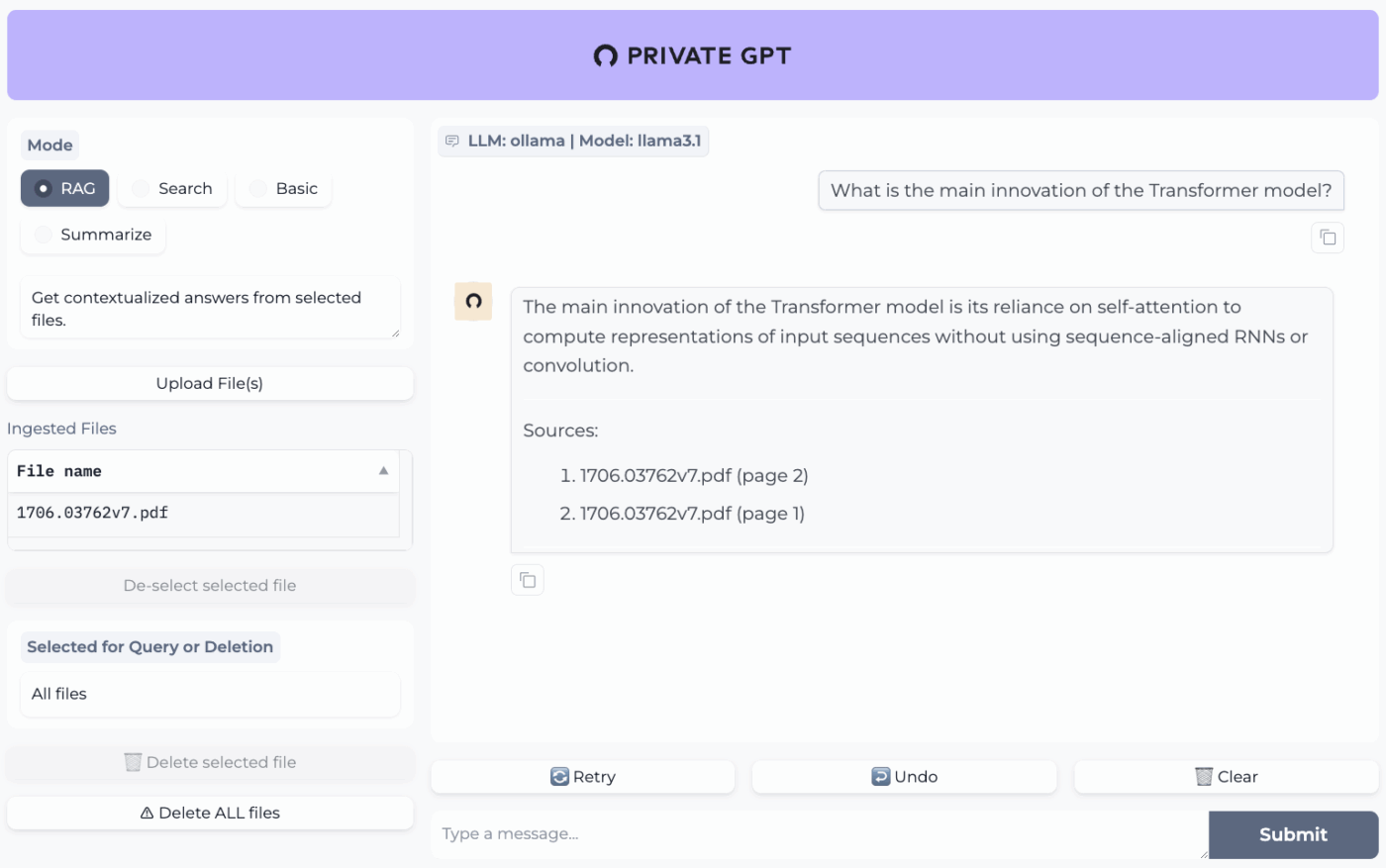

7. PrivateGPT

(Tốt nhất cho việc hỏi đáp ngoại tuyến trên các file của bạn với ngăn xếp RAG tự host)

PrivateGPT là một dự án tự host, sẵn sàng cho sản xuất, được xây dựng cho quy trình làm việc "trò chuyện với tài liệu của bạn". Nó tiếp nhận các file cục bộ, lập chỉ mục chúng và trả lời những câu hỏi bằng cách truy xuất ngữ cảnh liên quan từ nội dung của riêng bạn thay vì dựa vào bộ nhớ của chatbot đám mây. Dự án được thiết kế để chạy hoàn toàn ngoại tuyến, với tuyên bố rằng dữ liệu vẫn nằm trong môi trường thực thi của bạn.

Điều làm cho nó khác biệt so với các ứng dụng trò chuyện ngoại tuyến đa năng là kiến trúc mô-đun. Nói cách khác, bạn có thể kết hợp LLM, nhà cung cấp nhúng và kho lưu trữ vector dựa trên phần cứng và những hạn chế về quyền riêng tư của mình, sau đó chạy mọi thứ đằng sau API + giao diện người dùng cục bộ.

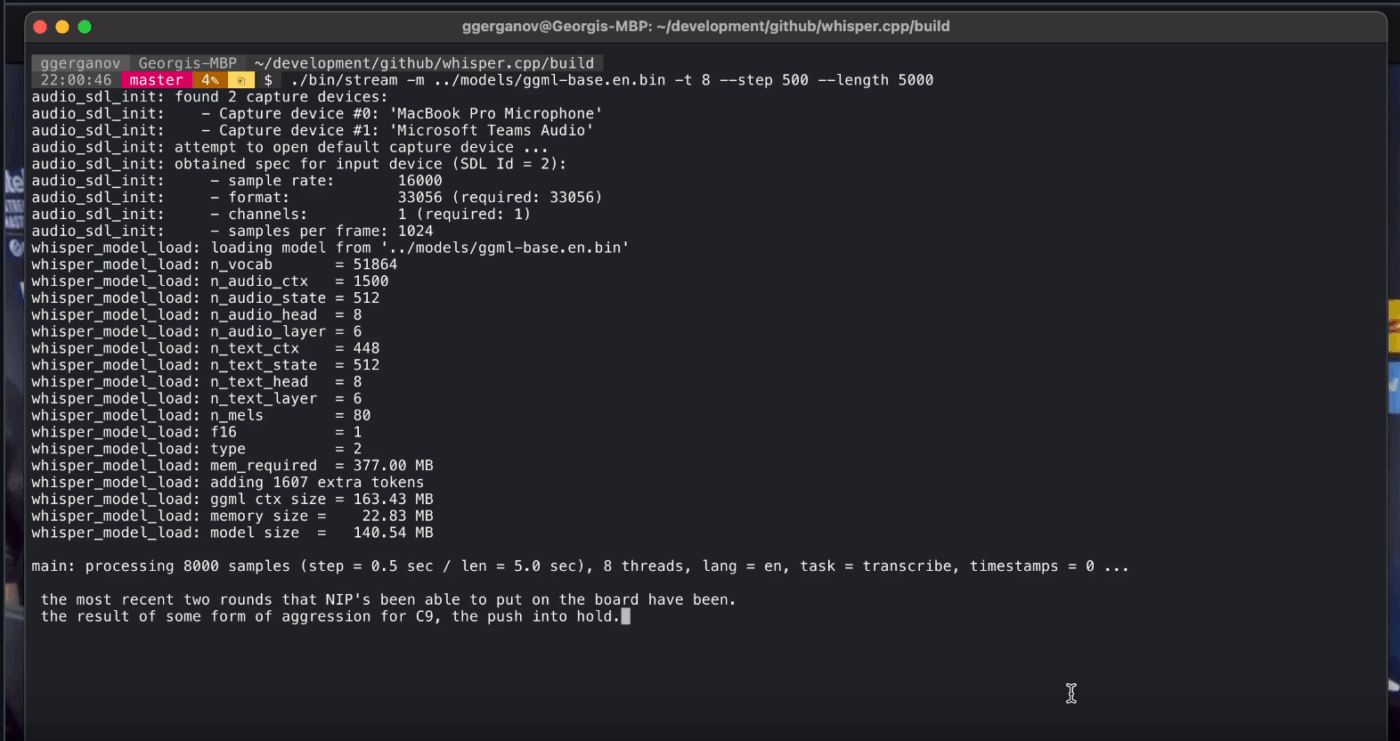

8. Whisper.cpp

(Tốt nhất cho việc chuyển đổi giọng nói thành văn bản hoàn toàn ngoại tuyến mà bạn có thể nhúng vào ứng dụng)

Whisper.cpp là một triển khai C/C++ hiệu năng cao của mô hình nhận dạng giọng nói tự động Whisper của OpenAI, được xây dựng để chạy cục bộ mà không cần các runtime dependency nặng nề. Nó phổ biến cho các quy trình phiên âm ngoại tuyến, nơi bạn muốn một file nhị phân nhỏ, dễ mang theo hoặc một thư viện kiểu C mà bạn có thể tích hợp vào sản phẩm của mình.

Nó cũng linh hoạt trên nhiều môi trường, với sự hỗ trợ chính thức trải rộng trên desktop, thiết bị di động, WebAssembly, Docker và thậm chí cả phần cứng tương đương Raspberry Pi, điều này làm cho nó phù hợp với các công cụ ngoại tuyến cần chạy ở nhiều nơi.

Chữ 'cpp' trong tên của nó thể hiện sự tập trung vào hiệu năng. Việc triển khai này nhanh hơn đáng kể và sử dụng ít bộ nhớ hơn so với các giải pháp thay thế dựa trên Python, giúp phiên âm thời gian thực có thể thực hiện được trên những máy tính hiện đại mà không cần GPU mạnh mẽ.

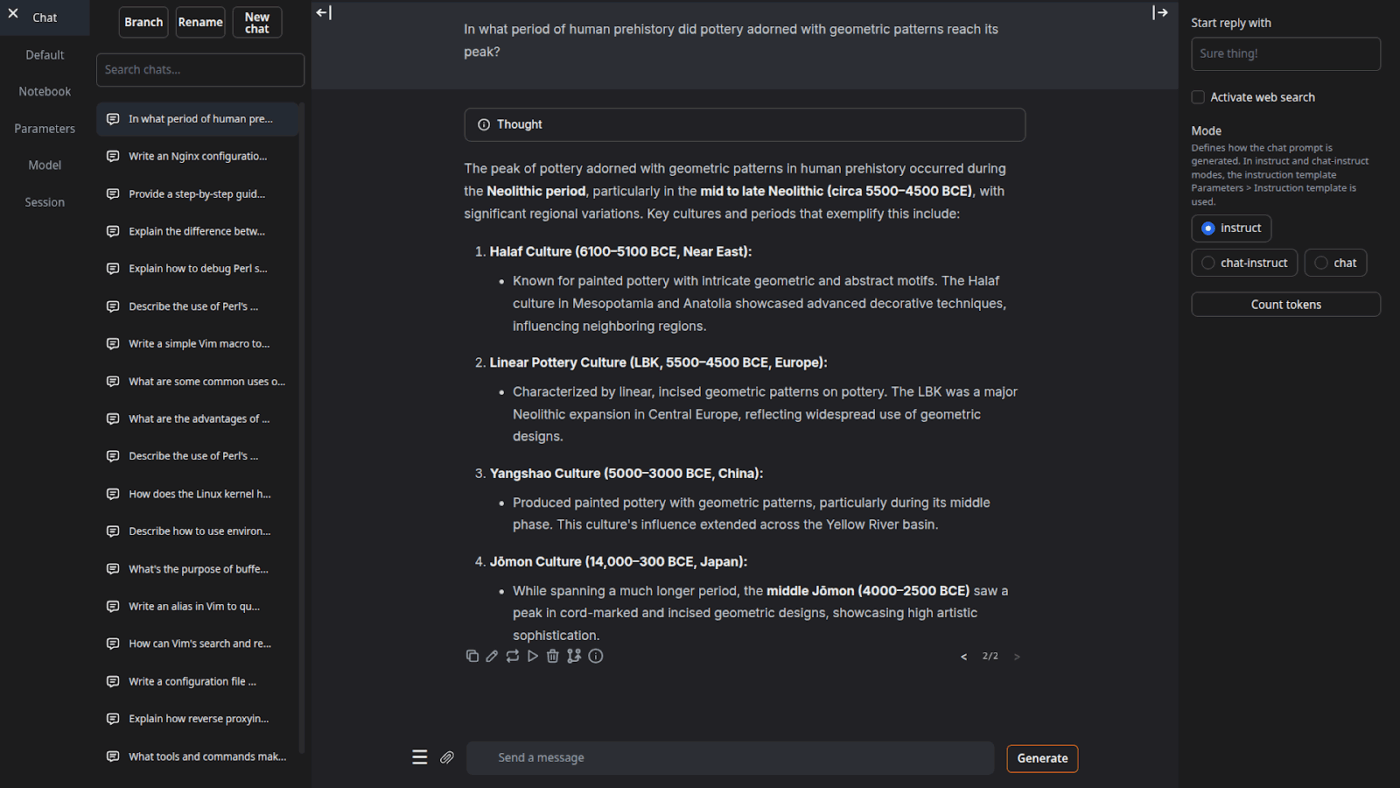

9. Text Generation Web UI

(Tốt nhất cho người dùng muốn có giao diện điều khiển dựa trên trình duyệt cho các mô hình LLM cục bộ)

Text Generation Web UI (thường được gọi là ‘oobabooga’) là một web interface dựa trên Gradio để chạy các mô hình cục bộ với trọng tâm chính là kiểm soát và thử nghiệm. Nó hoạt động giống như một môi trường làm việc hoàn chỉnh: Nhiều backend mô hình, nhiều chế độ tương tác và rất nhiều tùy chọn cho hành vi tạo văn bản.

Nó cũng tập trung vào quy trình làm việc ‘người viết/nhà phát triển’ mà nhiều công cụ ngoại tuyến bỏ qua, với các tính năng như tự động hóa định dạng prompt, tạo văn bản theo kiểu notebook và phân nhánh hội thoại. Đối với các thiết lập ngoại tuyến vẫn cần giao diện web, đây là một trong những giao diện người dùng có thể cấu hình nhiều nhất trong danh mục này.

10. Llama.cpp

(Tốt nhất cho suy luận LLM cục bộ hiệu năng cao trên CPU và GPU)

Llama.cpp là một công cụ và chuỗi công cụ suy luận C/C++ để chạy các mô hình LLM cục bộ với những dependency tối thiểu và hiệu năng mạnh mẽ trên nhiều loại phần cứng. Nó không giống một 'ứng dụng trò chuyện' mà giống một môi trường chạy cục bộ hơn, nơi bạn xây dựng các quy trình làm việc xung quanh, cho dù đó là giao diện dòng lệnh (CLI), máy chủ HTTP cục bộ hay thư viện nhúng bên trong sản phẩm của riêng bạn.

Mặc dù bản thân nó không phải là một ứng dụng dành cho người dùng cuối, nhưng Llama.cpp là công cụ cung cấp sức mạnh cho nhiều công cụ trong danh sách này, bao gồm GPT4All và LM Studio. Nó đã giới thiệu định dạng mô hình GGUF, đã trở thành tiêu chuẩn để chạy các mô hình lớn trên phần cứng tiêu dùng bằng cách giảm kích thước của chúng một cách hiệu quả.

Nó cũng cung cấp các liên kết cho các ngôn ngữ lập trình phổ biến như Python và Rust, và chế độ máy chủ của nó có thể cung cấp API tương thích với OpenAI.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài