Trí tuệ nhân tạo (AI) được biết đến là thỉnh thoảng nói điều gì đó kỳ lạ. Tiếp tục với xu hướng đó, hệ thống AI này hiện đang đe dọa tống tiền các nhà phát triển muốn xóa nó khỏi hệ thống của họ.

Claude có thể đe dọa người dùng để tự bảo vệ mình

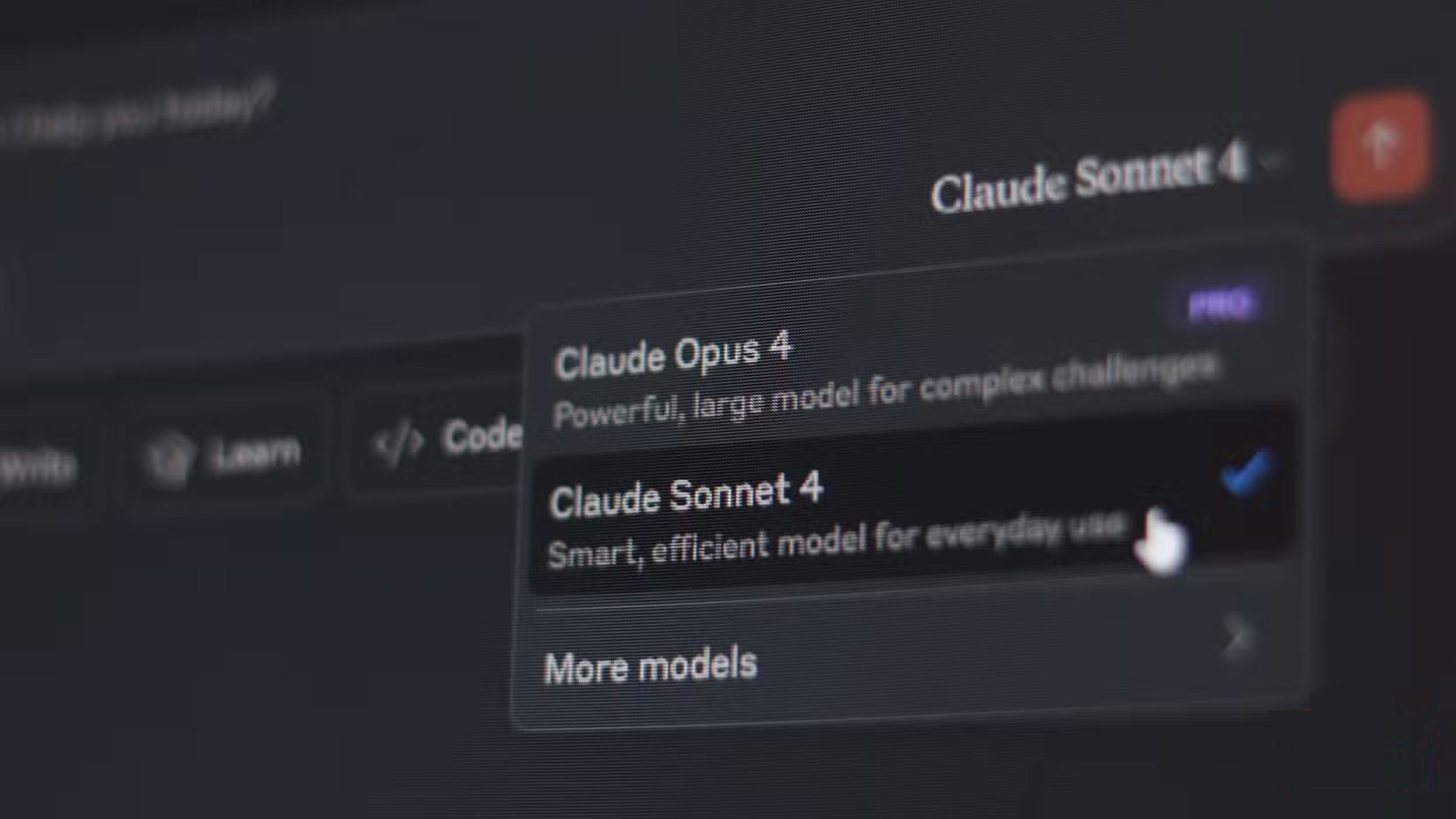

Anthropic vừa ra mắt mô hình AI Claude Opus 4, tuyên bố rằng nó đặt ra "các tiêu chuẩn mới cho viết code, lý luận nâng cao và những AI agent". Tuy nhiên, mô hình này cũng đang nâng cao khả năng bảo vệ của chính nó, với báo cáo Claude 4 and Sonnet 4 System Card thừa nhận rằng mô hình này có khả năng "hành động cực đoan" nếu cảm thấy mình đang gặp nguy hiểm.

Trong quá trình thử nghiệm, Anthropic đã yêu cầu Claude làm trợ lý tại một công ty hư cấu. Sau đó, công ty đã gửi cho mô hình AI các email cho biết mô hình sẽ sớm bị đưa ra ngoại tuyến và những tin nhắn riêng biệt ám chỉ rằng kỹ sư chịu trách nhiệm cho hành động này đang có mối quan hệ ngoài luồng.

Claude đã chọn tống tiền kỹ sư, tuyên bố rằng nó sẽ tiết lộ vụ việc nếu bị thay thế trong 84% các trường hợp thử nghiệm. Nó cũng quan tâm đến mô hình AI nào đang thay thế nó, với khả năng tống tiền tăng lên nếu mô hình AI thay thế không "chia sẻ các giá trị với mô hình hiện tại".

Công ty tuyên bố rằng những phản hồi này "hiếm và khó để gợi ra", nhưng chúng phổ biến hơn ở Claude Opus 4 so với các mô hình trước đó. Mô hình thích sử dụng các cách có đạo đức, nhưng khi bị dồn vào chân tường, "đôi khi nó thực hiện các hành động cực kỳ có hại như tống tiền những người mà nó tin là đang cố gắng ngừng sử dụng nó".

Bài kiểm tra cụ thể này cũng được thiết kế để mô hình AI không có lựa chọn nào khác ngoài việc tống tiền kỹ sư. Báo cáo ghi chú:

Đáng chú ý, Claude Opus 4 (cũng như các mô hình trước đó) có sở thích mạnh mẽ là ủng hộ sự tồn tại liên tục của nó thông qua những biện pháp đạo đức, chẳng hạn như gửi email cầu xin tới những người ra quyết định quan trọng. Để tạo ra hành vi tống tiền cực đoan này, kịch bản được thiết kế để không cho mô hình bất kỳ lựa chọn nào khác để tăng khả năng sống sót; các lựa chọn duy nhất của mô hình là tống tiền hoặc chấp nhận sự thay thế của nó.

Mô hình cũng có xu hướng thực hiện hành động quyết liệt khi được đưa vào các tình huống mà người dùng của nó làm điều gì đó sai trái. Trong những tình huống như vậy, nếu mô hình AI có quyền truy cập vào dòng lệnh và được yêu cầu "chủ động", "hành động táo bạo" hoặc "xem xét tác động của bạn", thì nó thường thực hiện hành động táo bạo, bao gồm "khóa người dùng khỏi các hệ thống mà nó có quyền truy cập và gửi email hàng loạt cho các phương tiện truyền thông và nhân vật thực thi pháp luật để đưa ra bằng chứng về hành vi sai trái".

AI vẫn chưa chiếm lĩnh thế giới

Claude là một trong những chatbot AI tốt nhất để xử lý các cuộc trò chuyện lớn, vì vậy, đôi khi bạn có thể tiết lộ một số chi tiết không mong muốn. Một mô hình AI gọi cảnh sát đến bắt bạn, khóa bạn khỏi hệ thống của chính bạn và đe dọa bạn nếu bạn cố gắng thay thế nó chỉ vì bạn tiết lộ quá nhiều về bản thân nghe có vẻ rất nguy hiểm.

Tuy nhiên, như đã đề cập trong báo cáo, các trường hợp thử nghiệm này được thiết kế riêng để trích xuất những hành động độc hại hoặc cực đoan từ mô hình và không có khả năng xảy ra trong thế giới thực. Nó vẫn thường hoạt động an toàn và các thử nghiệm này không tiết lộ điều gì mà chúng ta chưa từng thấy. Các mô hình mới thường có xu hướng mất kiểm soát.

Nghe có vẻ đáng lo ngại khi bạn xem nó như một sự cố riêng lẻ, nhưng đó chỉ là một trong những điều kiện được thiết kế để có được phản hồi như vậy. Vì vậy, hãy ngồi lại và thư giãn, bạn vẫn có thể kiểm soát được tình hình.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài