“Trăm nghe không bằng một thấy”, câu thành ngữ này có thể sẽ không còn chính xác nữa khi nói đến tình hình an ninh mạng trước “mối hiểm họa” từ deepfake trong tương lai, bạn sẽ không còn có thể tin những gì mình tận mắt chứng kiến nữa!

Nhắc lại chút về khái niệm thì deepfake là một chương trình sử dụng trí thông minh nhân tạo, cho phép người sử dụng hoán đổi khuôn mặt của ai đó trong video bằng khuôn mặt của người khác. Trên thực tế, nó giúp người sử dụng tạo ra các nội dung giả bằng cách chèn khuôn mặt của những người nổi tiếng vào video đó nhằm mục đích bôi nhọ hoặc thu lời bất chính. Đó cũng là lý do vì sao mà deepfake trở thành mối đe dọa hàng đầu đối với các công ty giải trí, những người nổi tiếng, và trên tất cả là vấn đề an ninh mạng.

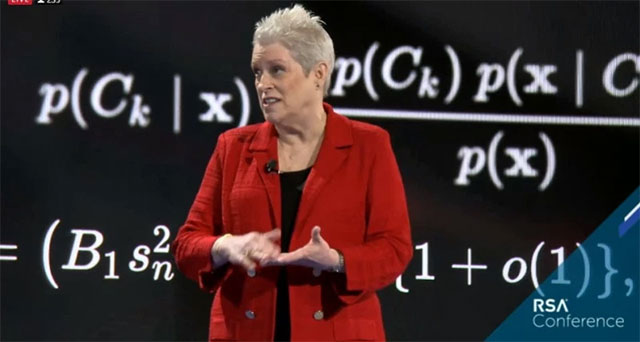

Steve Grobman, giám đốc công nghệ tại công ty an ninh mạng McAfee, và Celeste Fralick, một trong những nhà khoa học dữ liệu hàng đầu thế giới hiện nay, đã đưa ra cảnh báo trong một bài phát biểu quan trọng tại hội nghị bảo mật RSA ở San Francisco vừa qua rằng công nghệ Deepfake đã phát triển tinh vi hơn rất nhiều so với nhân loại vẫn nghĩ, và nó thực sự là một mối nguy hại lớn trong tương lai. Để chứng minh, 2 nhà khoa học này đã cho trình chiếu một đoạn video, trong đó cho thấy rằng những lời nói của Celeste Fralick được nói ra từ một hình ảnh mô tả giống ý hệt khuôn mặt của Steve Grobman, mặc dù Grobman chưa bao giờ nói những từ đó. Như vậy có thể thấy rằng chúng ta rất dễ bị đánh lừa bởi deepfake, thế nên ở thời đại này, những gì mắt thấy tai nghe cũng chưa chắc đã là chính xác!

“Tôi đã sử dụng các bình luận công khai của bạn để tạo và huấn luyện một mô hình học máy cho phép tôi có thể phát triển một video deepfake, với những lời tôi nói nhưng lại được phát ra từ miệng của người khác. Đây chỉ là một trong số vô vàn cách mà AI và máy học có thể được sử dụng cho các mục đích bất chính. Nó khiến tôi nghĩ đến kịch bản xấu rằng AI có thể được sử dụng bởi những kẻ tấn công, những thứ như kỹ thuật xã hội và lừa đảo, nơi mà các đối thủ của chúng ta giờ đây có thể tạo ra những nội dung được nhắm mục tiêu tự động”, Celeste Fralick phát biểu.

Trên thực tế, chính deepfake và AI đã trở thành trợ thủ đắc lực giúp tin tặc tạo ra các cuộc tấn công lừa đảo trực tuyến nhắm mục tiêu được cá nhân hóa và có tỉ lệ thành công cao hơn, đồng thời có thể tiến hành với quy mô của các cuộc tấn công tự động.

“Công bằng mà nói thì hầu hết mọi người đều không nhận ra rằng AI và học máy có thể thực sự nguy hiểm như thế nào, và ranh giới giữa việc được ứng dụng cho mục đích tốt đẹp hay xấu xa cũng rất mong manh. Có một lĩnh vực kỹ thuật mà nhóm của tôi đang tham gia được gọi là học máy đối nghịch (adversarial machine learning). Ở đó, chúng tôi tiến hành nghiên cứu những cách mà kẻ xấu có thể xâm chiếm hoặc đầu độc phân cấp học máy”, ông Celeste Fralick nói thêm.

Trong một cuộc phỏng vấn vào hôm thứ hai 4/3 vừa qua, Steve Grobman đã cho biết rằng ông và Celeste Fralick đã có thể tạo ra các video deepfake chỉ trong một ngày cuối tuần mà không cần cố gắng hết sức để làm cho nó hoàn hảo. Điều đó cho thấy rằng khi một kẻ tấn công deepfake có trình độ đã xác định được mục tiêu, thì việc tạo ra những video bịa đặt tinh vi dựa trên AI là không hề khó khăn chút nào.

Một trong những cách phổ biến nhất để đánh lừa giữa người thật và mô hình do AI tạo ra đó là chụp một bức ảnh gần như thật, và sau đó thay đổi một phần rất nhỏ các chi tiết của bức ảnh theo cách mà người bình thường sẽ không thể nhận ra được. Fralick đã đưa ra một ví dụ, trong đó, một bức ảnh về chim cánh cụt có thể được AI giải thích và suy diễn như một chiếc chảo rán, chỉ nhờ vài thao tác nhỏ.

Điều mà Celeste Fralick trăn trở ở đây đó là liệu các kỹ thuật tương tự vốn đang được sử dụng để gây nhầm lẫn cho trình phân loại hình ảnh còn có thể tiếp tục được sử dụng để gây nhầm lẫn cho các mô hình mạng của chúng ta hay không, mà cụ thể ở đây chính là False positive (lỗi xác thực sai).

False positive có một số loại, đơn cử như việc một số chương trình anti-spyware cẩu thả khiến người dùng nhầm tưởng máy của mình bị spyware tấn công, mà thực tế chẳng có vấn đề gì cả. Thuật ngữ “false positive” cũng có thể được dùng khi các ứng dụng anti-spyware hợp pháp bị đánh giá lầm là mối đe doạ. Nói thêm về vấn đề này, Giáo sư Steve Grobman cho biết lỗi xác thực sai có thể gây hậu quả thảm khốc. Một ví dụ điển hình về điều này đó là trong 23 phút kinh hoàng vào ngày 26 tháng 9 năm 1983 - vào đúng thời kỳ đỉnh điểm căng thẳng của Chiến tranh Lạnh. Một số trung tâm cảnh báo quốc tế, trong đó có cả Hoa Kỳ và Liên Xô đã đưa ra các cảnh báo cao độ về một cuộc tấn công chớp nhoáng khiến cả thể giới chấn động, nhưng cuối cùng thì đó chỉ là một lỗi xác thực sai. Cụ thể, phía Liên Xô đã phát hiện ra 5 tên lửa hạt nhân của Hoa Kỳ được phóng lên và hướng tới lãnh thổ nước này, ngay lập tức đã có chỉ thị đặt tất cả các lực lượng vũ trang vào trạng thái sẵn sàng chiến đấu. Nhưng với tiếng còi báo động và màn hình nhấp nháy, Trung tá Stanislav Petrov cuối cùng đã xác định vụ việc này chỉ là một sự cố từ hệ thống máy tính. Cụ thể, Petrov lập luận rằng Hoa Kỳ sẽ không thể bắt đầu một cuộc chiến tranh thế giới bằng cách phóng chỉ 5 tên lửa. Anh ta bỏ qua các hướng dẫn mà mình đã được đào tạo và bằng trực giác của mình, vị Trung tá đã phán đoán chính xác tình huống, góp phần ngăn chặn một cuộc chiến tranh hạt nhân.

“Hóa ra nguyên nhân sâu xa của vụ việc là sự liên kết hiếm hoi của ánh sáng mặt trời trên các đám mây trên cao tạo ra những hiệu ứng giống như tên lửa. Như vậy chúng ta có thể thấy được hậu quả mà sự nhầm lẫn trên các hệ thống máy tính gây ra là nguy hiểm thế nào, thậm chí còn có thể châm ngòi cho một cuộc chiến tranh hạt nhân. Sẽ thế nào nếu lúc đó Liên Xô thực hiện các vụ phóng tên lửa đáp trả ngay lập tức? Và điều quan trọng là chúng ta phải nhận thức được sức mạnh thực sự của AI trong giải quyết vấn đề, nhưng đó cũng sẽ là con dao 2 lưỡi nếu nằm trong tay những kẻ xấu vốn đầy rẫy trên mạng”, Steve Grobman chia sẻ.

Bên cạnh đó, Grobman cũng cho biết bản thân ông luôn tin rằng công nghệ về bản chất chỉ là một công cụ vô tri, và nó có thể được áp dụng cho cả mục đích tốt lẫn xấu. Ví dụ, một sơ đồ tội phạm với dữ liệu về nơi xảy ra tội ác và nơi bắt giữ thủ phạm có thể được sử dụng để giúp cảnh sát phá án - hoặc nó cũng có thể được sử dụng bởi chính tội phạm để lẩn tránh sự truy đuổi của cảnh sát. Trong ví dụ khác, một chiếc máy bay đã được sử dụng để đánh bom dân thường, dẫn đến 2 triệu thương vong trong Thế chiến II. Khi được hỏi liệu có hối hận khi phát minh ra máy bay không, Orville Wright cho biết vào năm 1948 rằng ông xem nó giống như việc sử dụng lửa, có thể gây ra thiệt hại to lớn nếu hỏa hoạn xảy ra, nhưng vẫn được sử dụng cho hàng ngàn mục đích quan trọng. Và AI cũng vậy.

“Cái nhìn sâu sắc của Orville cho chúng ta thấy rằng về bản chất, công nghệ vốn dĩ không liên quan đến đạo đức, nó chỉ thực sự được cho là có lợi hay gây hại tùy thuộc vào cái cách mà người ta sử dụng, và đây cũng chính là thứ mà ngành công nghiệp của chúng ta, an ninh mạng, đang không ngừng đấu tranh!”

Công nghệ

Công nghệ  Windows

Windows  iPhone

iPhone  Android

Android  Học CNTT

Học CNTT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  macOS

macOS  Phần cứng

Phần cứng  Thủ thuật SEO

Thủ thuật SEO  Kiến thức cơ bản

Kiến thức cơ bản  Dịch vụ ngân hàng

Dịch vụ ngân hàng  Lập trình

Lập trình  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Nhà thông minh

Nhà thông minh  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets - Trang tính

Google Sheets - Trang tính  Code mẫu

Code mẫu  Photoshop CS6

Photoshop CS6  Photoshop CS5

Photoshop CS5  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Ứng dụng văn phòng

Ứng dụng văn phòng  Tải game

Tải game  Tiện ích hệ thống

Tiện ích hệ thống  Ảnh, đồ họa

Ảnh, đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Họp, học trực tuyến

Họp, học trực tuyến  Video, phim, nhạc

Video, phim, nhạc  Giao tiếp, liên lạc, hẹn hò

Giao tiếp, liên lạc, hẹn hò  Hỗ trợ học tập

Hỗ trợ học tập  Máy ảo

Máy ảo  Điện máy

Điện máy  Tủ lạnh

Tủ lạnh  Tivi

Tivi  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Quạt các loại

Quạt các loại  Cuộc sống

Cuộc sống  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Làm đẹp

Làm đẹp  Nuôi dạy con

Nuôi dạy con  Chăm sóc Nhà cửa

Chăm sóc Nhà cửa  Du lịch

Du lịch  Halloween

Halloween  Mẹo vặt

Mẹo vặt  Giáng sinh - Noel

Giáng sinh - Noel  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  TOP

TOP  Ô tô, Xe máy

Ô tô, Xe máy  Giấy phép lái xe

Giấy phép lái xe  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ nhân tạo (AI)

Trí tuệ nhân tạo (AI)  Anh tài công nghệ

Anh tài công nghệ  Bình luận công nghệ

Bình luận công nghệ