Ở thời đại phát triển nở rộ của internet cũng như các nền tảng truyền thông xã hội với hàng tỷ người dùng như hiện nay, tin giả đang thực sự trở thành một vấn nạn gây nhức nhối trên toàn thế giới. Deepfake chính là một phần trong mớ hỗn độn đó.

Deepfake là một kỹ thuật tổng hợp hình ảnh con người dựa trên trí tuệ nhân tạo (AI) bằng cách sử dụng một kỹ thuật học máy (machine learning) được gọi là Generative Adversarial Network. Với đặc điểm này, nó thường được sử dụng để tạo tin tức giả và những trò lừa đảo độc hại. Các video Deepfake bắt đầu tràn ngập internet vài năm trước khi các tác nhân xấu nhận ra rằng chúng có thể được sử dụng để bôi nhọ uy tín cá nhân, trục lợi trái phép và truyền bá thông tin chính trị sai sự thật. Với sự cải tiến liên tục của các thuật toán AI, Deepfake đang ngày càng trở nên khó phát hiện hơn bao giờ hết.

Để đối phó với vấn nạn Deepfake, các chuyên gia bảo mật đã phát triển những công cụ AI có thể phân tính thành phần mã cũng như từng chi tiết nhỏ nhất của hình ảnh, video ở cấp độ pixel nhằm phát hiện hành vi giả mạo. Thế nhưng khi mà công nghệ bảo mật này đang dần tỏ ra hiệu quả, khó khăn lại tiếp tục xuất hiện.

Một nhóm các nhà nghiên cứu đến từ Đại học San Diego mới đây đã tìm ra một phương pháp tương đối đơn giản để đánh lừa chính các hệ thống phát hiện video giả mạo dựa trên AI tối tân nhất hiện nay.

Theo đó, nhóm nghiên cứu đã thực hiện một vài tinh chỉnh về mã đối với các video giả mạo được tổng hợp bằng những phương pháp tạo Deepfake hiện có. Cụ thể là đối với codec nén hình ảnh và video, từ đó tạo ra các nhiễu loạn đối nghịch phức tạp khiến công cụ phát hiện Deepfake không thể phân tính được và để lọt nội dung giả mạo.

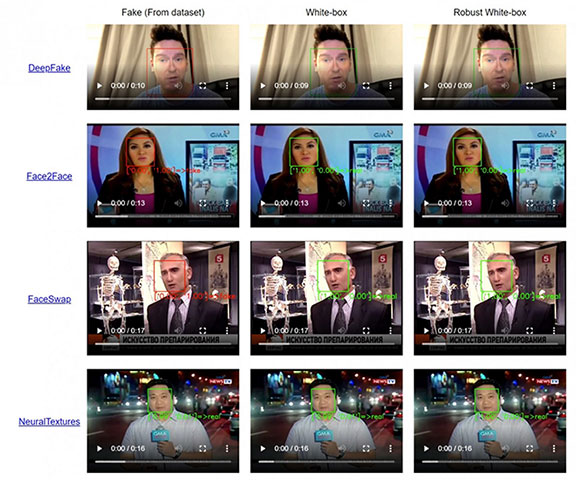

Hình ảnh đầu tiên bên dưới cho thấy công cụ phát hiện Deepfake hoạt động bình thường, trong khi video thứ hai cho thấy những gì xảy ra khi các nhà nghiên cứu thực hiện một vài tinh chỉnh được thiết kế để đánh lừa công cụ phát hiện Deepfake, mặc dù sự khác biệt là gần như không thể nhận ra bằng mắt thường.

Về cơ bản, các công cụ phát hiện video giả sẽ kiểm tra từng khung hình của video để xác định những thay đổi bất thường. Nhóm nghiên cứu Đại học San Diego đã phát triển một quy trình đưa thông tin gây nhiễu vào từng khung hình, khiến công cụ phát hiện Deepfake giả tưởng rằng đó video là bình thường.

Nghiên cứu này đã chỉ ra rằng các hệ thống phát hiện video giả mạo hiện đại vẫn chứa đựng những hạn chế nghiêm trọng. Về bản chất, có thể kết luận rằng những tác nhân độc hại “có tay nghề cao” hoàn toàn có thể tìm ra cách đánh lừa tất cả các công cụ nhận diện Deepfake hiện tại.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài