Song song với sự bùng nổ của lĩnh vực Trí tuệ nhân tạo, NVIDIA đã kiếm được rất nhiều tiền trong năm qua từ các công ty như Microsoft, OpenAI và hàng loạt ông lớn công nghệ khác nhờ những hợp đồng cung ứng GPU cao cấp cho mảng AI sáng tạo đầy tiềm năng. Tiếp nối thành công đó, hôm nay, NVIDIA tiếp tục công bố thế hệ GPU AI mới hứa hẹn mang lại cho tốc độ và hiệu suất tối ưu hơn nữa cho các dịch vụ AI quy mô lớn.

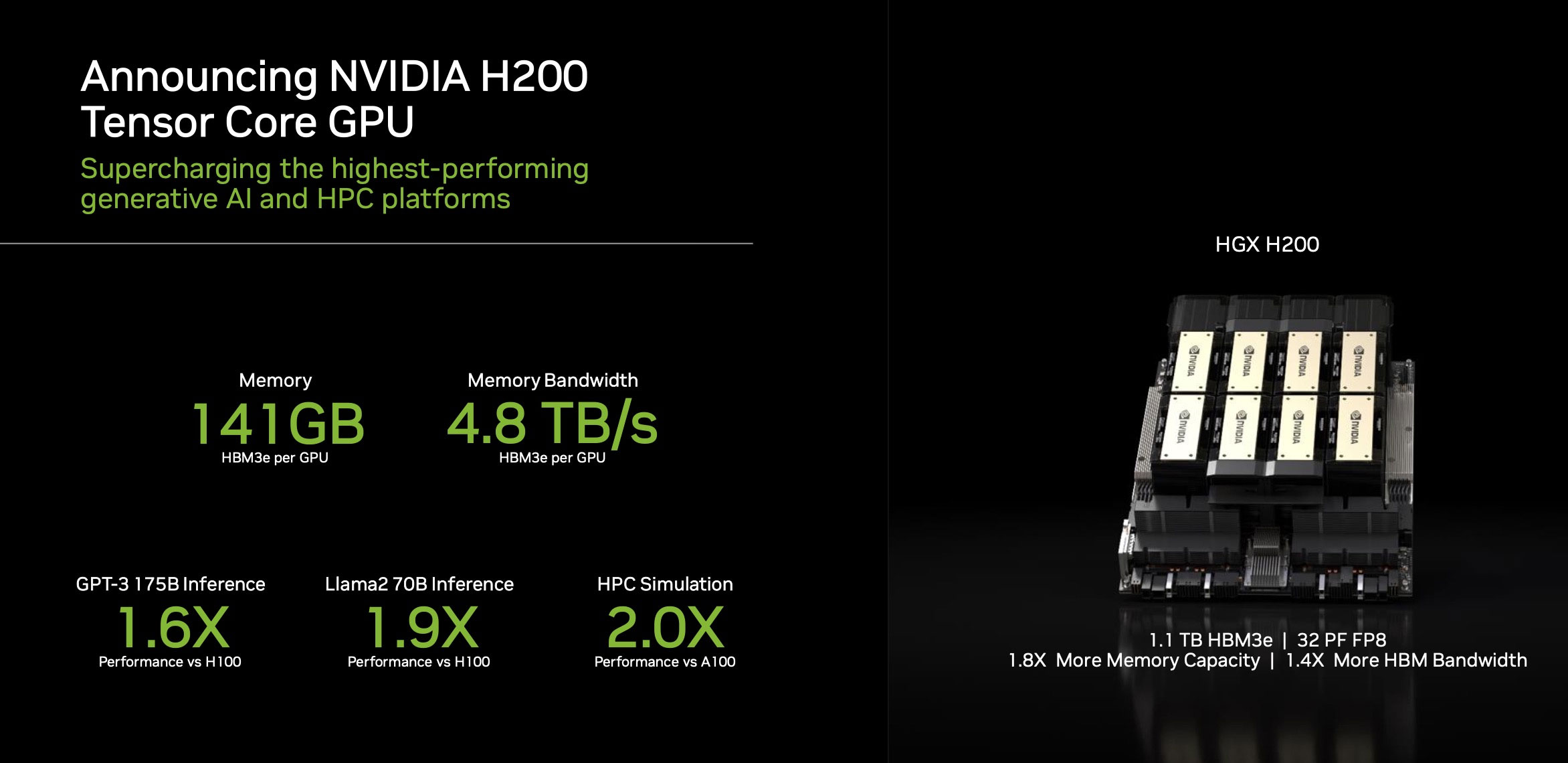

NVIDIA vừa chính thức trình làng HGX H200, giải pháp đồ họa mới dựa trên kiến trúc chip Hopper và GPU H200 Tensor Core của công ty. HGX H200 là mẫu GPU đầu tiên cung cấp HBM3e — bộ nhớ lớn hơn, nhanh hơn để thúc đẩy khả năng xử lý những tác vụ nặng của AI tổng hợp và các mô hình ngôn ngữ lớn, đồng thời thúc đẩy tính toán khoa học cho khối lượng công việc HPC. Với HBM3e, NVIDIA H200 cung cấp bộ nhớ 141GB tốc độ 4,8 terabyte/giây, gần gấp đôi về dung lượng và băng thông gấp 2,4 lần so với người tiền nhiệm A100.

Ngoài ra, NVIDIA cũng tuyên bố rằng CPU mới sẽ cung cấp tốc độ suy luận nhanh gần gấp đôi so với H100 khi chạy mô hình ngôn ngữ lớn Llama 2.

Công ty cho biết một số nền tảng đám mây hàng đầu trong ngành, bao gồm Microsoft Azure, Amazon Web Services, Google Cloud và Oracle Cloud Infrastructure đều đã đăng ký mua GPU HGX H200. Mẫu GPU mới này có thể được sử dụng trong cấu hình bốn và tám chiều, tương thích với hệ thống phần cứng và phần mềm HGX H100 cũ hơn. Trong đó, HGX H200 tám chiều cung cấp hơn 32 petaflop hiệu năng điện toán học sâu FP8 và 1,1TB bộ nhớ băng thông cao tổng hợp để mang lại hiệu suất cao nhất trong các ứng dụng AI và HPC tổng hợp.

Bên cạnh đó, một số đối tác phần cứng máy chủ, bao gồm ASRock Rack, ASUS, Dell Technologies, GIGABYTE, Hewlett Packard Enterprise, Lenovo và một số công ty khác cũng đang có kế hoạch nâng cấp hệ thống H100 hiện tại lên H200 mới.

GPU HGX H200 sẽ xuất hiện trong hệ thống của các công ty máy chủ PC và dịch vụ đám mây đó vào khoảng quý 2 năm 2024. Trước đó, NVIDIA cũng đã công bố nền tảng AI thế hệ GH200 Grace Hopper, dự kiến sẽ xuất xưởng vào quý 2 năm 2024.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài