Google hôm nay đã chính thức giới thiệu TensorFlow Lite 1.0, công cụ dành riêng cho nhà phát triển trong việc khai các mô hình AI trên thiết bị di động và IoT. Những cải tiến chính bao gồm đăng ký và lượng tử hóa có chọn lọc trong và sau khi đào tạo cho các mô hình nhỏ, nhanh chóng hơn. Lượng tử hóa đã có thể khiến một số mô hình AI được nén tới 4 lần.

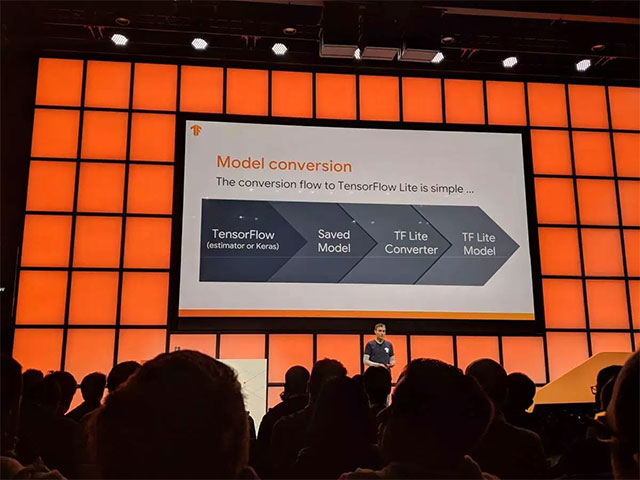

Lite bắt đầu bằng việc đào tạo các mô hình AI trên TensorFlow, sau đó được chuyển đổi để tạo ra những mô hình Lite có thể hoạt động được trên thiết bị di động. Lite được giới thiệu lần đầu tiên tại hội nghị nhà phát triển I/O vào tháng 5 năm 2017, và bản xem trước (preview) đã được tung ra vào cuối năm đó.

Nhóm phụ trách TensorFlow Lite tại Google cũng đã trình bày lộ trình phát triển nền tảng này trong tương lai vào ngày hôm nay. Theo đó, trọng tâm chính trong việc phát triển TensorFlow Lite là nhằm thu nhỏ và tăng tốc các mô hình AI, đặc biệt là tạo điều kiện cho các nhà phát triển Android trong việc sử dụng mạng lưới thần kinh, cũng như bộ kết nối dựa trên Keras và cải tiến lượng tử hóa bổ sung.

Một số thay đổi điển hình khác có thể kể đến như:

- Hỗ trợ luồng điều khiển, đây là nhân tố cần thiết cho hoạt động của các mô hình như mạng thần kinh lặp (recurrent neural networks).

- Tối ưu hóa hiệu suất CPU với các mô hình Lite, có khả năng liên quan đến quan hệ đối tác với những công ty khác.

- Mở rộng phạm vi hoạt động của GPU và hoàn thiện API để sẵn sàng đưa vào sử dụng.

Bộ chuyển đổi mô hình TensorFlow 2.0 để tạo các mô hình Lite sẽ được cung cấp cho các nhà phát triển nhằm giúp họ hiểu rõ hơn về những nhầm lẫn có thể xảy ra trong quy trình chuyển đổi và cách thức khắc phục. Theo phát biểu của kỹ sư Raziel Alvarez trên sân khấu Hội nghị thượng đỉnh TensorFlow Dev thì TensorFlow Lite hiện đang được triển khai và sử dụng bởi hơn 2 tỷ thiết bị trên toàn thế giới. Bên cạnh đó, sự đổi mới không ngừng của TensorFlow Lite cũng đã khiến cho TensorFlow Mobile ngày càng trở nên lỗi thời hơn.

Trong thời gian vừa qua, một loạt các kỹ thuật mới đã và đang được khám phá giúp làm giảm kích thước của các mô hình AI và tối ưu hóa chúng để sử dụng được trên các thiết bị di động, chẳng hạn như lượng tử hóa và delegates (các lớp được sắp xếp theo cấu trúc để triển khai nhiều biểu đồ khác nhau trong phần cứng nhằm cải thiện tốc độ suy luận).

Ngoài ra, tính năng tăng tốc GPU di động cho một số thiết bị cũng đã được cung cấp trong bản preview dành cho nhà phát triển vào tháng 1 vừa qua. Tính năng này có thể tối ưu hóa việc triển khai mô hình nhanh hơn từ 2 đến 7 lần so với CPU dấu phẩy động (floating point CPU). Các delegate của Edge TPU có thể tăng tốc độ nhanh hơn 64 lần so với floating point CPU.

Trong tương lai, Google có kế hoạch làm cho các delegate GPU trở nên hữu dụng hơn, mở rộng phạm vi và hoàn thiện API.

Một số ứng dụng và dịch vụ gốc của Google sử dụng TensorFlow Lite, bao gồm GBoard, Google Photos, AutoML và Nest. Tất cả yêu cầu tính toán đối với các mô hình CPU khi Google Assistant cần trả lời những truy vấn trong trạng thái ngoại tuyến hiện đã được Lite thực hiện. Ngoài ra, Lite cũng có thể chạy trên các thiết bị như Raspberry Pi và Coral Dev Board mới.

Bên cạnh TensorFlow Lite, trong ngày hôm nay, Google cũng đã giới thiệu bản phát hành alpha của TensorFlow 2.0 cho trải nghiệm người dùng đơn giản hóa hơn, TensorFlow.js 1.0, và phiên bản 0.2 của TensorFlow dành cho các nhà phát triển viết mã bằng ngôn ngữ lập trình Apple Swift. Đồng thời TensorFlow Federated và TensorFlow Privacy cũng đã được phát hành sớm trong ngày hôm nay.

Lite cho Core ML - framework học máy của Apple đã được giới thiệu vào tháng 12 năm 2017. Các mô hình TensorFlow Lite tùy chỉnh cũng có thể hoạt động với ML Kit, đây có thể là một cách nhanh chóng để các nhà phát triển tạo mô hình AI cho thiết bị di động, được giới thiệu vào năm ngoái cho các nhà phát triển Android và iOS sử dụng Firebase.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài