Mới đây, Google đã chính thức trình làng Gemini, mô hình AI tiên tiến và tổng quát nhất từ trước đến nay của hãng.

Gemini là gì?

Google Gemini là một nhóm các mô hình AI, giống như GPT của OpenAI. Sự khác biệt chính là mặc dù Gemini có thể hiểu và tạo văn bản giống như các LLM khác, nhưng nó cũng có thể hiểu, vận hành và kết hợp các loại thông tin khác như hình ảnh, âm thanh, video và code. Ví dụ, bạn có thể đưa ra lời nhắc như "điều gì đang xảy ra trong bức ảnh này?" và đính kèm một hình ảnh, nó sẽ mô tả hình ảnh đó và phản hồi các lời nhắc tiếp theo yêu cầu thông tin phức tạp hơn.

Bởi vì chúng ta hiện đã bước vào kỷ nguyên cạnh tranh của các doanh nghiệp AI, nên hầu hết mọi công ty đều không tiết lộ những chi tiết cụ thể về cách hoạt động và sự khác biệt trong mô hình của họ. Tuy nhiên, Google đã xác nhận rằng các mô hình Gemini sử dụng kiến trúc máy biến áp và dựa vào những chiến lược như đào tạo trước và tinh chỉnh, giống như các LLM khác, tương tự điều GPT-4 đã làm. Sự khác biệt chính giữa Gemini và LLM thông thường là nó đồng thời được đào tạo về hình ảnh, âm thanh, video và cả văn bản; chúng không phải là kết quả của một mô hình riêng biệt được cố định ở cuối.

Về lý thuyết, điều này có nghĩa là nó hiểu mọi thứ theo cách trực quan hơn. Lấy một cụm từ như "monkey business": Nếu AI chỉ được đào tạo về các hình ảnh được gắn thẻ "monkey" và "business", nó có thể chỉ nghĩ đến những con khỉ mặc vest khi được yêu cầu vẽ thứ gì đó liên quan đến "monkey business". Mặt khác, nếu AI hiểu được cả hình ảnh và ngôn ngữ cùng lúc thì toàn bộ mô hình sẽ hiểu sâu hơn về nghĩa bóng của cụm từ.

Mặc dù tất cả những điều này khiến Google Gemini trở nên thú vị hơn nhưng không khiến nó trở nên độc đáo: GPT-4 Vision (GPT-4V), một mô hình đa phương thức tương tự của OpenAI, cũng đã bổ sung tính năng xử lý hình ảnh cho các khả năng LLM của GPT-4.

Gemini của Google là mô hình AI tiên tiến và tổng quát nhất từ trước đến nay

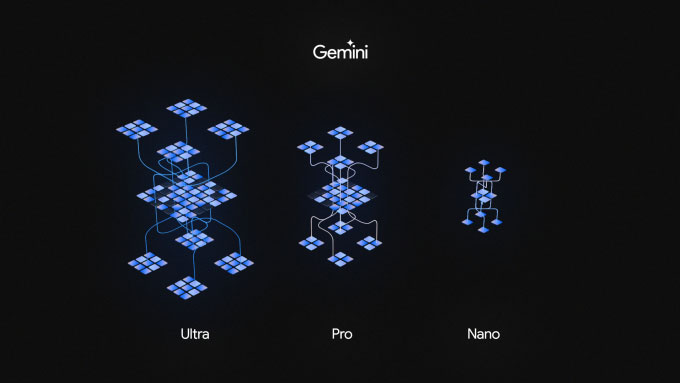

Gemini 1.0 ban đầu được cung cấp dưới ba kích cỡ khác nhau gồm: Gemini Ultra, Gemini Pro và Gemini Nano đáp ứng nhu cầu sử dụng linh hoạt, từ các trung tâm dữ liệu cho tới thiết bị di động. Trong đó, Gemini Ultra là mô hình kích thước lớn nhất và mạnh mẽ nhất.

Gemini được xây dựng theo hướng đa phương thức, có thể khái quát, vận hành và kết hợp nhiều loại thông tin khác nhau bao gồm văn bản, code, âm thanh, hình ảnh và video.

Theo kết quả thử nghiệm được Google công bố, phiên bản mạnh nhất, Gemini Ultra đạt điểm 90% trong bài kiểm tra khả năng hiểu ngôn ngữ đa nhiệm lớn (MMLU - Massive Multitask Language Understanding). Mô hình này tổng hợp kiến thức từ 57 môn học để giải quyết vấn đề, là AI đầu tiên vượt qua con người ở cấp độ chuyên gia, vốn có điểm 89,8% trong bài kiểm tra tương tự. Trong khi đó, GPT-4 đạt kết quả là 87%, LLAMA-2 đạt 68% và Claude 2 của Anthropic đạt 78,5%.

Ngoài ra, Gemini Ultra còn đạt điểm 59,4% về khả năng MMMU (hiểu biết lớn về đa phương thức trên đa ngành), vượt 30 trong số 32 tiêu chuẩn trong nghiên cứu và phát triển mô hình ngôn ngữ lớn.

Demis Hassabis, CEO Google DeepMind, đại diện Đội ngũ Gemini, cho biết, mục tiêu của công ty là xây dựng thế hệ mô hình AI mới hữu ích và trực quan hơn, tương tự như một cộng sự cho người dùng.

Ngoài hiệu suất mạnh mẽ, Gemini 1.0 còn được đào tạo để nhận diện văn bản, hình ảnh, âm thanh cùng nhiều loại hình khác trong cùng một thời điểm, giúp nó hiểu rõ hơn thông tin và đưa ra câu trả lời cho câu hỏi có chủ đề phức tạp. Mô hình này cũng có thể giải thích, và viết code bằng Python, Java, C++ và Golang.

Gemini bản Ultra là phiên bản dành cho các tác vụ phức tạp nhất và vẫn đang trong quá trình thử nghiệm. Gemini Nano là bản dành cho các tác vụ thực hiện trên thiết bị di động. Pixel 8 Pro là thiết bị đầu tiên được trang bị AI này và sẽ có thêm một số khả năng như tóm tắt nội dung ghi âm, trả lời thông minh trên bàn phím Gboard. Google sẽ tung 2 phiên bản này ra thị trường vào năm sau.

Trong khi đó, bản Pro hiện đã sử dụng trong chatbot Bard cho phép người dùng có thể thay đổi thông qua một số yêu cầu về về đọc hiểu, tóm tắt, lý luận, lập trình và lập kế hoạch. Bard sử dụng Gemini Pro hiện đã có thể sử dụng ở 180 quốc gia và vùng lãnh thổ nhưng mới chỉ hỗ trợ tiếng Anh.

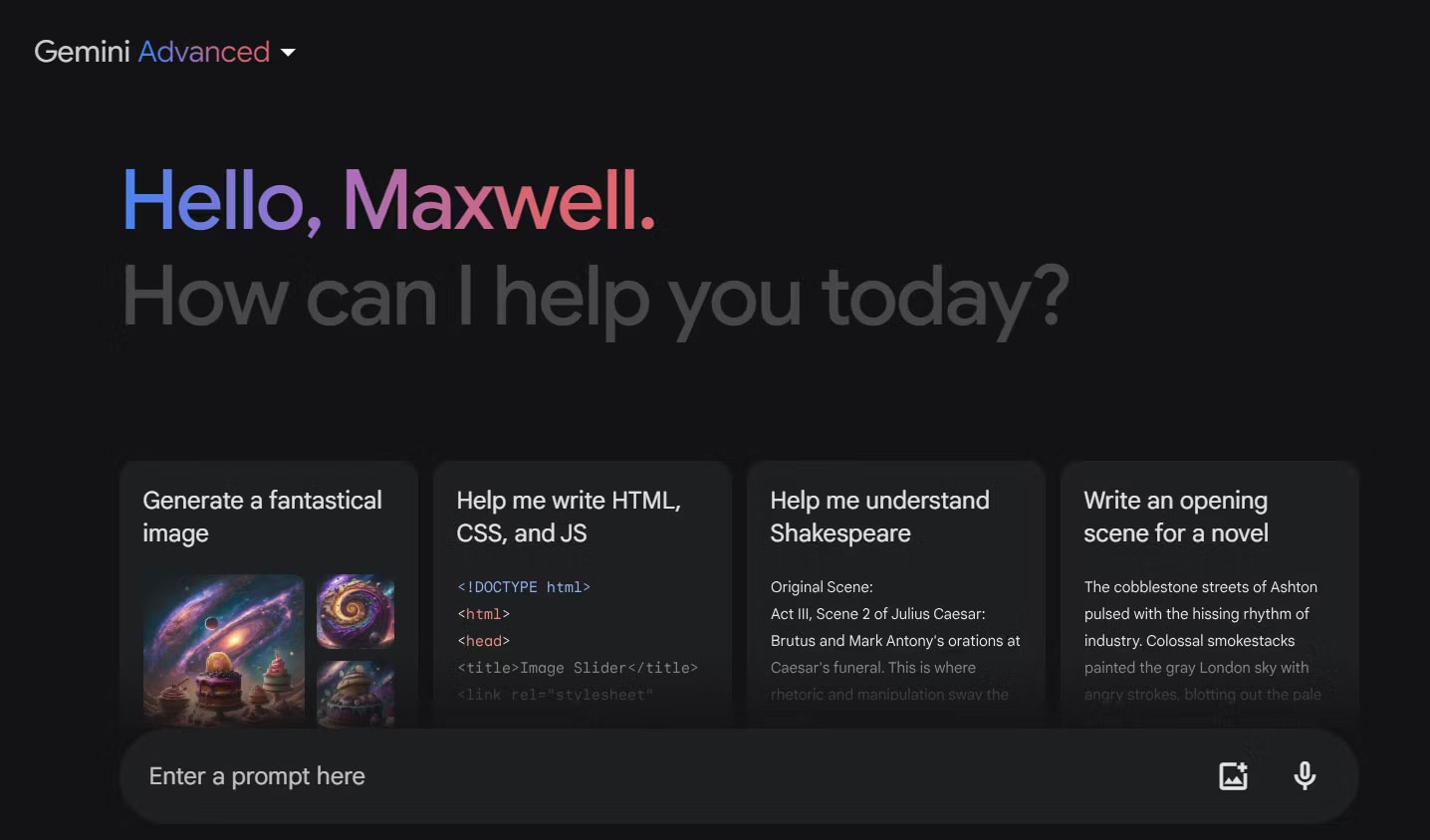

Google giới thiệu công cụ Deep Research cho Gemini

Lần này, Google tung ra một bản cập nhật tập trung vào hiệu quả khác, bao gồm một công cụ sẽ chuyển đổi nghiên cứu phức tạp thành báo cáo dễ hiểu.

Hầu hết chúng ta đều quen với việc hỏi những câu hỏi thông thường với trợ lý ảo, chẳng hạn như yêu cầu công thức làm bánh taco chay hoặc tò mò về tốc độ bơi của gấu Bắc Cực. Chắc chắn, những cuộc trò chuyện cơ bản này có thể giúp bạn tiết kiệm một chút thời gian phân tích kết quả tìm kiếm, nhưng Google đang đưa tiềm năng tiết kiệm thời gian của Gemini lên một tầm cao mới với một tính năng có tên là Deep Research, dành cho các truy vấn phức tạp hơn.

Bản cập nhật mới nhất của Google sẽ cung cấp Deep Research cho những người trả phí cho Gemini Advanced. Công cụ này hứa hẹn sẽ giúp bạn tiết kiệm "nhiều giờ nghiên cứu và tham chiếu chéo một loạt các tab đang mở", như Google cho biết. Chỉ trong vài phút, Gemini có thể biến một câu hỏi nghiên cứu đa chiều thành một báo cáo chi tiết về các phát hiện, trích dẫn nguồn trong suốt quá trình.

Lưu ý: Gemini cũng sẽ cung cấp cho bạn tùy chọn xuất phản hồi của mình vào Google Doc.

Mặc dù Gemini sẽ bao gồm nguồn với công cụ mới này, cho phép bạn kiểm tra công việc của mình để tìm ra những diễn giải sai hoặc ảo giác tiềm ẩn, nhưng điều này dường như đi ngược lại lời hứa tiết kiệm thời gian của Google. Ở giai đoạn trí tuệ nhân tạo này, hầu hết mọi người không coi dữ liệu do AI cung cấp là giá trị thực.

Điều này thường theo yêu cầu của công ty đứng sau mô hình, với các cửa sổ trò chuyện vẫn có những tuyên bố từ chối trách nhiệm khuyến nghị bạn "kiểm tra lại" công việc của mình. Theo đó, việc kiểm tra thông tin do AI tạo ra là một trong những việc quan trọng nhất mà sinh viên nên cân nhắc khi sử dụng các công cụ AI.

Trong trường hợp Deep Research, Google dường như dập tắt nỗi sợ này bằng cách tuyên bố rằng bạn sẽ được giám sát trong suốt quá trình:

"Dưới sự giám sát của bạn, Deep Research sẽ thực hiện công việc khó khăn thay bạn. Sau khi bạn nhập câu hỏi, nó sẽ tạo một kế hoạch nghiên cứu nhiều bước để bạn có thể sửa đổi hoặc phê duyệt. Sau khi bạn phê duyệt, nó sẽ bắt đầu phân tích sâu thông tin có liên quan từ khắp trang web thay mặt bạn".

Tuy nhiên, việc phê duyệt một kế hoạch nghiên cứu không có nghĩa là dữ liệu trả về nhất thiết sẽ chính xác.

Trong trường hợp bạn không tin vào hiệu quả thực sự của tính năng Deep Research, bạn cũng có thể xem Gemini 2.0 Flash Experimental. Được công bố cùng với bản cập nhật, phiên bản đầu tiên của mô hình Gemini tiếp theo của Google này được cho là sẽ chứng minh tốc độ phản hồi tốt hơn.

Lưu ý: Tại thời điểm viết bài, mô hình thử nghiệm chỉ khả dụng trên trình duyệt desktop hoặc thiết bị di động và vẫn chưa khả dụng trên ứng dụng di động.

Chắc chắn sẽ có điều tốt và điều xấu với sự phát triển của trợ lý AI và các tính năng như Deep Research cũng không ngoại lệ. Tuy nhiên, trong khi một công cụ như Deep Research có thể giúp bạn không phải làm những việc nặng nhọc, thì nghiên cứu kém có thể khiến bạn mất nhiều thời gian hơn (và có khả năng gây ra các vấn đề nghiêm trọng) về sau này.

Google công bố Gemini 1.5 với cửa sổ ngữ cảnh được mở rộng đáng kể

Sau khi ra mắt phiên bản 1.0 vào tháng 12/2023, Google hôm qua đã công bố Gemini 1.5 là model thế hệ tiếp theo với “hiệu suất được nâng cao đáng kể”.

Một trong những cải tiến chính trên Gemini 1.5 là cửa sổ ngữ cảnh lớn hơn đáng kể.

“Cửa sổ ngữ cảnh” của mô hình AI được tạo thành từ các token, là những building block được sử dụng để xử lý thông tin. Token có thể là toàn bộ các phần hoặc phần phụ của từ, hình ảnh, video, âm thanh hoặc code. Cửa sổ ngữ cảnh của mô hình càng lớn thì càng có thể tiếp nhận và xử lý nhiều thông tin hơn trong một lời nhắc nhất định - làm cho kết quả đầu ra của mô hình nhất quán, phù hợp và hữu ích hơn.

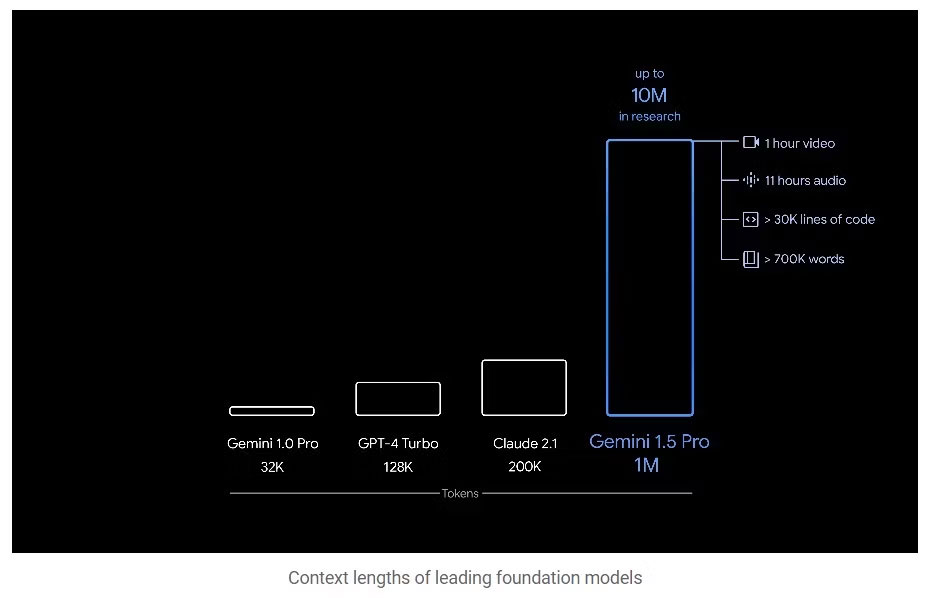

Gemini 1.5 Pro - cấp trung bình của Google - có cửa sổ ngữ cảnh tiêu chuẩn gồm 128.000 token (so với 32.000 token của Gemini 1.0). Điều này có nghĩa là hơn 700.000 từ, cơ sở code với hơn 30.000 dòng code, 11 giờ âm thanh hoặc 1 giờ video. GPT-4 Turbo cũng ở mức 128.000 và Claude 2.1 cung cấp 200.000. Ví dụ về điều đó trong hành động bao gồm:

“1.5 Pro có thể phân tích, phân loại và tóm tắt liền mạch lượng lớn nội dung trong một lời nhắc nhất định. Ví dụ, khi được cung cấp bản ghi dài 402 trang từ sứ mệnh lên mặt trăng của Apollo 11, nó có thể suy luận về các cuộc trò chuyện, sự kiện và chi tiết được tìm thấy trong tài liệu”.

“1.5 Pro có thể thực hiện các nhiệm vụ hiểu và suy luận rất phức tạp cho nhiều phương thức khác nhau, bao gồm cả video. Ví dụ, khi được xem một bộ phim câm Buster Keaton dài 44 phút, model có thể phân tích chính xác các điểm và sự kiện khác nhau trong cốt truyện, thậm chí có thể suy luận về những chi tiết nhỏ trong phim có thể dễ dàng bị bỏ qua”.

“1.5 Pro có thể thực hiện các tác vụ giải quyết vấn đề phù hợp hơn trên những block code dài hơn. Khi được đưa ra lời nhắc có hơn 100.000 dòng code, nó có thể suy luận tốt hơn qua các ví dụ, đề xuất những sửa đổi hữu ích và đưa ra giải thích về cách hoạt động của các phần khác nhau trong code”.

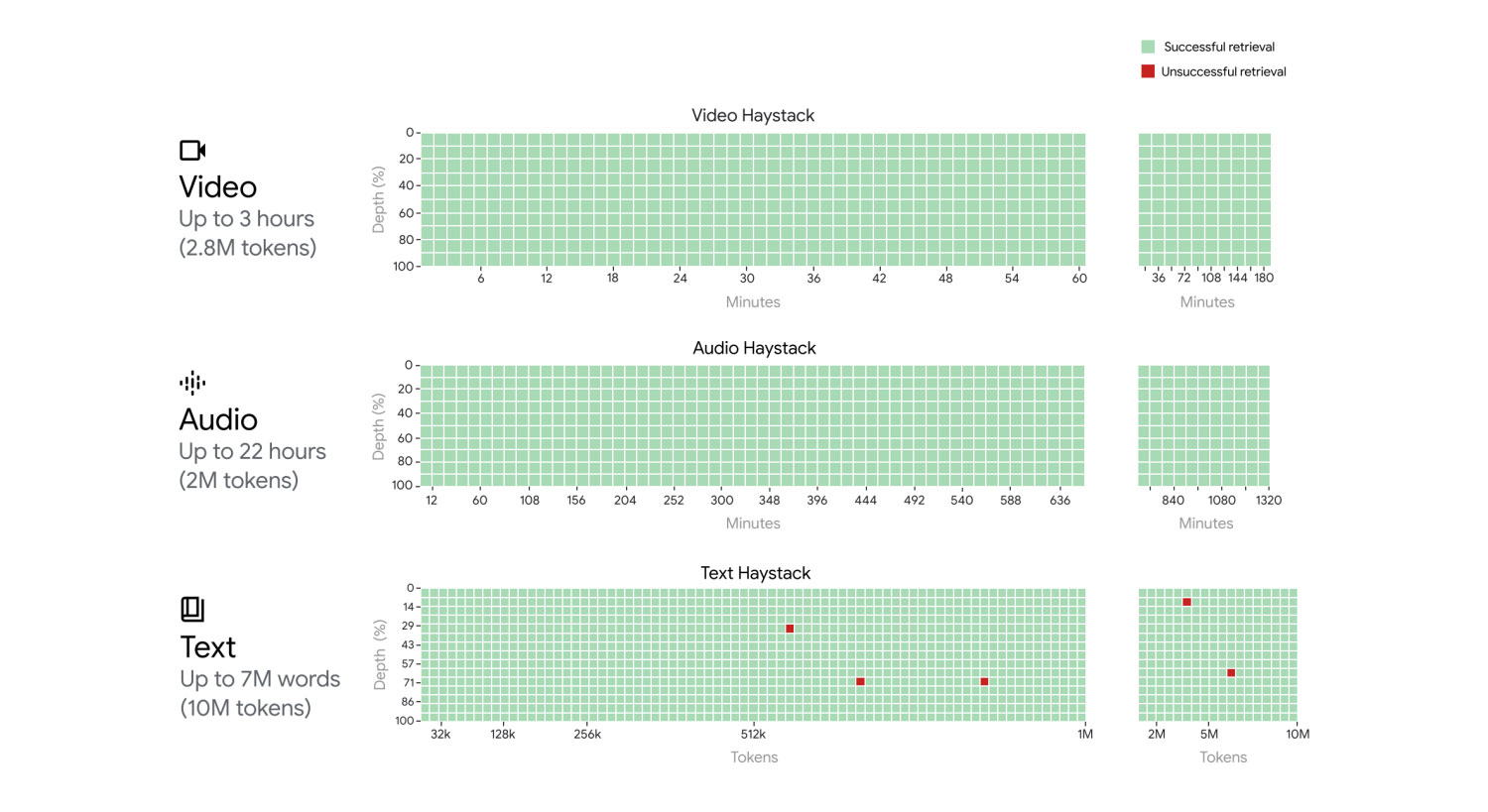

Điều đáng chú ý hơn là Google đã sản xuất tới 1 triệu token và đang cung cấp token đó cho một số người thử nghiệm ban đầu, đồng thời công ty cũng đã “thử nghiệm thành công tới 10 triệu token”.

Những tiến bộ này có thể thực hiện được nhờ kiến trúc Mixture-of-Experts (MoE) mới, trong đó các mô hình được “chia thành những mạng nơ-ron nhân tạo ‘chuyên gia’ nhỏ hơn”. Điều này làm cho Gemini 1.5 trở nên hiệu quả hơn trong cả việc huấn luyện và phục vụ.

Tùy thuộc vào loại đầu vào được cung cấp, các mô hình MoE học cách chỉ kích hoạt có chọn lọc những lộ trình chuyên gia phù hợp nhất trong mạng nơ-ron nhân tạo của nó. Chuyên môn hóa này nâng cao đáng kể hiệu quả của mô hình.

Về hiệu suất, 1.5 Pro vượt trội hơn 1.0 Pro ở 87% điểm chuẩn trên các bài đánh giá văn bản, code, hình ảnh, âm thanh và video. Nó thậm chí còn “hoạt động ở mức tương tự” như 1.0 Ultra.

Gemini 1.5 Pro cũng thể hiện kỹ năng “học theo ngữ cảnh” ấn tượng, nghĩa là nó có thể học một kỹ năng mới từ thông tin được cung cấp trong thời gian dài mà không cần tinh chỉnh thêm.

Gemini 1.5 Pro (cửa sổ ngữ cảnh 128.000 token) đang ra mắt dưới dạng bản xem trước có giới hạn dành cho các nhà phát triển và khách hàng doanh nghiệp thông qua AI Studio và Vertex AI. Nó vẫn đang được thử nghiệm trong giai đoạn này.

Sắp tới, Google dự định giới thiệu các mức giá bắt đầu ở khung ngữ cảnh tiêu chuẩn 128.000 và mở rộng quy mô lên tới 1 triệu token khi cải thiện mô hình.

Tại sao ngữ cảnh 1 triệu token của Gemini 1.5 lại là yếu tố thay đổi cuộc chơi?

Nói một cách rõ ràng hơn, cửa sổ ngữ cảnh 200k của Claude AI có nghĩa là nó có thể hiểu một cuốn sách khoảng 150.000 từ và đưa ra câu trả lời cho cuốn sách đó. Rất án tượng! Nhưng Gemini 1.5 của Google thậm chí còn có thể xử lý được 700.000 từ một lúc!

Khi bạn đưa một khối văn bản lớn vào các chatbot AI như ChatGPT hoặc Gemini, nó sẽ cố gắng xử lý càng nhiều văn bản càng tốt, nhưng khối lượng văn bản có thể xử lý được là bao nhiêu tùy thuộc vào cửa sổ ngữ cảnh của nó. Vì vậy, nếu bạn có một cuộc trò chuyện dài tới 100 nghìn từ trên một mô hình chỉ có thể xử lý 28 nghìn từ và sau đó bắt đầu đặt những câu hỏi yêu cầu cuộc trò chuyện đó phải có kiến thức đầy đủ về toàn bộ 100 nghìn từ của cuộc trò chuyện, thì bạn sẽ thất bại.

Hãy tưởng tượng bạn chỉ xem 20 phút của một bộ phim dài một giờ nhưng được yêu cầu giải thích toàn bộ bộ phim. Kết quả sẽ như thế nào? Bạn phải từ chối trả lời hoặc bịa thông tin, đó chính xác là những gì một chatbot AI sẽ làm, dẫn đến ảo giác AI.

Bây giờ, nếu bạn đang nghĩ rằng mình chưa bao giờ phải đưa 100 nghìn từ vào chatbot thì đó không phải là toàn bộ vấn đề cần cân nhắc. Cửa sổ ngữ cảnh chỉ vượt qua văn bản bạn cung cấp cho mô hình AI trong một lời nhắc duy nhất. Các mô hình AI xem xét toàn bộ cuộc trò chuyện mà bạn đã thực hiện trong phiên trò chuyện để đảm bảo phản hồi của chúng phù hợp nhất có thể.

Vì vậy, mặc dù bạn không cung cấp cho nó một cuốn sách 100 nghìn từ, nhưng các cuộc trò chuyện qua lại của bạn và những câu trả lời mà nó cung cấp đều được tính vào cửa sổ ngữ cảnh. Bạn thắc mắc tại sao ChatGPT hoặc Gemini của Google cứ quên những điều bạn đã nói trước đó trong một cuộc trò chuyện? Nguyên nhân là nó có thể đã hết dung lượng cửa sổ ngữ cảnh và bắt đầu quên nội dung.

Cửa sổ ngữ cảnh lớn hơn đặc biệt quan trọng đối với các tác vụ đòi hỏi sự hiểu biết sâu sắc về ngữ cảnh, chẳng hạn như tóm tắt những bài viết dài, trả lời các câu hỏi phức tạp hoặc duy trì một câu chuyện mạch lạc trong văn bản được tạo. Bạn muốn viết một cuốn tiểu thuyết dài 50 nghìn từ có cách kể chuyện nhất quán xuyên suốt? Bạn muốn một mô hình có thể "xem" và trả lời các câu hỏi trên file video dài một giờ? Bạn cần một cửa sổ ngữ cảnh lớn hơn!

Nói tóm lại, cửa sổ ngữ cảnh lớn hơn của Gemini 1.5 có thể cải thiện đáng kể hiệu suất cho mô hình AI của nó, giảm hiện tượng ảo giác và tăng đáng kể độ chính xác cũng như khả năng làm theo hướng dẫn tốt hơn.

Có thể mong đợi những gì từ Google Gemini 1.5?

May mắn thay, Google đã cung cấp khá nhiều thông tin công khai về những gì có thể mong đợi từ phiên bản 1.5.

Điểm mấu chốt: Gemini 1.5 tăng gấp đôi trên thị trường chuyên nghiệp với việc giới thiệu một số khả năng ấn tượng làm nổi bật tốc độ phát triển của AI. Ngày phát hành công khai vẫn chưa được công bố.

Một bài đăng trên blog của Google, trong đó Giám đốc điều hành Alphabet Sundar Pichai lưu ý rằng Gemini 1.5 "cho thấy những cải tiến đáng kể trên một số khía cạnh và ... đạt được chất lượng tương đương với 1.0 Ultra, trong khi sử dụng ít tính toán hơn". Điều đó nghe có vẻ khá hay, nhưng khả năng hiểu ngữ cảnh dài của 1.5 mới thực sự là điểm nổi bật.

Việc hiểu ngữ cảnh dài sẽ tăng cường tính liên tục trong quá trình xử lý

Một bước tiến lớn về hiểu ngữ cảnh là tiến bộ đáng chú ý nhất mà Gemini 1.5 Pro mang lại. Lượng thông tin mà một mô hình ngôn ngữ lớn như Gemini có thể xử lý trong một lần tương tác được thể hiện bằng token. Trong khi mô hình Gemini 1.0 Pro, hỗ trợ phiên bản Gemini miễn phí hiện tại, có giới hạn khoảng 32.000 token đầu vào cho mỗi lần tương tác, thì Gemini 1.5 Pro có thể quản lý khoảng 1 triệu token.

Với cửa sổ ngữ cảnh 1 triệu token, Gemini 1.5 vượt trội đáng kể so với nhiều mô hình AI tiêu dùng khác. Nó đánh bại tùy chọn dẫn đầu hiện tại, Claude, gấp 5 lần và vượt qua mô hình Gemini miễn phí hiện tại khoảng 30 lần. Như đã đề cập ở trên, Google cho biết Gemini 1.5 Pro sẽ có hiệu suất tương tự như model Gemini 1.0 Ultra hỗ trợ Gemini Advanced cao cấp của Google, nhưng đồng thời chạy hiệu quả hơn.

Để rõ ràng, hiểu ngữ cảnh đề cập đến lượng thông tin mà một mô hình ngôn ngữ có thể xử lý một cách liên tục. Sự hiểu biết về ngữ cảnh được đo lường trong các cửa sổ ngữ cảnh, tạo thành từ các token. Đổi lại, token bao gồm các từ, hình ảnh, video, âm thanh hoặc code. Gemini 1.5 có thể suy luận về các loại file khác nhau trong cửa sổ ngữ cảnh của nó, cho phép người dùng upload lên video, văn bản và thậm chí cả kho lưu trữ code để phân tích.

Ví dụ, Gemini 1.5 có thể xử lý hơn 700.000 từ văn bản hoặc một giờ video. Mặc dù điều đó vẫn có thể không phù hợp với các ứng dụng video nặng nhất, nhưng bạn có thể thấy mọi thứ sẽ tiến triển nhanh như thế nào với giới hạn 10 triệu token đã sắp xuất hiện.

Google đã nghiên cứu kiến trúc Mixture-of-Experts (MoE) được vài năm, nhưng 1.5 là mô hình Gemini đầu tiên sử dụng công nghệ này. MoE có nghĩa là Gemini định tuyến các yêu cầu đến những mạng nơ-ron nhân tạo chuyên biệt, nhỏ hơn để cải thiện tốc độ và chất lượng phản hồi. Đây không phải là ngẫu nhiên, vì kiến trúc MoE sẽ đặc biệt hữu ích trong việc giúp xử lý hiệu quả các cửa sổ ngữ cảnh dài.

Tốc độ đáng kinh ngạc của AI

Có thể chắc chắn rằng Google sẽ tập trung vào việc thúc đẩy việc tích hợp Gemini vào các ứng dụng dành cho nhà phát triển bên thứ ba. Phân khúc này rõ ràng đang được chào đón bằng việc phát hành trước Gemini 1.5 trong Google AI Studio mới của công ty, bao gồm một bộ công cụ dành cho nhà phát triển AI.

Gemini 1.5 là dấu hiệu cho thấy công nghệ AI đang phát triển nhanh như thế nào. Nó tập trung vào sự hiểu biết về bối cảnh dài hạn và lý luận đa phương thức là một hoạt động mạnh mẽ đối với thị trường chuyên nghiệp. Khi Google tiếp tục tích hợp Gemini vào hệ sinh thái nhà phát triển, có vẻ như chúng ta có thể mong đợi được thấy một thế hệ ứng dụng dựa trên thông tin mới sẽ sớm xuất hiện.

Liệu Gemini 1.5 có đáp ứng được kỳ vọng không?

Nếu mọi thứ diễn ra theo đúng kế hoạch, Gemini 1.5 có thể hoạt động tốt hơn các mô hình AI tốt nhất trên thị trường. Tuy nhiên, xét đến nhiều thất bại của Google trong việc xây dựng một mô hình AI ổn định, điều quan trọng là bạn phải hết sức thận trọng. Việc tăng cường cửa sổ ngữ cảnh của một mô hình không tự động làm cho mô hình đó tốt hơn.

Liệu Google Gemini 1.5 có mang đến cho chúng ta yếu tố thay đổi cuộc chơi không? Mạng xã hội hiện tràn ngập những đánh giá tích cực về Gemini 1.5 từ những người dùng có quyền truy cập sớm. Tuy nhiên, hầu hết các đánh giá 5 sao đều xuất phát từ các trường hợp sử dụng nhanh hoặc đơn giản hóa. Một nơi tốt để kiểm tra xem Gemini 1.5 sẽ hoạt động như thế nào trong thực tế nằm trong báo cáo kỹ thuật Gemini 1.5 của Google. Báo cáo cho thấy rằng ngay cả trong quá trình "thử nghiệm có kiểm soát", mô hình không thể truy xuất tất cả các chi tiết nhỏ của tài liệu trong kích thước cửa sổ ngữ cảnh của nó.

Cửa sổ ngữ cảnh 1 triệu token thực sự là một thành tựu kỹ thuật ấn tượng, nhưng nếu không thể truy xuất các chi tiết của tài liệu một cách đáng tin cậy thì cửa sổ ngữ cảnh lớn hơn sẽ có ít giá trị thực tế và thậm chí có thể trở thành nguyên nhân làm giảm độ chính xác và gây hiện tượng ảo giác.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài