Hệ thống thực tế tăng cường của Google ARCore đã đi qua giai đoạn beta với các tính năng mới. Ngoài ra, công cụ tìm kiếm hình ảnh trực quan Lens cũng sẽ trở thành một phần của Google Photos trên tất cả các điện thoại.

Hôm qua, ARCore 1.0 ra mắt trên tất cả điện thoại Google Pixel, tất cả những chiếc smartphone flagship của Samsung, bản Android O của LG V30 và V30 Plus, Asus ZemFone AR và OnePlus 5.

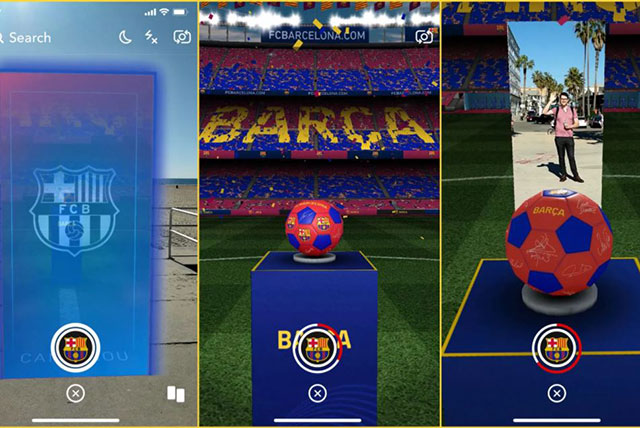

Bên cạnh các tính năng từ bản Preview, ARCore 1.0 sẽ hỗ trợ tạo điểm neo đồ vật ảo vào bề mặt có họa tiết chứ không chỉ bề mặt phẳng trơn. Google cho biết hiện tại có hơn 100 triệu máy Android hỗ trợ nền tảng này và họ cũng đang làm việc với 1 số công ty (Samsung, Huawei, LGE, Motorola, Asus, Xiaomi, HMD/Nokia, ZTE, Sony Mobile và Vivo) để có nhiều điện thoại hỗ trợ ARCore hơn.

Trước đây Lens chỉ có trên Pixel nhưng giờ có thể dùng tính năng này qua Google Photos trên Android và iOS 9 trở lên, hoặc qua Google Assistant trên một số điện thoại Android phân khúc cao cấp. Lens còn cải thiện khả năng nhận diện các loài động và thực vật phổ biến. Không chỉ xử lý được các hình ảnh được chụp bằng Photos, nếu dùng Assistant trên các điện thoại phân khúc cao cấp của Samsung, Huawei, LG, Motorola, Sony hay HMD/Nokia thì bạn chỉ cần mở điện thoại và giơ camera trước đồ vật cần tìm.

Lens giúp tìm kiếm bằng hình ảnh trực quan

ARCore ra mắt bản Preview hạn chế từ tháng 8/2017 còn Lens cũng xuất hiện sau đó vào tháng 10. Giám đốc sản phẩm tại Google Lens Aparna Chennapragada mô tả chúng là 2 mặt của một đồng xu. Lens là hệ thống “camera-in” giúp bạn hiểu thế giới hình ảnh còn ARCore là hệ thống “camera-out” để mở ra thế giới khác trên điện thoại. Lens là phần mở rộng của tìm kiếm bằng văn bản và giọng nói của Google còn ARCore cho phép nhà phát triển dễ dàng xây dựng các ứng dụng AR tượng tự ARKit của Apple cho iOS. ARKit mới hỗ trợ thêm mặt phẳng dọc và nhận diện hình ảnh nên cập nhật của Google có thể giúp 2 nền tảng AR di động này đuổi kịp nhau.

Tầm nhìn dài hạn cho ARCore và Lens khá thú vị. Theo Chennapragada, Google có thể dễ dàng kết nối “camera-in” và “camera’out” của Android. Ví dụ như khi thấy một món đồ nội thất, chụp ảnh lại để Google nhận diện và tự động tạo mô hình 3D. Cũng theo Chennapragada, ứng dụng khi kết hợp 2 công cụ này còn có thể mở rộng sang cả camera point-and-shoot Google VR180 để nhận diện đối tượng.

Hiện tại, cả Lens và ARCore vẫn còn đơn giản và hạn chế nhưng chỉ trong vài tuần tới thôi chúng ta sẽ thấy chúng trở nên phức tạp và phổ biến hơn nhiều.

Xem thêm:

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài