Nếu bạn đang tự hỏi tương lai phát triển của máy ảnh trên điện thoại sẽ như thế nào, sẽ được cải tiến ra sao và hoạt động tốt đến mức nào thì câu trả lời chính là nằm ở AI. Chắc hẳn trong thời gian gần đây bạn cũng không còn xa lạ gì với những câu quảng cáo kiểu: “Máy ảnh AI” hay “Camera tích hợp trí thông minh nhân tạo”... Bỏ qua một bên những sự cường điệu và chiêu trò marketing thì công nghệ AI trong vài năm qua đã thực sự đem lại những tiến bộ đáng kinh ngạc trong lĩnh vực nhiếp ảnh nói chung và chụp ảnh trên các thiết bị di động nói riêng. Tất nhiên AI cũng mới chỉ được ứng dụng trong nhiếp ảnh một thời gian ngắn, công nghệ này sẽ còn làm được rất nhiều điều thú vị nữa trong tương lai. Hãy cùng tìm hiểu xem AI đã, đang và sẽ tác động đến nhiếp ảnh như thế nào nhé!

AI và những lợi ích vượt bậc

Như đã nói, vẫn còn rất nhiều mánh lới quảng cáo xung quanh công nghệ này, tuy nhiên, những tiến bộ ấn tượng gần đây trong nhiếp ảnh trên điện thoại thông minh thực sự rất đáng ghi nhận, và diễn ra chủ yếu ở cấp độ phần mềm, thuật toán chứ không phải về cảm biến hay ống kính - và điều đó phần lớn nhờ vào ứng dụng của AI. Vậy AI đóng vai trò gì trong nhiếp ảnh? Câu trả lời là công nghệ này giúp máy ảnh trở nên thông minh hơn, cụ thể là những chiếc máy ảnh vô tri vô giác trước đây bây giờ sẽ được trang bị thêm trí tuệ nhân tạo để nắm bắt và phân tích được những sự vật mà nó sẽ chụp.

Google Photos đã cung cấp một minh chứng rõ ràng về sự kết hợp giữa AI và nhiếp ảnh sẽ mang lại hiệu quả mạnh mẽ như thế nào khi tung ra một ứng dụng máy ảnh AI vào năm 2015. Trước đó, gã khổng lồ nước Mỹ cũng đã sử dụng máy học để phân loại hình ảnh trên Google+ trong nhiều năm, nhưng việc ra mắt một ứng dụng chụp ảnh tích hợp trí tuệ nhân tạo đã mang lại hiệu quả cực kỳ to lớn, trong đó, đáng giá nhất chính là việc hàng ngàn bức ảnh chưa qua chỉnh sửa đã được phân tích, chọn lọc và chuyển đổi thành cơ sở dữ liệu có thể tìm kiếm một cách cực kỳ nhanh chóng. Lấy ví dụ đơn giản, bạn có một thư viện ảnh về mèo, bao gồm hàng trăm bức ảnh về nhiều loài mèo khác nhau, việc phân loại những bức ảnh mèo theo loài trước đây vô cùng khó khăn. Tuy nhiên với AI, mọi chuyện quá đơn giản, tất cả các chi tiết sẽ được AI phân tích, chọn lọc và phân loại với sai số rất thấp.

Ý tưởng này được Google sáng tạo và phát triển sau thương vụ mua lại DNNresearch vào năm 2013. Thời điểm đó, DNNresearch đã ấp ủ ý định thiết lập một mạng lưới deep neural được đào tạo về phân tích và phân loại dữ liệu, điều này được gọi là học tập có giám sát. Học tập có giám sát là một quá trình bao gồm việc đào tạo cho hệ thống AI bằng hàng triệu hình ảnh khác nhau, qua đó giúp AI có thể tìm kiếm manh mối trực quan ở cấp độ pixel nhằm xác định danh mục cũng như phân loại ảnh. Theo thời gian, thuật toán cũng ngày càng trở nên hiệu quả hơn trong việc nhận ra các vật thể trong một bức ảnh bởi nó đã “hấp thụ” đủ lượng dữ liệu cần thiết thông qua những bức ảnh đã được đào tạo trước đây. Ví dụ như nhận dạng được chú gấu trúc trong một bức ảnh dựa vào những dữ liệu về hình dáng và màu lông đã được đào tạo, hay phân tích được xem những con vật trong bức ảnh có xu hướng liên quan đến nhau ra sao nhằm mục đích xác định giống loài. Với việc đào tạo thêm cho AI, người ta có thể tìm kiếm được các thuật ngữ trừu tượng hơn, chẳng hạn như bức ảnh kia đang đề cập đến hoạt động gì… Có thể không có các chỉ số trực quan chung nhưng kết quả sẽ vẫn rõ ràng và chúng ta có thể hiểu được ngay lập tức.

Phải mất rất nhiều thời gian, công sức và sức mạnh xử lý để đào tạo một thuật toán như thế này, nhưng sau khi các trung tâm dữ liệu đã hoàn thành công việc của mình, thuật toán sẽ có thể được ứng dụng trên những thiết bị di động vốn có hiệu năng thấp hơn các trung tâm dữ liệu mà không gặp nhiều rắc rối. Cho đến thời điểm hiện tại, công việc nặng nhọc nhất đã được hoàn tất, và chúng ta là những người đang được hưởng thành quả. Bạn có thể thấy rằng khi ảnh của mình được tải lên đám mây, Google có thể sử dụng thuật toán AI của họ để phân tích và gắn nhãn bức ảnh đó theo mục, đồng thời cũng có thể sắp xếp toàn bộ thư viện của bạn một cách tự động. Khoảng một năm sau khi Google Photos được ra mắt, Apple cũng đã công bố một tính năng tìm kiếm ảnh dựa trên neural network được đào tạo theo cách tương tự, như là một phần trong cam kết bảo mật của công ty, do đó, việc phân loại thực tế được thực hiện trên từng bộ xử lý của thiết bị mà không tiến hành gửi dữ liệu. Quá trình này thường mất một hoặc hai ngày và diễn ra trong nền sau khi được thiết lập.

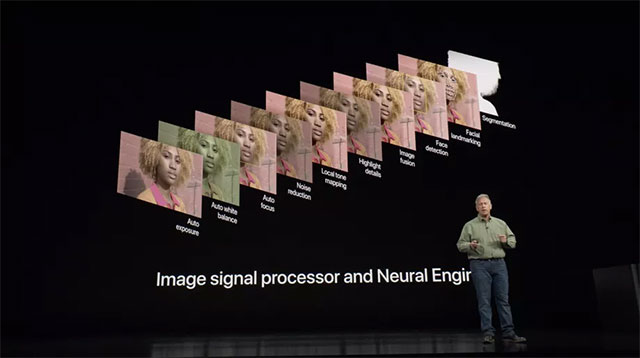

Phần mềm quản lý ảnh thông minh là một chuyện, nhưng AI và máy học được cho là những yếu tố có tác động lớn hơn đến bước đầu tiên trong việc phân loại một bức ảnh, đó chính là nhận diện sự vật trước khi chụp. Vâng, ống kính có thể được cải tiến để cho tốc độ nhanh hơn một chút, và các cảm biến có thể lớn hơn một chút, nhưng chúng ta sẽ vẫn phải đối mặt với những hạn chế về mặt không gian vật lý khi nhồi nhét một hệ thống quang học phức tạp vào các thiết bị di động vốn đang ngày càng đề cao đến yếu tố mỏng, nhẹ. Tuy nhiên, ngày nay, không có gì lạ khi một chiếc điện thoại chụp ảnh tốt hơn so với nhiều thiết bị máy ảnh chuyên dụng (tất nhiên là trong một số trường hợp), ít nhất là trước khi xử lý hậu kỳ. Đó là bởi vì các máy ảnh truyền thống tuy có lợi thế về ống kính hay cảm biến, nhưng lại không thể cạnh tranh được với máy ảnh di động về một số loại phần cứng khác mà cũng rất cần thiết trong nhiếp ảnh: Hệ thống trên chip chứa CPU, bộ xử lý tín hiệu hình ảnh và mới nhất là bộ xử lý thần kinh (neural processing unit - NPU).

Đây là yếu tố phần cứng được sử dụng trong một công nghệ mới gọi là nhiếp ảnh tính toán - một thuật ngữ bao quát mọi khái niệm, từ hiệu ứng trường sâu giả lập trong điện thoại ở chế độ chân dung (chụp xóa phông), cho đến các thuật toán giúp tăng chất lượng hình ảnh đến mức đáng kinh ngạc của Google Pixel. Tất nhiên, không phải tất cả các yếu tố trong nhiếp ảnh tính toán đều liên quan đến AI, nhưng AI chắc chắn là một thành phần quan trọng của công nghệ nhiếp ảnh mới này.

Apple đã tận dụng công nghệ này để điều khiển hệ thống camera kép trên iPhone vận hành ở chế độ chụp chân dung xóa phông. Bộ xử lý tín hiệu hình ảnh của iPhone sử dụng các kỹ thuật học máy để nhận dạng ra hình dáng của một người bằng một camera, trong khi camera thứ hai sẽ có nhiệm vụ tái tạo trường sâu để giúp cách ly “vật thể” được nhận dạng là người và làm mờ hậu cảnh. Thực ra khả năng nhận diện con người thông qua học máy không phải là công nghệ gì đó quá mới mẻ khi tính năng này đã được ra mắt lần đầu vào năm 2016, và nó cũng đã được ứng dụng từ lâu trên các công cụ phân loại ảnh. Nhưng quản lý được tính năng này trong thời gian thực với tốc độ phù hợp cho máy ảnh điện thoại thông minh là một bước đột phá lớn.

Rõ ràng Google vẫn là “nhà lãnh đạo” hay nói đúng hơn là kẻ dẫn dắt trong lĩnh vực này, và kết quả tuyệt vời được tạo ra trên cả ba thế hệ Google Pixel chính là bằng chứng thuyết phục nhất.

HDR +, chế độ chụp mặc định, sử dụng thuật toán phức tạp để hợp nhất nhiều khung hình thiếu sáng thành một để cải thiện độ sáng tổng thể của bức ảnh. Nhưng AI giờ đây còn có thể làm được nhiều hơn thế. Lợi thế của học máy chính là hệ thống chỉ có thể tốt hơn theo thời gian chứ không hề bị tụt lùi đi. Google đã đào tạo AI của mình bằng một bộ dữ liệu khổng lồ về các bức ảnh được gắn nhãn cụ thể, như với phần mềm Google Photos, và quá trình này vẫn đang được tiếp tục. Đặc biệt, Pixel 2 đã tạo ra một “mức chất lượng hình ảnh cơ bản” mới ấn tượng đến nỗi một số phóng viên còn cho rằng sử dụng Pixel 2 trong công việc của mình còn “sướng” hơn dùng DSLR.

Night Sight chính là minh chứng rõ ràng về vai trò quan trọng của phần mềm trong nhiếp ảnh

Với sự ra mắt của Night Sight (chụp ảnh trong bóng tối) cách đây vài tháng, Google đã một lần nữa khẳng định tầm quan trọng không thể bàn cãi của các thuật toán phần mềm trong nhiếp ảnh di động. Cụ thể, tính năng mới này trên Pixel sẽ kết hợp các dải phơi sáng dài lại với nhau và sử dụng thuật toán học máy để tính toán mức độ cân bằng trắng cũng như màu sắc chính xác hơn và kết quả thật đáng kinh ngạc. Tính năng này có thể được tìm thấy trên tất cả các thế hệ Pixel (ngay cả khi không có tính năng chống rung quang học), tuy nhiên, nó hoạt động tốt nhất trên Pixel 3 vì các thuật toán được thiết kế để tương thích với phần cứng gần mới nhất. Tóm lại, Google đã minh chứng cho cả thế giới thấy rằng phần mềm có thể thay đổi ngành công nghiệp nhiếp ảnh như thế nào, và nếu xét trên khía cạnh nhiếp ảnh di động thì phần mềm thậm chí còn quan trọng hơn phần cứng.

Tuy nhiên, vẫn còn chỗ cho phần cứng để tạo ra sự khác biệt, đặc biệt là khi nó được hỗ trợ bởi AI. Mẫu smartphone View 20 mới của Honor, cùng với Nova 4 của công ty mẹ Huawei, là những sản phẩm đầu tiên sử dụng cảm biến hình ảnh IMX586 của Sony - lớn hơn so với hầu hết các đối thủ cạnh tranh và cho chi tiết ảnh ở mức 48 megapixel, thể hiện độ phân giải cao chưa từng thấy trên bất kỳ chiếc điện thoại nào trước đây. Nhưng điều này có nghĩa là nhà sản xuất đang cố gắng nhồi nhét rất nhiều pixel nhỏ vào một không gian cũng nhỏ, có thể gây ra những vấn đề về chất lượng hình ảnh. Tuy nhiên, trong các thử nghiệm với View 20, chế độ Honor Ultra AI đã thể hiện sự vượt trội trong việc tận dụng tối đa độ phân giải của cảm biến, cũng như giải mã bộ lọc màu cảm biến khác thường để mở thêm chi tiết cho hình ảnh. Qua đó, chúng ta có thể sở hữu những bức ảnh khổng lồ được chụp bằng điện thoại di động.

Thông thường, bộ xử lý tín hiệu hình ảnh đóng vai trò rất quan trọng đối với hiệu suất camera của điện thoại, nhưng có vẻ như trong tương lai NPU sẽ đảm nhận vai trò lớn hơn khi những tiến bộ trong chụp ảnh tính toán được ứng dụng đại trà. Huawei là công ty đầu tiên công bố chip hệ thống với phần cứng AI chuyên dụng là Kirin 970, và sau đó là Apple A11 Bionic. Qualcomm, nhà cung cấp chip xử lý di động lớn nhất thế giới cũng đã biến máy học trở thành một trọng tâm lớn trong các sản phẩm của mình. Ngoài ra, Google cũng đã phát triển con chip riêng của mình có tên Pixel Visual Core, nhằm hỗ trợ cho các tác vụ về hình ảnh liên quan đến AI.

Chụp ảnh là một ứng dụng quan trọng, và xu hướng phát triển của thế giới smartphone chính là cải thiện khả năng chụp ảnh

Chip AI - loại phần cứng này sẽ ngày càng trở nên quan trọng đối với việc đảm bảo tính hiệu quả và khả năng vận hành của học máy trên các thiết bị di động có tính năng chụp ảnh bởi đơn giản để vận hành được học máy, sẽ có yêu cầu rất cao về mặt sức mạnh của bộ xử lý. Hãy nhớ rằng loại thuật toán cung cấp sức mạnh xử lý cho Google Photos đã được đào tạo trên các máy tính lớn, mạnh mẽ với GPU hiệu suất cao và lõi tenor trước khi được ứng dụng vào thư viện ảnh của bạn. Nhìn chung, khả năng thực hiện các tính toán học máy trên thiết bị di động trong thời gian thực vẫn còn là một công nghệ vượt trội.

Google đã cho thấy những ứng dụng ấn tượng có thể giảm bớt gánh nặng về khả năng xử lý khi vận hành học máy trên các thiết bị di động, trong khi các công cụ deep neural cũng đang ngày càng nhanh hơn qua từng năm. Dù mới chỉ ở giai đoạn phát triển ban đầu của nhiếp ảnh tính toán, nhưng đã có không ít lợi ích thực sự mà công nghệ này mang lại cho các hệ thống camera di động. Trên thực tế, trong số tất cả các khả năng và ứng dụng được đưa ra bởi làn sóng cường điệu hóa đối với AI trong vài năm qua, ứng dụng thực tế nhất của AI hiện nay chính là trong chụp ảnh. Máy ảnh là một tính năng thiết yếu của bất kỳ chiếc điện thoại nào và AI là công cụ tốt nhất để cải thiện khả năng chụp ảnh trên điện thoại, ít nhất là ở thời điểm hiện tại.

Xem thêm:

- Những mẫu smartphone 5G đáng chú ý nhất sẽ được ra mắt trong tháng 2, ai sẽ là kẻ dẫn dắt cuộc chơi?

- [Infographic] Công việc tương lai khi Trí tuệ nhân tạo dần thay thế con người

- AI đã tạo ra được những khuôn mặt như người thật, làm giả được xe cộ, nhà cửa và cả động vật

- Các nhà khoa học vừa tạo ra AI mạnh nhất thế giới, đánh bại các AI giỏi nhất về các môn cờ

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài