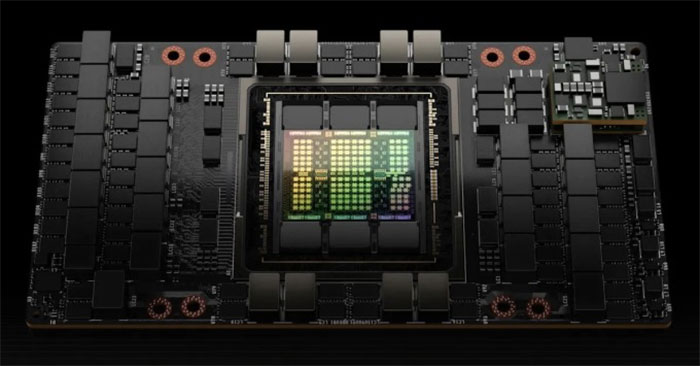

GPU H100 của Nvidia, công ty dẫn đầu về chip AI, luôn trong tình trạng khan hiếm hàng và đạt doanh số hàng triệu chiếc. Tuy nhiên, theo ước tính mức tiêu thụ điện năng của chip AI H100 tương đương với một thành phố lớn tại Mỹ hay một nước nhỏ ở châu Âu.

Paul Churnock, kỹ sư điện phụ trách chiến lược và quản trị kỹ thuật trung tâm dữ liệu tại Microsoft chia sẻ trên trang công nghệ Tom's Hardware rằng mỗi GPU H100 có công suất 700 W.

Churnock cho biết, với mức sử dụng hàng năm 61%, H100 tương đương mức tiêu thụ điện trung bình của một hộ gia đình ở Mỹ (2,51 người/hộ gia đình). Theo ước tính năm 2024 doanh số H100 đạt từ 1,5 đến 2 triệu GPU. So với mức tiêu thụ điện của dân cư tính theo thành phố, mức tiêu thụ điện năng của chip H100 đứng thứ năm, sau Houston, Texas, trước Phoenix, Arizona.

Mỗi năm một chip H100 sẽ ngốn khoảng 3.740 kWh. Dự kiến Nvidia bán 3,5 triệu GPU này trong hai năm 2023 và 2024, tức tổng mức tiêu thụ điện là 13.091 GWh, tương đương với mức tiêu thụ điện năng trung bình hàng năm tại một số nước như Georgia, Lithuania, Guatemala, khoảng 13.092 GWh.

Trước đó, vào tháng 10, theo thống kê của công ty Schneider Electric, tổng tiêu thụ điện năng của các trung tâm dữ liệu AI tạo sinh đã ngang bằng Cyprus.

Trong tương lai, Nvidia sẽ cho ra mắt nhiều dòng GPU mới như B100 Blackwell có thể còn cần nhiều điện hơn so với H100. Tuy nhiên, giới chuyên gia kỳ vọng các GPU AI thế hệ mới sẽ có hiệu suất làm việc hiệu quả hơn cho mỗi đơn vị năng lượng sử dụng.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài