Vision Pro mang đến silicon mới của Apple, chip R1, chuyên xử lý dữ liệu theo thời gian thực từ tất cả các cảm biến tích hợp. Nó chịu trách nhiệm theo dõi mắt, tay và đầu, hiển thị không bị lag môi trường của người dùng ở chế độ truyền qua video và các tính năng khác của visionOS.

R1 giảm tải gánh nặng xử lý từ bộ xử lý chính và tối ưu hóa hiệu suất. Hãy cùng khám phá cách thức hoạt động của chip Apple R1, so sánh với chip M2 và tìm hiểu các tính năng của Vision Pro mà nó hỗ trợ, v.v...

Chip R1 của Apple là gì? Nó hoạt động như thế nào?

Apple R1 xử lý luồng dữ liệu thời gian thực liên tục đến Vision Pro bằng 12 camera, 5 cảm biến và 6 micro.

Hai camera chính bên ngoài ghi lại thế giới của bạn, đẩy hơn một tỷ pixel lên màn hình 4K của headset mỗi giây. Ngoài ra, một cặp camera bên, cùng với hai camera gắn phía dưới và hai đèn chiếu sáng hồng ngoại, theo dõi chuyển động của tay từ nhiều vị trí khác nhau - ngay cả trong điều kiện ánh sáng yếu.

Các cảm biến hướng ra ngoài cũng bao gồm LiDAR Scanner và camera TrueDepth của Apple chụp bản đồ độ sâu của môi trường xung quanh bạn, cho phép Vision Pro định vị chính xác các đối tượng kỹ thuật số trong không gian của bạn. Ở bên trong, một vòng đèn LED xung quanh mỗi màn hình và hai camera hồng ngoại theo dõi chuyển động của mắt bạn, tạo cơ sở cho việc điều hướng của visionOS.

R1 được giao nhiệm vụ xử lý dữ liệu từ tất cả các cảm biến đó, bao gồm cả mọi đơn vị đo lường quán tính, với độ trễ không thể nhận thấy. Điều này cực kỳ quan trọng trong việc làm cho trải nghiệm không gian trở nên mượt mà và đáng tin cậy.

So sánh Apple R1 với M1 và M2

M1 và M2 là bộ xử lý đa năng được tối ưu hóa cho máy tính Mac. R1 là bộ đồng xử lý tiêu cự hẹp được thiết kế để hỗ trợ trải nghiệm AR mượt mà. Nó thực hiện công việc của mình nhanh hơn M1 hoặc M2, mang lại các đặc quyền như trải nghiệm không bị lag.

Lưu ý: Apple đã không chỉ định R1 có bao nhiêu lõi CPU và GPU cũng như không nêu chi tiết tần số CPU và RAM, khiến việc so sánh trực tiếp giữa R1, M1 và M2 trở nên khó khăn.

Các domain chính của R1 là theo dõi mắt và đầu, cử chỉ tay và lập bản đồ 3D thời gian thực thông qua cảm biến LiDAR. Giảm tải các hoạt động tính toán chuyên sâu đó cho phép M2 chạy những hệ thống con, thuật toán và ứng dụng khác nhau của VisionOS một cách hiệu quả.

Các tính năng chính trong chip R1 của Vision Pro

R1 có các khả năng chính sau:

- Xử lý nhanh: Các thuật toán chuyên dụng và xử lý tín hiệu hình ảnh trong R1 được tối ưu hóa để hiểu những đầu vào của cảm biến, camera và micro.

- Độ trễ thấp: Kiến trúc phần cứng được tối ưu hóa dẫn đến độ trễ rất thấp.

- Hiệu quả năng lượng: R1 xử lý một nhóm tác vụ cụ thể trong khi sử dụng năng lượng tối thiểu, nhờ kiến trúc bộ nhớ hiệu quả và quy trình sản xuất 5nm của TSMC.

Mặt khác, thiết kế chip kép của Vision Pro và sự tinh tế của R1 góp phần làm cho headset có giá cao và thời lượng pin kéo dài hai giờ.

R1 mang lại những lợi ích gì cho Vision Pro?

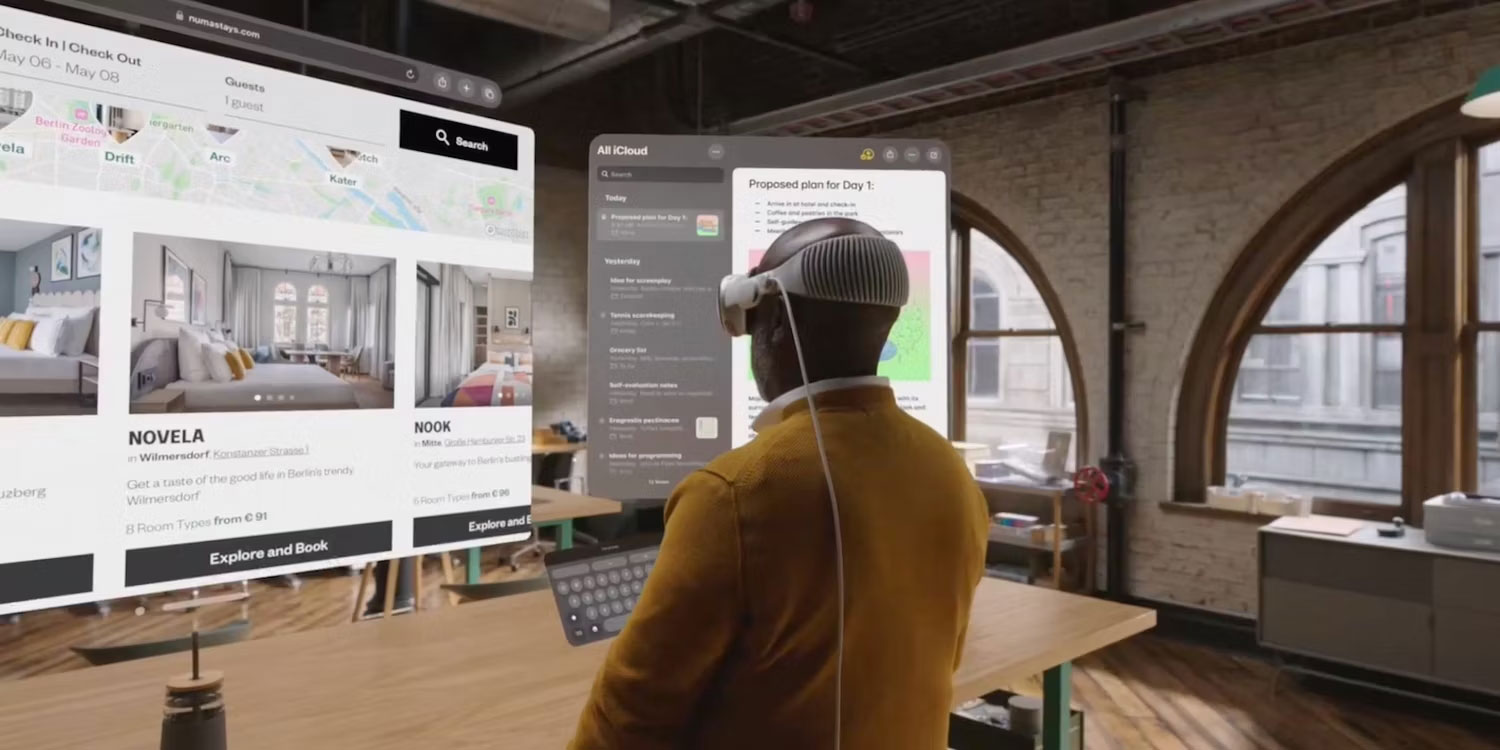

R1 cho phép theo dõi chính xác bằng các bộ phận mắt và tay "đang hoạt động". Ví dụ, để điều hướng visionOS, bạn hướng ánh nhìn của mình vào các nút và những yếu tố khác.

Vision Pro sử dụng cử chỉ tay để chọn mục, cuộn, v.v... Sự tinh tế và chính xác của việc theo dõi bằng mắt và tay đã cho phép các kỹ sư của Apple tạo ra một bộ headset thực tế hỗn hợp không cần bộ điều khiển vật lý.

Khả năng theo dõi chính xác và độ trễ tối thiểu của R1 cho phép các tính năng bổ sung, chẳng hạn như gõ trên bàn phím ảo. R1 cũng cung cấp khả năng theo dõi cử động đầu đáng tin cậy - rất quan trọng để tạo ra một bức tranh điện toán không gian xung quanh người dùng. Một lần nữa, độ chính xác là yếu tố then chốt ở đây - bạn muốn tất cả các đối tượng AR giữ nguyên vị trí của chúng bất kể bạn nghiêng và quay đầu như thế nào.

Nhận thức về không gian là một yếu tố khác góp phần vào trải nghiệm. R1 lấy dữ liệu độ sâu từ cảm biến LiDAR và camera TrueDepth, thực hiện lập bản đồ 3D thời gian thực. Thông tin độ sâu cho phép headset hiểu được môi trường của nó, chẳng hạn như tường và đồ nội thất.

Đổi lại, điều này rất quan trọng đối với sự bền bỉ của AR, đề cập đến vị trí cố định của các đối tượng ảo. Nó cũng giúp Vision Pro thông báo cho người dùng trước khi họ va phải vật thể, giúp giảm nguy cơ tai nạn trong các ứng dụng AR.

Cảm biến R1 Fusion giảm thiểu chứng say xe AR như thế nào?

Thiết kế chip kép của Vision Pro giảm tải quá trình xử lý cảm biến từ chip M2 chính, chạy ứng dụng và hệ điều hành visionOS.

Theo thông cáo báo chí của Vision Pro, R1 truyền hình ảnh từ camera bên ngoài đến màn hình bên trong trong vòng 12 mili giây, hoặc nhanh hơn 8 lần so với việc chớp mắt, giảm thiểu độ trễ.

Độ trễ đề cập đến thời gian chênh lệch giữa những gì camera nhìn thấy và hình ảnh hiển thị trên màn hình 4K của headset. Độ trễ càng ngắn thì càng tốt.

Chứng say xe xảy ra khi có độ trễ rõ rệt giữa thông tin đầu vào mà não bạn nhận được từ mắt và những gì tai trong của bạn cảm nhận được. Nó có thể xảy ra trong nhiều tình huống, kể cả trong công viên giải trí, trên thuyền hoặc du thuyền, trong khi sử dụng thiết bị VR, v.v...

VR có thể khiến mọi người phát ốm do xung đột cảm giác, dẫn đến các triệu chứng say tàu xe như mất phương hướng, buồn nôn, chóng mặt, nhức đầu, mỏi mắt, ngồi, nôn mửa, v.v...

VR cũng có thể gây hại cho mắt của bạn vì làm mỏi mắt, với các triệu chứng bao gồm đau hoặc ngứa mắt, xuất hiện bóng, đau đầu và đau cổ. Một số người có thể cảm thấy một hoặc nhiều triệu chứng như vậy trong vài giờ sau khi tháo headset ra.

Theo nguyên tắc thông thường, thiết bị VR phải refresh màn hình ít nhất 90 lần mỗi giây (FPS) và độ trễ màn hình phải dưới 20 mili giây để tránh làm cho người dùng xuất hiện triệu chứng say xe.

Với độ trễ đã nêu chỉ 12 mili giây, R1 giảm độ trễ xuống mức không thể nhận thấy. Mặc dù R1 giúp giảm thiểu ảnh hưởng của chứng say tàu xe, nhưng một số người thử nghiệm Vision Pro đã báo cáo các triệu chứng say xe sau khi đeo headset trong hơn 30 phút.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài