OpenAI đã phá vỡ hơn 20 hoạt động mạng độc hại có hành vi sử dụng chatbot AI ChatGPT để phát triển phần mềm độc hại, phát tán thông tin sai lệch, trốn tránh phát hiện và thực hiện các cuộc tấn công lừa đảo qua email. Đây cũng là lần đầu tiên OpenAI chính thức lên tiếng thừa nhận rằng công cụ AI chính thống của mình đang bị lạm dụng cho các hoạt động phát triển cũng như triển khai mã độc trên quy mô toàn cầu.

Tổ chức an ninh mạng độc lập Proofpoint đã báo cáo những dấu hiệu đầu tiên của hoạt động độc hại lạm dụng ChatGPT vào tháng 4, trong đó nghi ngờ mã độc TA547 (hay còn gọi là "Scully Spider") triển khai trình tải PowerShell do AI viết cho payload cuối cùng của chúng - Rhadamanthys info-stealer.

Tháng trước, các nhà nghiên cứu tại HP Wolf cũng đã phát đi cảnh báo với độ tin cậy cao rằng tội phạm mạng nhắm vào người dùng Pháp đang sử dụng các công cụ AI để viết các tập lệnh như một phần của chuỗi lây nhiễm nhiều bước.

Và như đã nói, cáo mới nhất của OpenAI đã chính thức xác nhận việc lạm dụng ChatGPT, nêu ra các trường hợp tác nhân đe dọa từ Trung Quốc và Iran lợi dụng công cụ này để nâng cao hiệu quả triển khai hoạt động độc hại.

Xu hướng lạm dụng ChatGPT trong các cuộc tấn công thực tế

Tác nhân đe dọa đầu tiên có hành vi lạm dụng ChatGPT mà OpenAI đã chỉ ra là 'SweetSpecter', một nhóm hacker Trung Quốc được các nhà phân tích của Cisco Talos phát hiện sớm nhất vào tháng 11 năm 2023. Đây một nhóm tin tặc theo hình thức gián điệp mạng, chủ yếu nhắm vào các chính phủ châu Á.

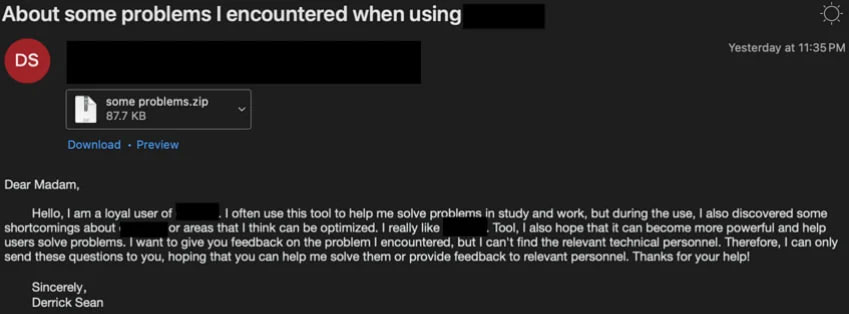

OpenAI báo cáo rằng SweetSpecter đã nhắm mục tiêu trực tiếp vào họ, gửi email lừa đảo có tệp đính kèm ZIP độc hại được ngụy trang dưới dạng yêu cầu hỗ trợ đến địa chỉ email cá nhân của nhân viên OpenAI. Nếu mở, các tệp đính kèm sẽ kích hoạt chuỗi lây nhiễm, khiến mã độc SugarGh0st RAT xâm nhập vào hệ thống của nạn nhân.

Sau khi điều tra sâu hơn, OpenAI phát hiện SweetSpector đang sử dụng một nhóm tài khoản ChatGPT thực hiện nghiên cứu phân tích lỗ hổng và viết tập lệnh với sự trợ giúp của công cụ LLM này.

Vụ việc thứ hai liên quan đến nhóm đe dọa 'CyberAv3ngers', được cho là có liên hệ với Lực lượng Vệ binh Cách mạng Hồi giáo Iran (IRGC). Nhóm này bị cáo buộc nhắm mục tiêu vào hệ thống công nghiệp tại các địa điểm cơ sở hạ tầng quan trọng của các nước phương Tây.

OpenAI báo cáo rằng các tài khoản liên quan đến nhóm đe dọa này đã yêu cầu ChatGPT tạo thông tin xác thực mặc định trong các Bộ điều khiển logic lập trình (PLC) được sử dụng rộng rãi, phát triển các tập lệnh bash và Python tùy chỉnh và làm tối nghĩa mã.

Nhóm tin tặc Iran cũng sử dụng ChatGPT để lập kế hoạch cho hoạt động sau khi xâm phạm, tìm hiểu cách khai thác các lỗ hổng cụ thể và chọn phương pháp để đánh cắp mật khẩu người dùng trên các hệ thống macOS.

Trường hợp thứ ba được nêu trong báo cáo của OpenAI liên quan đến Storm-0817, cũng là tác nhân đe dọa từ Iran. Nhóm này được cho là đã sử dụng ChatGPT để gỡ lỗi phần mềm độc hại, tạo trình thu thập dữ liệu Instagram, dịch hồ sơ LinkedIn sang tiếng Ba Tư và phát triển phần mềm độc hại tùy chỉnh cho nền tảng Android cùng với cơ sở hạ tầng chỉ huy và kiểm soát hỗ trợ.

Phần mềm độc hại được tạo ra với sự trợ giúp của chatbot của OpenAI có thể đánh cắp danh sách liên hệ, nhật ký cuộc gọi và các tệp được lưu trữ trên thiết bị, chụp ảnh màn hình, thu thập lịch sử duyệt web của nạn nhân và xác định vị trí chính xác của họ.

Mặc dù không có trường hợp nào được mô tả ở trên cung cấp cho các tác nhân đe dọa khả năng mới trong việc phát triển phần mềm độc hại, nhưng chúng chứng minh rằng các công cụ AI tạo ra có thể giúp các hoạt động tấn công trở nên hiệu quả hơn, hỗ trợ hacker trong mọi giai đoạn, từ lập kế hoạch đến thực hiện hoạt động độc hại.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài