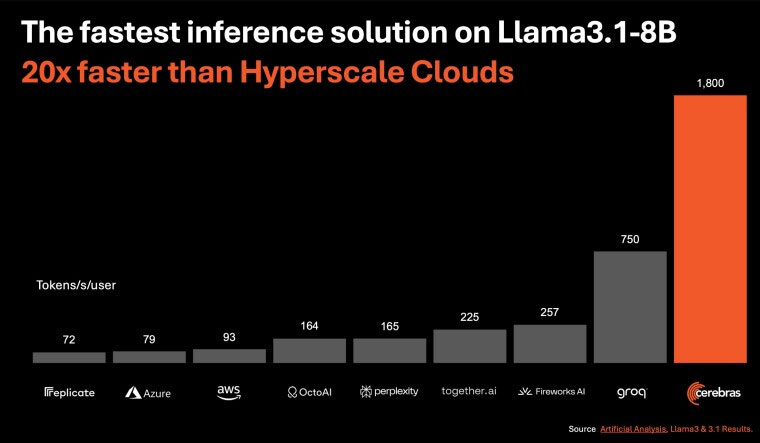

Cerebras Systems vừa chính thức công bố Cerebras Inference, được đánh giá là giải pháp suy luận AI nhanh nhất thế giới. Cerebras Inference này cung cấp hiệu suất lên tới 1.800 token mỗi giây cho mô hình Llama 3.1 8B (8 tỷ tham số) và 450 token mỗi giây cho Llama 3.1 70B, tức là nhanh hơn tới gần 20 lần so với các giải pháp suy luận AI dựa trên GPU NVIDIA có sẵn trong các đám mây quy mô siêu lớn hiện nay trên toàn thế giới, bao gồm cả Microsoft Azure.

Ngoài hiệu suất đáng kinh ngạc, giá dịch vụ của giải pháp suy luận mới này cũng rất rẻ, chỉ bằng một phần nhỏ so với các nền tảng đám mây GPU phổ biến. Ví dụ: Khách hàng có thể nhận được một triệu token chỉ với 10 cent, do đó cung cấp hiệu suất giá cao hơn 100 lần cho khối lượng công việc AI.

Độ chính xác 16 bit và tốc độ suy luận nhanh hơn 20 lần của Cerebras sẽ cho phép nhà phát triển xây dựng các ứng dụng AI hiệu suất cao thế hệ tiếp theo mà không phải quá lo lằng về tốc độ hoặc chi phí. Tỷ lệ giá thành/hiệu suất đột phá này có thể thực hiện được nhờ hệ thống Cerebras CS-3 và bộ xử lý AI Wafer Scale Engine 3 (WSE-3). CS-3 cung cấp băng thông bộ nhớ lớn hơn 7.000 lần so với Nvidia H100, giải quyết thách thức kỹ thuật về băng thông bộ nhớ của AI tạo sinh.

Cerebras Inference hiện khả dụng ở ba cấp độ sau:

- Gói miễn phí Free Tier cung cấp quyền truy cập API miễn phí và giới hạn sử dụng hào phóng cho bất kỳ ai đăng nhập.

- Gói Developer Tier được thiết kế để triển khai linh hoạt, không cần máy chủ, cung cấp cho người dùng điểm cuối API với chi phí chỉ bằng một phần nhỏ so với các giải pháp thay thế hiện có trên thị trường, với các mẫu Llama 3.1 8B và 70B có giá lần lượt chỉ là 10 cent và 60 cent cho một triệu token.

- Gói Enterprise Tier cung cấp các mô hình tinh chỉnh, thỏa thuận mức dịch vụ tùy chỉnh và hỗ trợ chuyên dụng. Lý tưởng cho khối lượng công việc liên tục, doanh nghiệp có thể truy cập Cerebras Inference thông qua đám mây riêng do Cerebras quản lý hoặc tại cơ sở của khách hàng.

Với hiệu suất kỷ lục, giá cả cạnh tranh và quyền truy cập API mở, Cerebras Inference đặt ra một tiêu chuẩn mới cho việc phát triển và triển khai LLM mở. Là giải pháp duy nhất có khả năng cung cấp cả đào tạo và suy luận tốc độ cao, Cerebras mở ra những khả năng hoàn toàn mới cho AI.

Trong bối cảnh xu hướng AI đang phát triển nhanh chóng, và NVIDIA hiện đang nắm giữ vị trí thống lĩnh trên thị trường, sự xuất hiện của các công ty như Cerebras và Groq báo hiệu một sự thay đổi tiềm năng trong động lực của toàn ngành. Khi nhu cầu về các giải pháp suy luận AI nhanh hơn và tiết kiệm chi phí hơn tăng lên, những giải pháp như Cerebras Inference đang ở vị thế tốt để nắm lấy cơ hội phá vỡ sự thống trị của NVIDIA, đặc biệt là trong lĩnh vực suy luận.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài