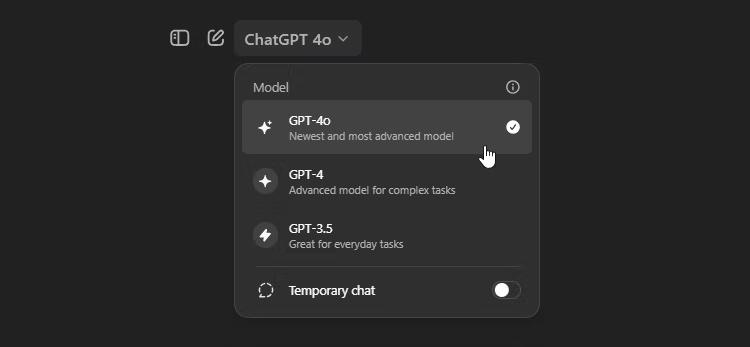

Với bản phát hành GPT-4o vào tháng 5 năm 2024 đi kèm với GPT-4 và GPT-4 Turbo, có thể bạn đang tự hỏi sự khác biệt giữa các mô hình AI này là gì - và bạn thực sự nên sử dụng mô hình ChatGPT nào.

Mặc dù các mô hình GPT-4 của OpenAI bắt đầu từ cùng một nền tảng, nhưng chúng có một số khác biệt đáng kể, nghĩa là chúng phù hợp hơn với một số tác vụ so với những tác vụ khác, chưa kể chi phí liên quan đến việc truy cập chúng.

Vậy sự khác biệt giữa các mô hình GPT-4 của OpenAI là gì?

Mục lục bài viết

So sánh GPT-4, GPT-4 Turbo và GPT-4o

Các mô hình GPT-4 của OpenAI bao gồm một số biến thể, mỗi biến thể được thiết kế để đáp ứng những nhu cầu khác nhau. Dưới đây là tổng quan về sự khác biệt giữa GPT-4, GPT-4 Turbo và GPT-4o (Omni).

GPT-4

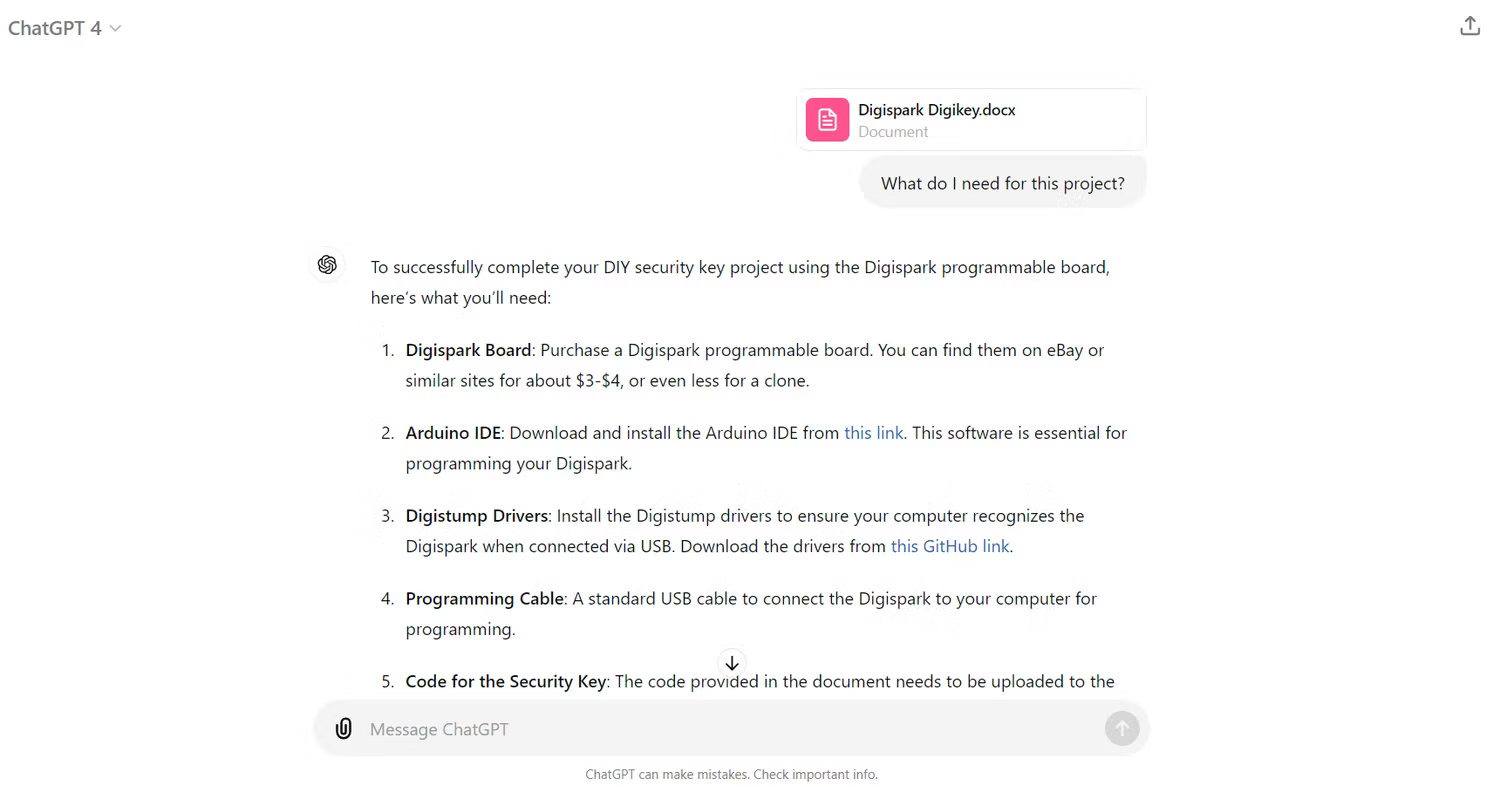

GPT-4 là mô hình nền tảng. Nó hiểu và tạo ra các câu phức tạp, hữu ích cho nhiều ứng dụng, chẳng hạn như viết sáng tạo, phân tích dữ liệu, dịch ngôn ngữ và tạo code. Với cửa sổ ngữ cảnh 23.000 - 25.000 từ của GPT-4, bạn cũng có thể đính kèm nhiều tài liệu dài và yêu cầu chúng trả lời bất kỳ truy vấn nào về file đã upload của mình. Vì đây là mô hình cơ sở của dòng sản phẩm này nên bạn cũng có thể truy cập tất cả các tính năng hữu ích của GPT -4 trên cả GPT-4 Turbo và GPT-4o.

GPT-4 Turbo

GPT-4 Turbo được xây dựng dựa trên khả năng của GPT -4 bằng cách tập trung vào hiệu quả và tiết kiệm chi phí. Nó mang lại thời gian phản hồi nhanh hơn nhờ hiệu quả tính toán được cải thiện, khiến nó phù hợp với những người dùng cần kết quả đầu ra nhanh hơn. Ngoài ra, GPT-4 Turbo vượt trội về độ chính xác, đặc biệt là trong các vấn đề toán học, vượt trội so với GPT-4 ở nhiều benchmark khác nhau. Mô hình này cũng giới thiệu các tính năng nâng cao như chế độ JSON và gọi hàm song song, góp phần tạo ra kết quả đầu ra mạnh mẽ và có thể tái tạo hơn.

GPT-4o

GPT-4o ("o" là viết tắt của "omni") là phiên bản bổ sung mới nhất cho dòng mô hình GPT-4 và là mô hình mặc định được chọn cho cả người dùng ChatGPT Free và Plus. Model này thông minh và nhanh gấp đôi GPT-4 Turbo, khiến nó trở nên lý tưởng cho các ứng dụng thời gian thực. GPT-4o cũng là mô hình đa phương thức đầu tiên trong dòng sản phẩm này, có khả năng phân tích tất cả các loại định dạng file như văn bản, âm thanh, hình ảnh và video, đồng thời có thể tạo tất cả văn bản và hình ảnh trong ChatGPT.

Ngoài ra, OpenAI đã cho phép người dùng cấp miễn phí quyền truy cập GPT-4o có giới hạn, ở mức 16 message cứ sau 3 giờ. Sau đó, ChatGPT sẽ quay lại sử dụng GPT-3.5.

Dưới đây là thông tin chi tiết về từng mô hình GPT-4:

| Tính năng | GPT-4 | GPT-4 Turbo | GPT-4o |

|---|---|---|---|

Giá cả (ChatGPT) | $20 | $20 | Miễn phí (16 message mỗi 3 giờ), $20 (80 message mỗi 3 giờ) |

Tốc độ phản hồi | Tiêu chuẩn | Nhanh hơn 2 lần so với GPT-4 | Nhanh hơn 4 lần so với GPT-4 |

Cửa sổ ngữ cảnh | Lên tới 32k token | Lên tới 32k token | Lên tới 32k token |

Đầu vào/Đầu ra đa phương thức | Không | Không | Có |

MMLU | 86.3 | 86.5 | 88.7 |

GPTQA | 48.0 | 35.7 | 53.6 |

MATH | 42.5 | 72.6 | 76.6 |

HumanEval | 67.0 | 87.1 | 90.2 |

Ngoài chi phí, thời gian phản hồi và khoảng thời gian ngữ cảnh, bài viết cũng đã thêm benchmark về độ chính xác cho từng mô hình để giúp so sánh độ chính xác trong nhiều tác vụ khác nhau. Các bài kiểm tra benchmark bao gồm MMLU để kiểm tra kiến thức học thuật, GPQA để đánh giá kiến thức tổng quát, HumanEval để đánh giá khả năng viết code của mô hình và MATH để giải các bài toán. Trong mỗi bài test, điểm càng cao càng tốt.

GPT-4o khác với GPT-4 Turbo như thế nào?

GPT-4o là một mẫu flagship "tất cả trong một" có khả năng xử lý các đầu vào và đầu ra đa phương thức độc lập như một mạng nơ-ron duy nhất. Với các mẫu trước đó như GPT-4 Turbo và GPT-3.5, người dùng sẽ cần API OpenAI và những mô hình hỗ trợ khác để nhập và tạo ra các loại nội dung đa dạng. Mặc dù GPT-4 Turbo có thể xử lý prompt hình ảnh, nhưng nó không thể xử lý âm thanh nếu không có sự hỗ trợ của API.

Bản chất đa phương thức của GPT-4o là bước đột phá lớn nhất so với GPT-4 Turbo và là nền tảng cho nhiều cải tiến của nó:

- Hội thoại âm thanh thời gian thực

- Khả năng điều chỉnh giọng nói

- Xử lý video tích hợp

- Tạo hình ảnh

- Hiệu suất token cao hơn

Hội thoại âm thanh thời gian thực

Tốc độ nhanh hơn và khả năng đa phương thức của GPT-4o cho phép nó tham gia vào cuộc trò chuyện và dịch ngôn ngữ với tốc độ giống con người hơn GPT-4 Turbo. Trong video demo giới thiệu sản phẩm, ChatGPT-4o đã được trình chiếu với khả năng dịch theo thời gian thực giữa người nói tiếng Anh và tiếng Tây Ban Nha. GPT-4o hỗ trợ giọng nói chatbot với hơn 50 ngôn ngữ.

Vì có thể tự xử lý dữ liệu âm thanh đầu vào, GPT-4o có độ trễ thấp hơn - thời gian cần thiết để tạo ra đầu ra kể từ khi nhận được dữ liệu - so với các mô hình trước đó. Nó phản hồi dữ liệu âm thanh đầu vào trong 320 mili giây, tương đương với thời gian phản hồi thông thường của con người là 210 mili giây.

Các phiên bản trước của GPT-4 yêu cầu nhiều mô hình được lắp ráp trong một pipeline để cung cấp dịch vụ tương tự, làm tăng độ trễ lên 5,4 giây. Trước GPT-4o, API Whisper của OpenAI đã chuyển đổi prompt âm thanh thành văn bản, đưa chúng vào GPT-4 Turbo, sau đó các dịch vụ chuyển văn bản thành giọng nói (TTS) chuyển đổi phản hồi của GPT trở lại thành âm thanh.

Nhìn chung, GPT-4 Turbo cũng là một mô hình chậm hơn. Trong các bài kiểm tra benchmark của tổ chức đánh giá AI Artificial Analysis, GPT-4o đã chứng minh tốc độ 110 token mỗi giây, nhanh hơn khoảng 3 lần so với GPT-4 Turbo. Trong cùng bài kiểm tra, GPT-4o cũng vượt trội hơn nhiều đối thủ cạnh tranh, bao gồm Claude 3 Opus và Gemini 1.5 Pro.

Khả năng xử lý giọng nói

Pipeline Whisper–GPT–TTS trước đây có nghĩa là khi xử lý đầu vào âm thanh, GPT-4 Turbo chỉ nhận được bản ghi văn bản của những gì đang được nói. Bản ghi này cô lập nội dung được người dùng nói, đồng thời lọc bỏ tiếng ồn nền, danh tính người nói và giọng nói, khiến GPT không thu thập được nhiều dữ liệu ngữ cảnh.

Là một mô hình đa phương thức, GPT-4o có thể xử lý toàn bộ đầu vào âm thanh và phản hồi phù hợp với ngữ cảnh bổ sung này. Công nghệ xử lý ngôn ngữ tự nhiên (NLP) được cải tiến cho phép nó đưa cảm xúc, giọng điệu và nội dung cảm xúc vào đầu ra khi được sử dụng ở chế độ giọng nói.

Xử lý video tích hợp

GPT-4o xử lý đầu vào hình ảnh và video bên cạnh văn bản và âm thanh. GPT-4o có thể kết nối với nguồn cấp dữ liệu camera trực tiếp hoặc ghi lại màn hình của người dùng, sau đó mô tả những gì nó nhìn thấy và trả lời các câu hỏi. Người dùng có thể bật camera trên điện thoại thông minh và trò chuyện với ChatGPT-4o giống như cách họ nói chuyện với bạn bè hoặc đồng nghiệp.

Trước đây, API GPT-4 Vision cho phép GPT-4 Turbo phân tích nội dung trực quan.

Tạo hình ảnh

Theo tuyên bố phát hành của OpenAI, GPT-4o cung cấp khả năng tạo hình ảnh độc lập. GPT-4 Turbo chỉ có thể tạo hình ảnh bằng cách kết nối với mô hình DALL-E 3 của OpenAI. GPT-4 Turbo sẽ đưa ra prompt người dùng bằng văn bản, sau đó DALL-E sẽ tạo hình ảnh.

Hiệu quả token cao hơn

OpenAI đã cải thiện khả năng token hóa của GPT-4 với GPT-4o. Token hóa là quá trình các LLM chuyển đổi từ ngữ thành dữ liệu. Mỗi token đại diện cho một từ trọn vẹn hoặc một phần của từ đó và dấu câu. Các mô hình AI chuyển đổi từ ngữ thành token, sau đó áp dụng toán học phức tạp để phân tích dữ liệu đó.

GPT-4o chuyển đổi các ngôn ngữ không phải chữ La Mã, chẳng hạn như tiếng Trung, tiếng Hindi và tiếng Ả Rập, thành token hiệu quả hơn nhiều so với những phiên bản trước. Do OpenAI tính phí người dùng API cho mỗi token đầu vào hoặc đầu ra, hiệu quả được cải thiện của GPT-4o trong các chữ viết không phải chữ La Mã giúp tiết kiệm chi phí hơn cho những trường hợp sử dụng trong các ngôn ngữ đó.

Nên sử dụng mô hình GPT-4 nào?

Việc lựa chọn model phù hợp tùy thuộc vào nhu cầu cụ thể và tính chất công việc bạn định thực hiện.

GPT-4o là mô hình mạnh nhất trong dòng sản phẩm. Nó có điểm chính xác cao nhất trong tất cả các bài kiểm tra benchmark và có thể sẽ hoạt động tốt nhất trong mọi tương tác. Tuy nhiên, số lượng message bạn có thể gửi GPT-4o bị hạn chế, đặc biệt đối với người dùng cấp miễn phí. Hạn chế này là lý do chính tại sao vẫn nên nâng cấp lên ChatGPT Plus. Tuy nhiên, tốt nhất nên dành việc sử dụng GPT-4o cho các tương tác yêu cầu đầu vào và đầu ra đa phương thức hoặc khi cần độ chính xác tối đa. GPT-4 và GPT-4 Turbo chỉ khả dụng cho người dùng ChatGPT Plus. Nếu đã có tài khoản Plus, việc sử dụng GPT-4 Turbo trong tất cả các tương tác ChatGPT sẽ có ý nghĩa hơn trừ khi bạn yêu cầu GPT-4o.

Tuy nhiên, GPT-4 Turbo hiện không khả dụng trong ChatGPT mặc dù nó được cung cấp vào ngày 12 tháng 4 năm 2024. Điều này có nghĩa là bạn sẽ phải sử dụng mô hình GPT-4 cho hầu hết các tác vụ và sử dụng GPT-4o cho những tác vụ phức tạp hơn cho đến khi OpenAI cung cấp GPT-4 Turbo trở lại.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài