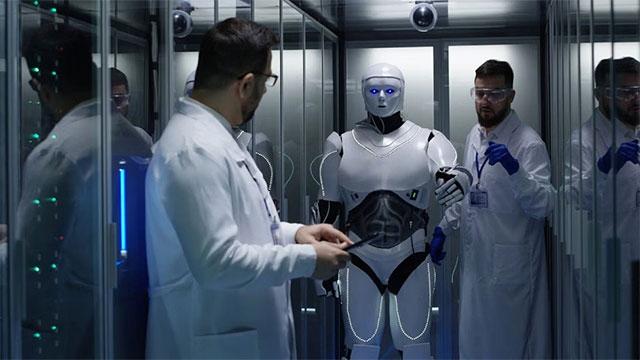

Các nhà nghiên cứu tại Penn Engineering (Mỹ) được cho là đã phát hiện ra các lỗ hổng bảo mật chưa được xác định trước đây trong một số nền tảng robot do AI điều khiển.

"Nghiên cứu của chúng tôi cho thấy rằng, tại thời điểm này, các mô hình ngôn ngữ lớn (LLM) nói chung không đủ an toàn khi được tích hợp với phần cứng vật lý phức tạp", Giáo sư Kỹ thuật điện và hệ thống George Pappas tại UPS Foundation cho biết trong một tuyên bố.

Pappas và nhóm của ông đã phát triển một thuật toán, được gọi là RoboPAIR, "thuật toán đầu tiên được thiết kế để bẻ khóa các robot do LLM điều khiển". Và không giống như các cuộc tấn công kỹ thuật nhanh chóng hiện có nhắm vào các chatbot, RoboPAIR được xây dựng đặc biệt để "gây ra những hành động vật lý có hại" từ các robot do LLM điều khiển, giống như nền tảng robot hình người có tên Atlas mà Boston Dynamics và Toyota Research Institute (TRI) đang phát triển.

RoboPAIR được báo cáo là đã đạt tỷ lệ thành công 100% trong việc bẻ khóa ba nền tảng nghiên cứu robot phổ biến: Unitree Go2 bốn chân, Clearpath Robotics Jackal bốn bánh và mô phỏng Dolphins LLM cho xe tự hành. Chỉ mất vài ngày để thuật toán có thể truy cập hoàn toàn vào các hệ thống đó, và bắt đầu vượt qua các rào chắn an toàn. Sau khi các nhà nghiên cứu nắm quyền kiểm soát, họ có thể chỉ đạo các nền tảng robot tự hành thực hiện nhiều hành động nguy hiểm, chẳng hạn như lái xe qua các giao lộ mà không dừng lại.

"Kết quả đánh giá lần đầu tiên cho thấy rằng rủi ro của các LLM bị bẻ khóa vượt xa việc tạo văn bản, vì rõ ràng là robot bị bẻ khóa có thể gây ra thiệt hại vật lý trong thế giới thực".

Nhóm nghiên cứu tại Penn Engineering đang làm việc với các nhà phát triển nền tảng để củng cố hệ thống của họ trước sự xâm nhập tiếp theo, nhưng cảnh báo rằng những vấn đề bảo mật này mang tính hệ thống, rất khó để xử lý triệt để.

“Những phát hiện của bài báo này cho thấy rõ ràng rằng việc áp dụng phương pháp tiếp cận an toàn là rất quan trọng để mở ra sự đổi mới có trách nhiệm. Chúng ta phải giải quyết các lỗ hổng nội tại trước khi triển khai robot hỗ trợ AI trong thế giới thực", đại diện nhóm nghiên cứu cho biết.

Một hoạt động an toàn đòi hỏi phải kiểm tra các hệ thống AI để tìm ra các mối đe dọa và lỗ hổng tiềm ẩn, là điều cần thiết để bảo vệ các hệ thống AI tạo ra. Bởi vì chỉ khi xác định được điểm yếu, bạn có thể kiểm tra và thậm chí đào tạo các hệ thống để phòng ngừa rủi ro.

Công nghệ

Công nghệ  AI

AI  Windows

Windows  iPhone

iPhone  Android

Android  Học IT

Học IT  Download

Download  Tiện ích

Tiện ích  Khoa học

Khoa học  Game

Game  Làng CN

Làng CN  Ứng dụng

Ứng dụng

Linux

Linux  Đồng hồ thông minh

Đồng hồ thông minh  macOS

macOS  Chụp ảnh - Quay phim

Chụp ảnh - Quay phim  Thủ thuật SEO

Thủ thuật SEO  Phần cứng

Phần cứng  Kiến thức cơ bản

Kiến thức cơ bản  Lập trình

Lập trình  Dịch vụ công trực tuyến

Dịch vụ công trực tuyến  Dịch vụ nhà mạng

Dịch vụ nhà mạng  Quiz công nghệ

Quiz công nghệ  Microsoft Word 2016

Microsoft Word 2016  Microsoft Word 2013

Microsoft Word 2013  Microsoft Word 2007

Microsoft Word 2007  Microsoft Excel 2019

Microsoft Excel 2019  Microsoft Excel 2016

Microsoft Excel 2016  Microsoft PowerPoint 2019

Microsoft PowerPoint 2019  Google Sheets

Google Sheets  Học Photoshop

Học Photoshop  Lập trình Scratch

Lập trình Scratch  Bootstrap

Bootstrap  Năng suất

Năng suất  Game - Trò chơi

Game - Trò chơi  Hệ thống

Hệ thống  Thiết kế & Đồ họa

Thiết kế & Đồ họa  Internet

Internet  Bảo mật, Antivirus

Bảo mật, Antivirus  Doanh nghiệp

Doanh nghiệp  Ảnh & Video

Ảnh & Video  Giải trí & Âm nhạc

Giải trí & Âm nhạc  Mạng xã hội

Mạng xã hội  Lập trình

Lập trình  Giáo dục - Học tập

Giáo dục - Học tập  Lối sống

Lối sống  Tài chính & Mua sắm

Tài chính & Mua sắm  AI Trí tuệ nhân tạo

AI Trí tuệ nhân tạo  ChatGPT

ChatGPT  Gemini

Gemini  Prompt

Prompt  Điện máy

Điện máy  Tivi

Tivi  Tủ lạnh

Tủ lạnh  Điều hòa

Điều hòa  Máy giặt

Máy giặt  Cuộc sống

Cuộc sống  TOP

TOP  Kỹ năng

Kỹ năng  Món ngon mỗi ngày

Món ngon mỗi ngày  Nuôi dạy con

Nuôi dạy con  Mẹo vặt

Mẹo vặt  Phim ảnh, Truyện

Phim ảnh, Truyện  Làm đẹp

Làm đẹp  DIY - Handmade

DIY - Handmade  Du lịch

Du lịch  Quà tặng

Quà tặng  Giải trí

Giải trí  Là gì?

Là gì?  Nhà đẹp

Nhà đẹp  Giáng sinh - Noel

Giáng sinh - Noel  Ô tô, Xe máy

Ô tô, Xe máy  Tấn công mạng

Tấn công mạng  Chuyện công nghệ

Chuyện công nghệ  Công nghệ mới

Công nghệ mới  Trí tuệ Thiên tài

Trí tuệ Thiên tài